RAID (Redundant Array of lndependent Disk 独立冗余磁盘阵列)就是把多块独立的物理磁盘按不同的方式组合起来形成一个磁盘组(逻辑硬盘)。从而提供比单个磁盘更高的存储性能和提供数据备份技术。

RAID 0,RAID 1,RAID 5,RAID 10

| 容错性 | 无 | 冗余类型 | 无 |

|---|---|---|---|

| 热备盘 | 无 | 读性能 | 高 |

| 随机写性能 | 高 | 连续写性能 | 高 |

| 需要的磁盘数 | 1+N | 可用容量 | N* |

| 容错性 | 有 | 冗余类型 | 镜像 |

|---|---|---|---|

| 热备盘 | 有 | 读性能 | 低(与单块磁盘一样) |

| 随机写性能 | 低 | 连续写性能 | 低 |

| 需要的磁盘数 | 2*N(N 代表磁盘数量) | 可用容量 | N/2 |

| 容错性 | 有 | 冗余类型 | 奇偶校验信息存储 |

|---|---|---|---|

| 热备盘 | 有 | 读性能 | 高(与RAID0 相近) |

| 随机写性能 | 较低 | 连续写性能 | 较低 |

| 需要的磁盘数 | 大于等于 3 | 可用容量 | N - 1 |

| 容错性 | 有 | 冗余类型 | 镜像 |

|---|---|---|---|

| 热备盘 | 有 | 读性能 | 高(与 RAID0 相近) |

| 随机写性能 | 低 | 连续写性能 | 低 |

| 需要的磁盘数 | N*2(N 需要大于等于 2) | 可用容量 | N/2 |

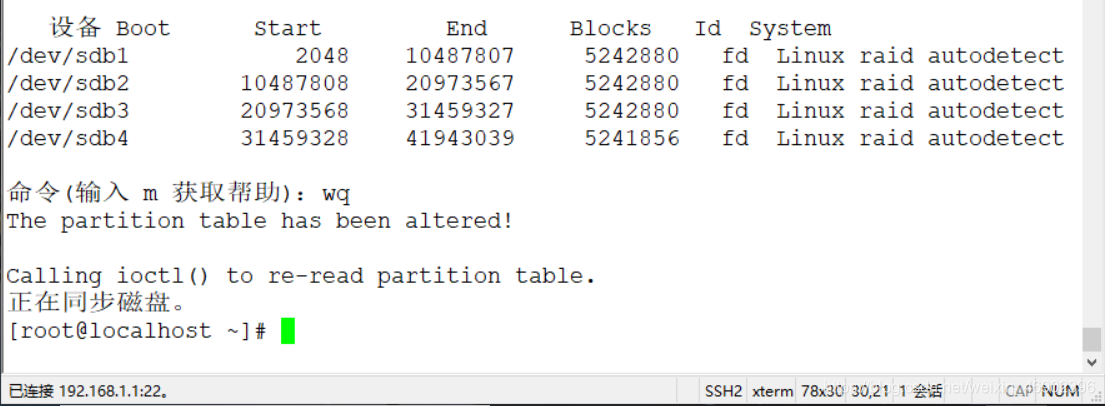

[root@localhost ~]# fdisk /dev/sdb

n #创建分区

p #创建普通分区

回车

回车

+5G #分配5G内存

t #更改分区类型为RAID类型 (只是为了方便记住)

回车

fd #fd类型就是RAID

以上步骤依次类推,配置其它分区也是如此

使用 partprobe 命令同步分区情况

[root@localhost ~]# partprobe

[root@localhost ~]# yum -y install mdadm #安装RAID管理工具

[root@localhost ~]# mdadm -C /dev/md0 -a yes -l 0 -n 2 /dev/sdb1 /dev/sdc1

注解:

| 选项 | 全称 | 作用 |

|---|---|---|

| -C | --create | 创建阵列 |

| -a | --auto | 同意创建设备 |

| -l | --level | 阵列模式 |

| -n | --reid-devices | 阵列中活动磁盘的数目 |

| -x | --spare-devices=N | 表示当前阵列中热备盘有 N 块(自定义 N 数量即可) |

| -S | --stop | 关闭阵列(关闭前需先取消挂载) |

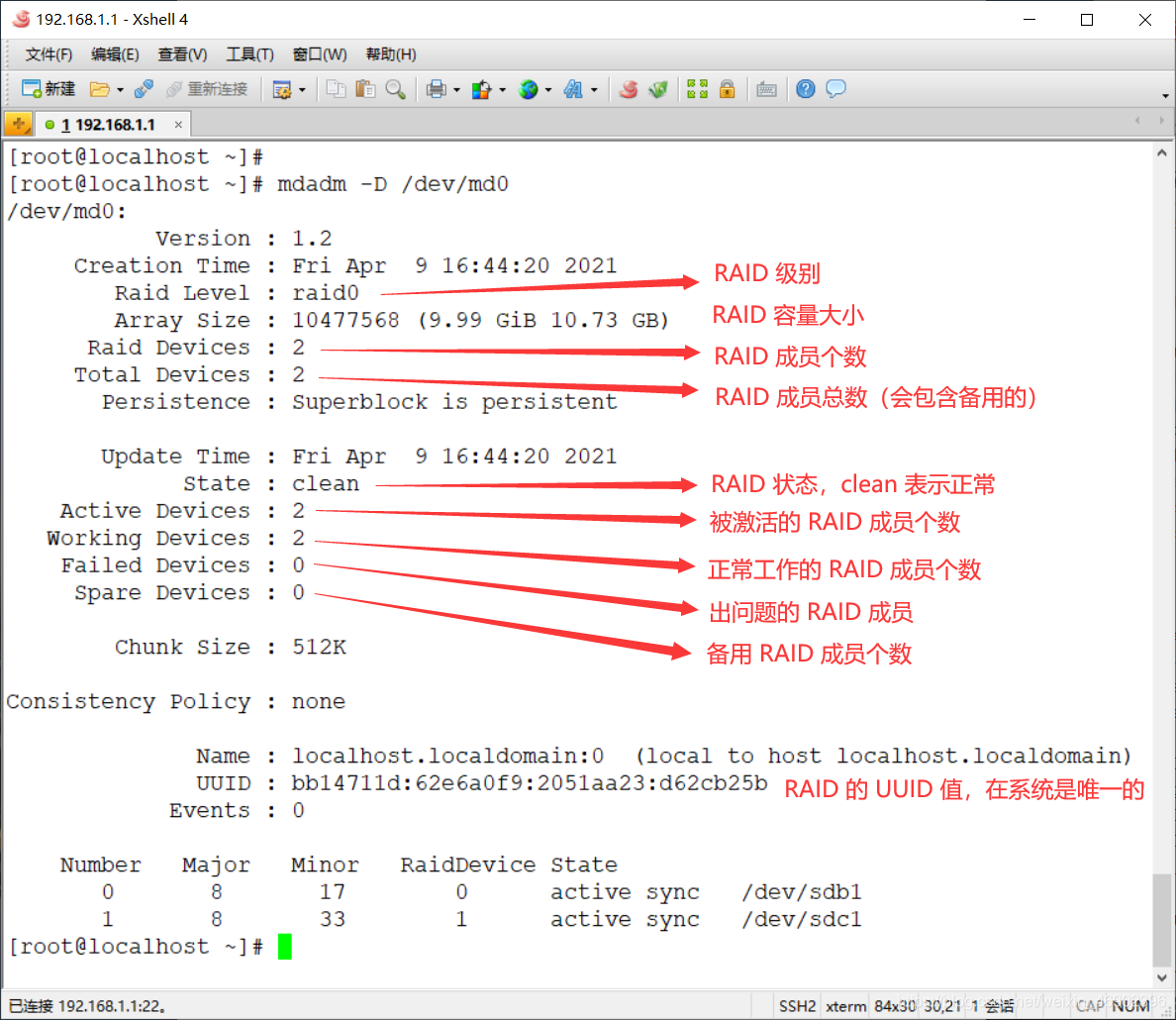

1)查看 RAID0 状态

[root@localhost ~]# cat /proc/mdstat #查看概要信息

[root@localhost ~]# mdadm -D /dev/md0 #查看更详细的信息

注解:

clean 表示正常,degraded 表示有问题,recovering 表示正在恢复或构建)2)创建 mdadm 配置文件

[root@localhost ~]# echo "DEVICE /dev/sdb1 /dev/sdc1" > /etc/mdadm.conf #指定软 RAID 设备

[root@localhost ~]# mdadm -Ds /dev/md0 >> /etc/mdadm.conf #将 RAID0 的 UUID 追加到该目录

3)格式化磁盘阵列

[root@localhost ~]# mkfs.xfs /dev/md0 #格式化为 xfs 文件系统

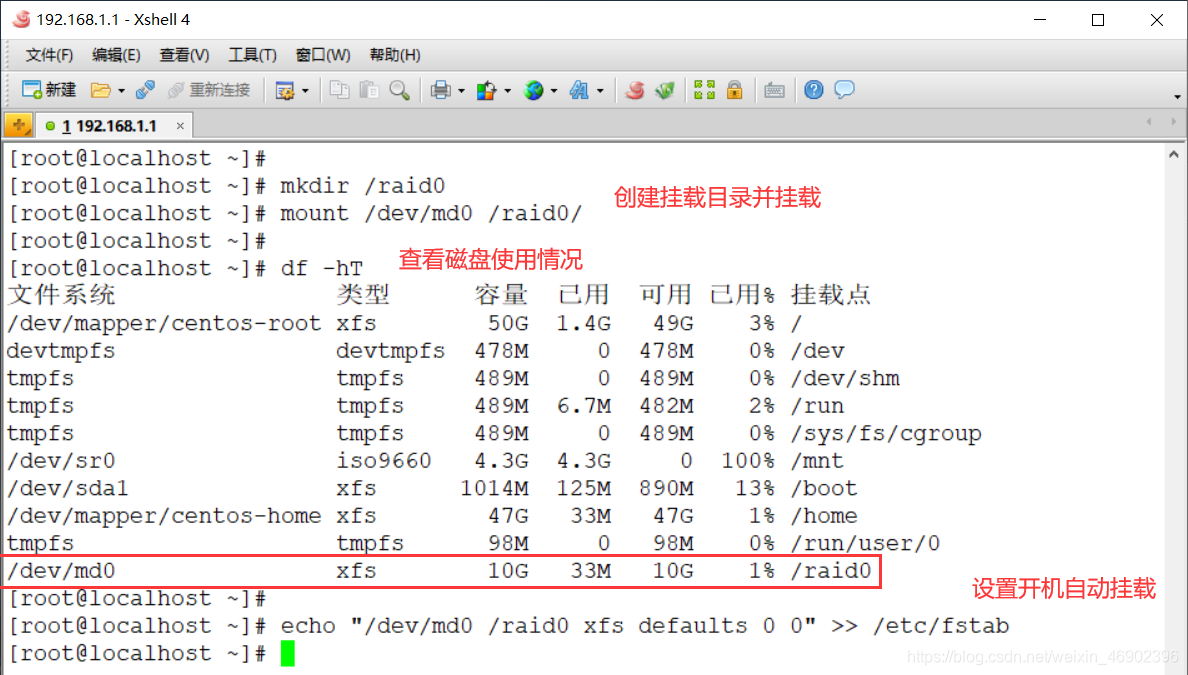

4)建立挂载点并挂载

[root@localhost ~]# mkdir /raid0 #创建挂载点

[root@localhost ~]# mount /dev/md0 /raid0/ #挂载

[root@localhost ~]# df -hT #查看磁盘使用情况

[root@localhost ~]# echo "/dev/md0 /raid0 xfs defaults 0 0" >> /etc/fstab

5)验证 RAID0 是否开机自动挂载

[root@localhost ~]# reboot #重启

[root@localhost ~]# df -hT #查看磁盘使用情况

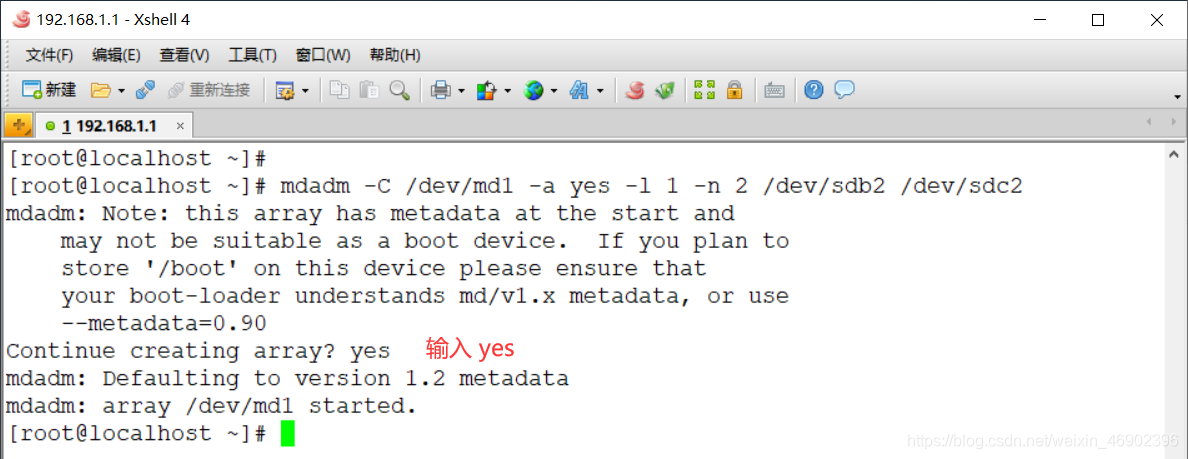

[root@localhost ~]# mdadm -C /dev/md1 -a yes -l 1 -n 2 /dev/sdb2 /dev/sdc2

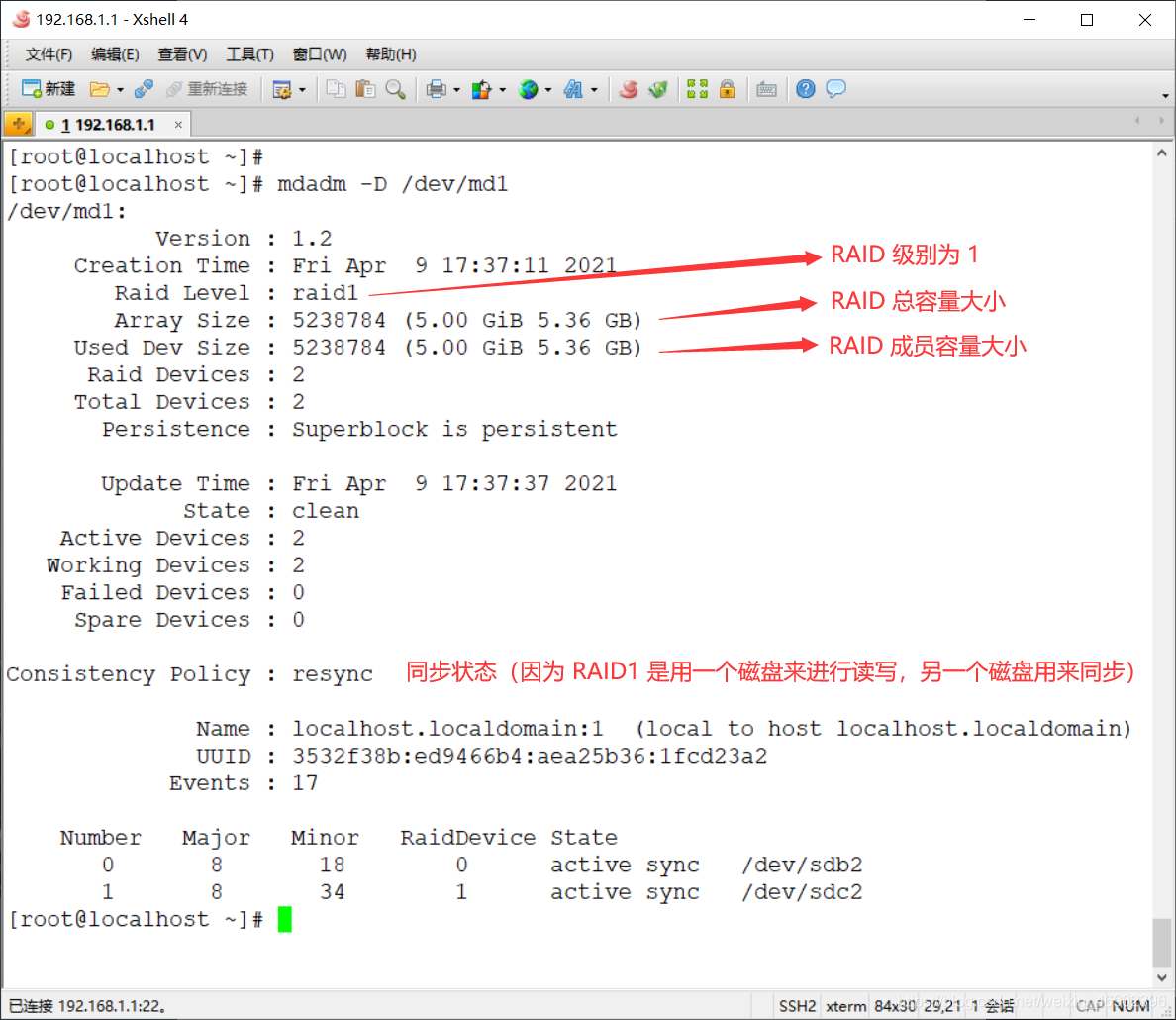

1)查看 RAID1 状态

[root@localhost ~]# mdadm -D /dev/md1 #查看更详细的信息

注解:

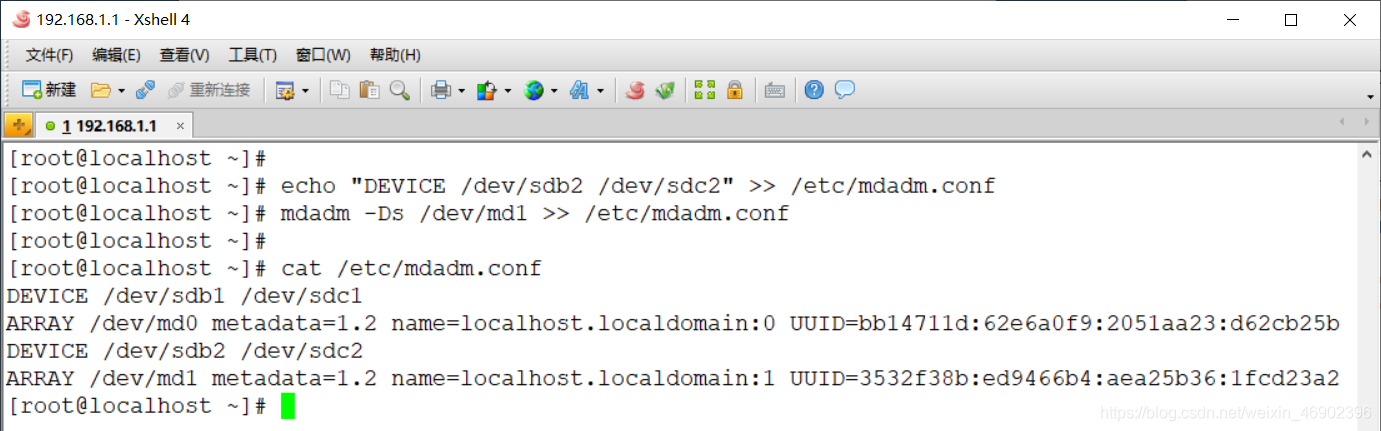

2)修改 mdadm 配置文件

[root@localhost ~]# echo "DEVICE /dev/sdb2 /dev/sdc2" >> /etc/mdadm.conf #指定软 RAID 设备

[root@localhost ~]# mdadm -Ds /dev/md1 >> /etc/mdadm.conf

3)格式化磁盘阵列

[root@localhost ~]# mkfs.xfs /dev/md1 #格式化为 xfs 文件系统

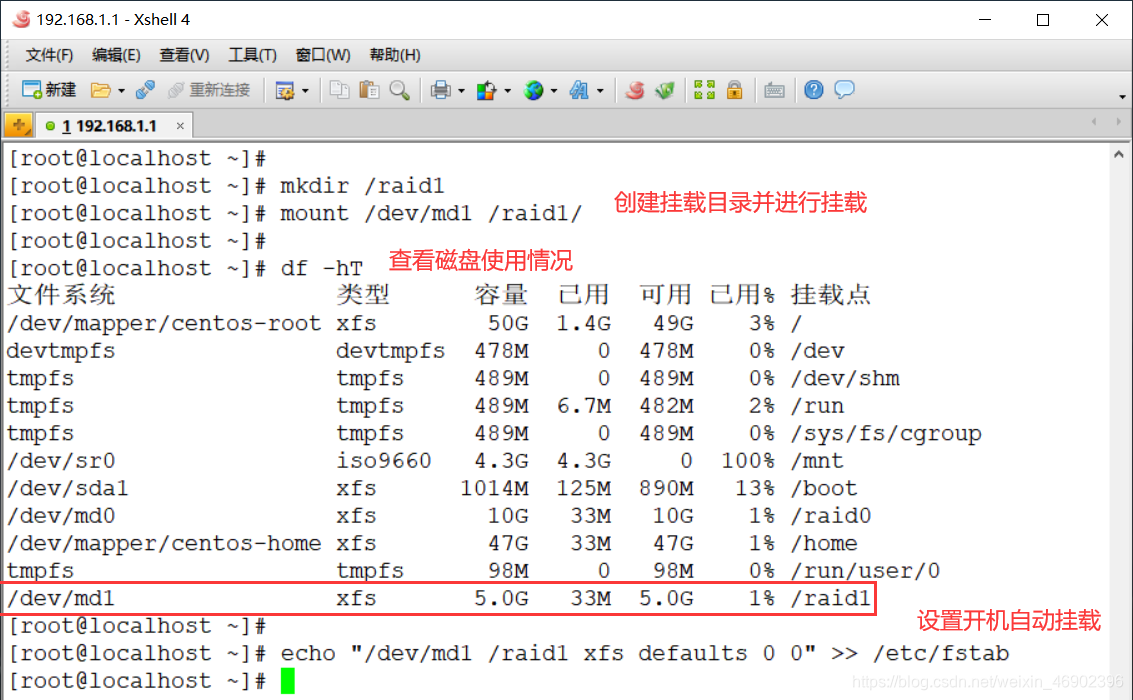

4)建立挂载点并挂载

[root@localhost ~]# mkdir /raid1 #创建挂载点

[root@localhost ~]# mount /dev/md1 /raid1/ #挂载

[root@localhost ~]# df -hT #查看磁盘使用情况

[root@localhost ~]# echo "/dev/md1 /raid1 xfs defaults 0 0" >> /etc/fstab

5)验证 RAID0 是否开机自动挂载

[root@localhost ~]# reboot #重启

[root@localhost ~]# df -hT #查看磁盘使用情况

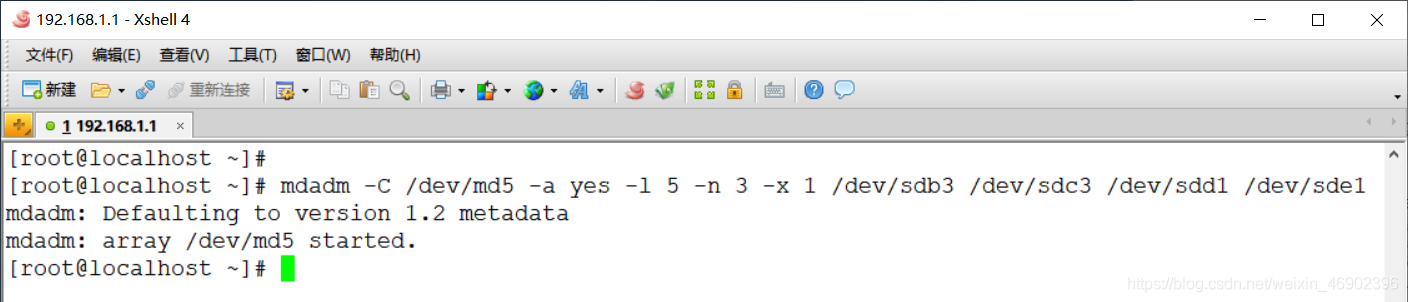

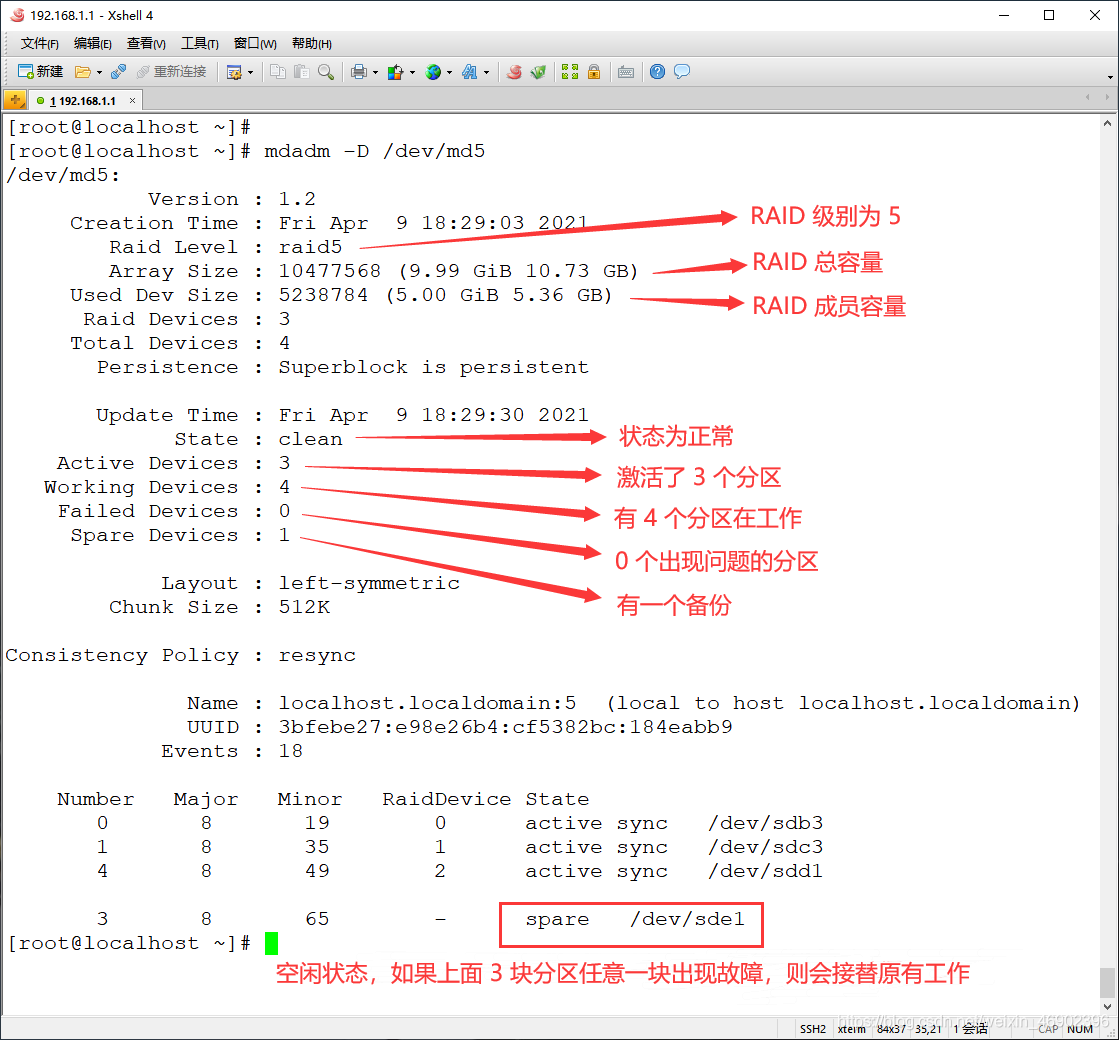

[root@localhost ~]# mdadm -C /dev/md5 -a yes -l 5 -n 3 -x 1 /dev/sdb3 /dev/sdc3 /dev/sdd1 /dev/sde1

1)查看 RAID5 状态

[root@localhost ~]# mdadm -D /dev/md5

2)修改 mdadm 配置文件

[root@localhost ~]# echo "DEVICE /dev/sdb3 /dev/sdc3 /dev/sdd1 /dev/sde1" >> /etc/mdadm.conf

[root@localhost ~]# mdadm -Ds /dev/md5 >> /etc/mdadm.conf

3)格式化磁盘阵列

[root@localhost ~]# mkfs.xfs /dev/md5

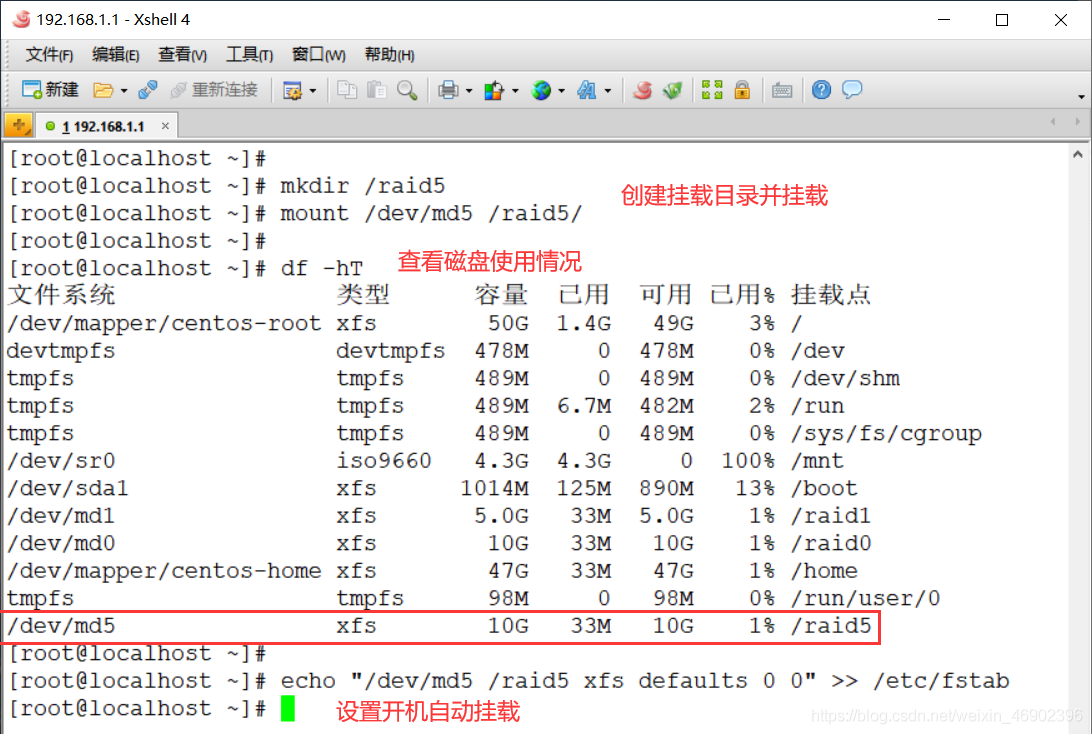

4)建立挂载点并挂载

[root@localhost ~]# mkdir /raid5 #创建挂载点

[root@localhost ~]# mount /dev/md5 /raid5/ #挂载

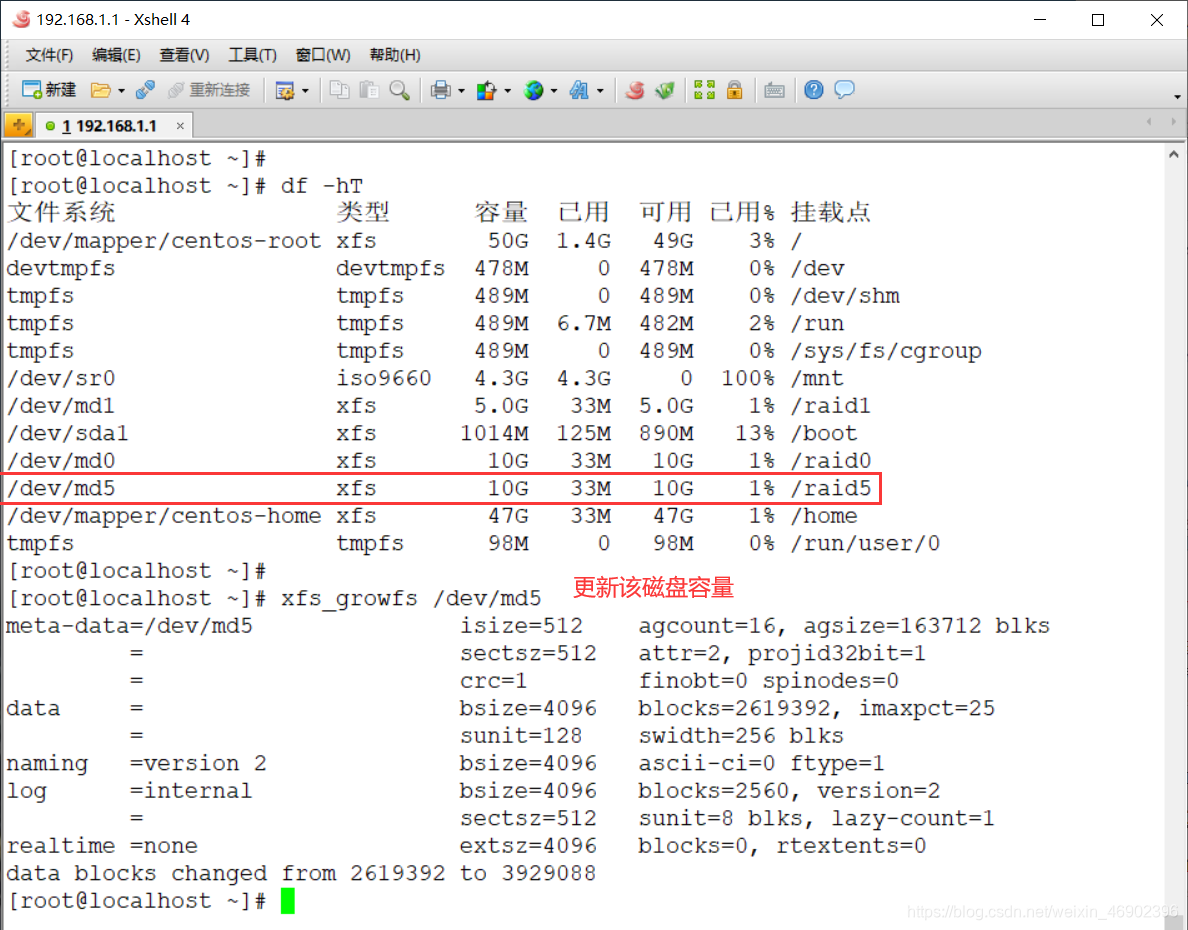

[root@localhost ~]# df -hT #查看磁盘使用情况

[root@localhost ~]# echo "/dev/md5 /raid5 xfs defaults 0 0" >> /etc/fstab

5)向 /raid5 里面写入测试数据

[root@localhost ~]# cd /raid5/

[root@localhost raid5]# touch zhangsan.txt

[root@localhost raid5]# touch wangwu.txt

[root@localhost raid5]# ls

wangwu.txt zhangsan.txt

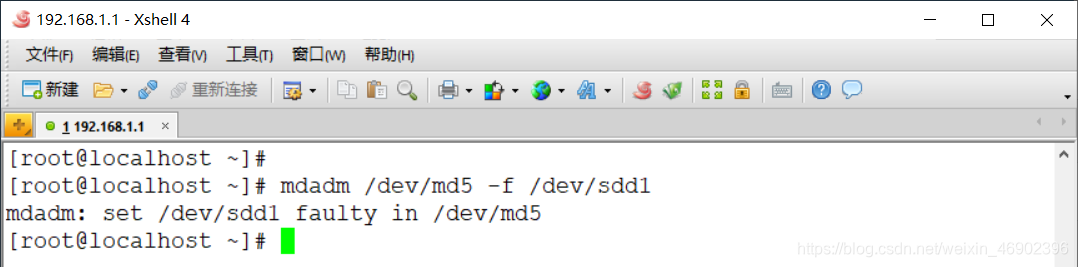

1)对 RAID5 进行模拟故障操作

[root@localhost ~]# mdadm /dev/md5 -f /dev/sdd1

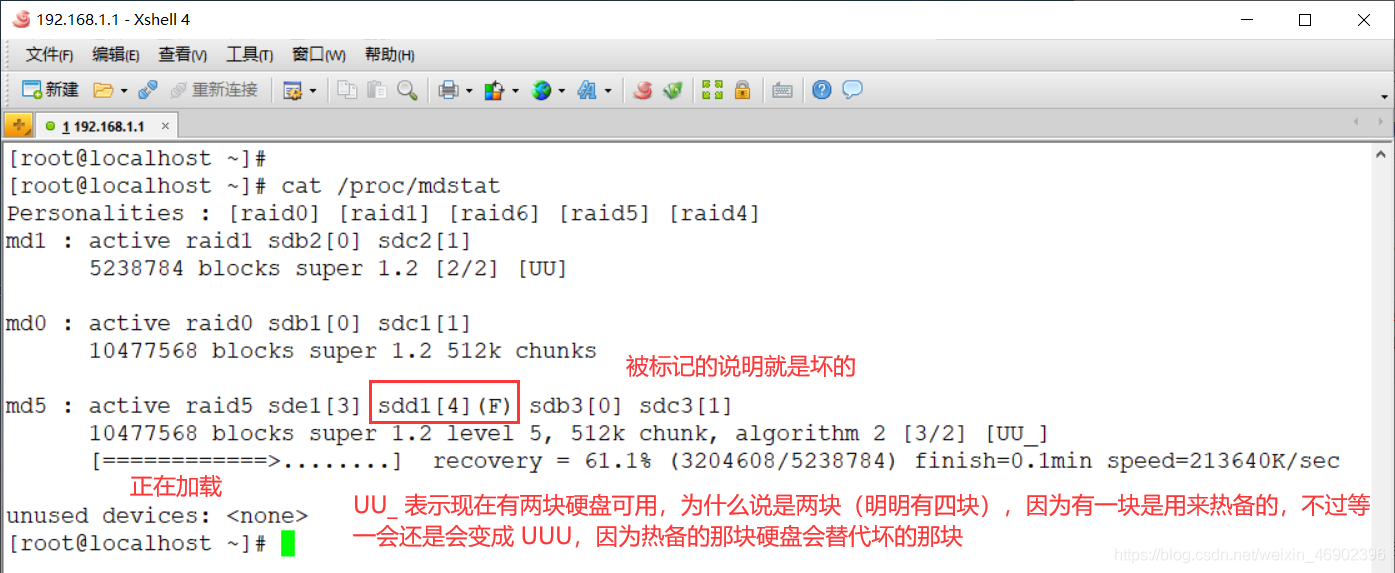

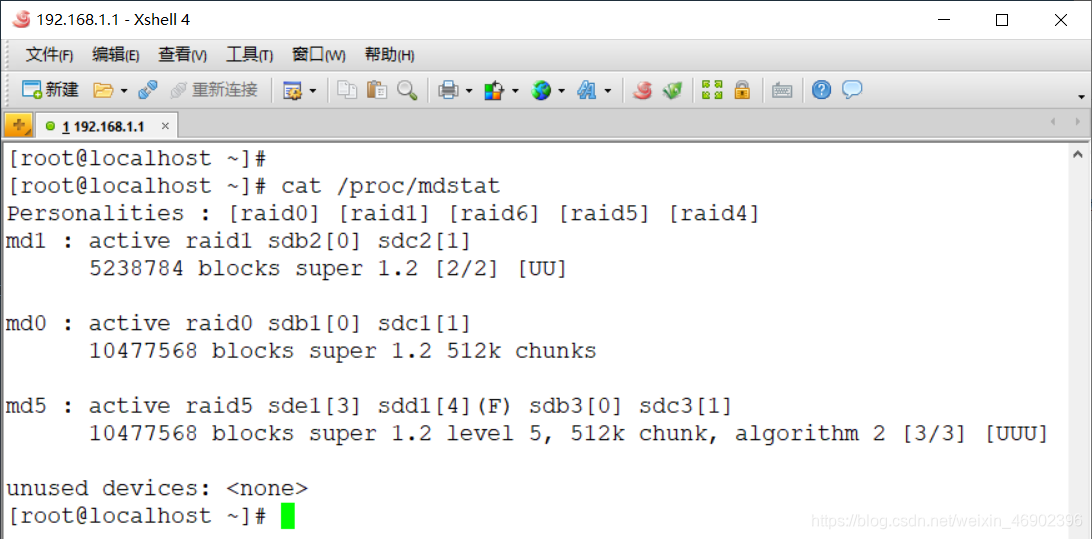

2)查看重建状态

[root@localhost ~]# cat /proc/mdstat

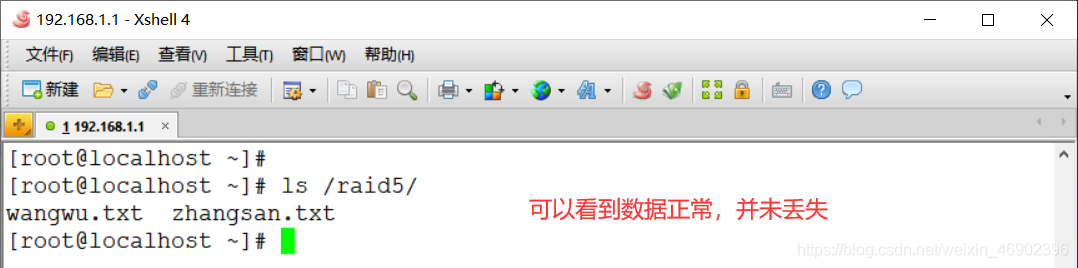

3)查看之前写入的测试数据是否还在

[root@localhost ~]# ls /raid5/

4)重建完毕后查看阵列状态

[root@localhost ~]# cat /proc/mdstat

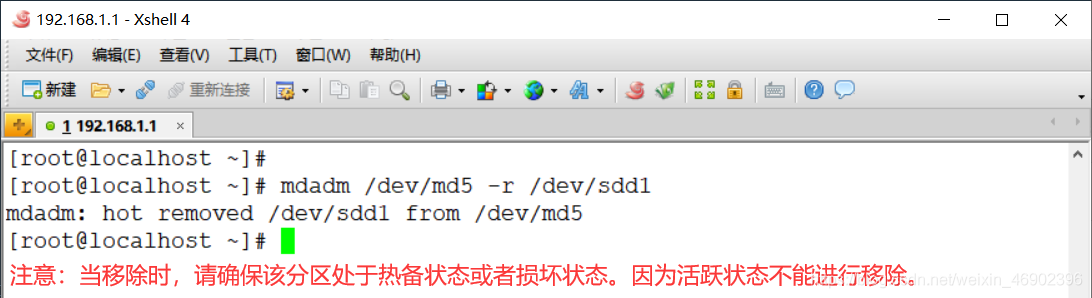

5)移除损坏的磁盘

[root@localhost ~]# mdadm /dev/md5 -r /dev/sdd1

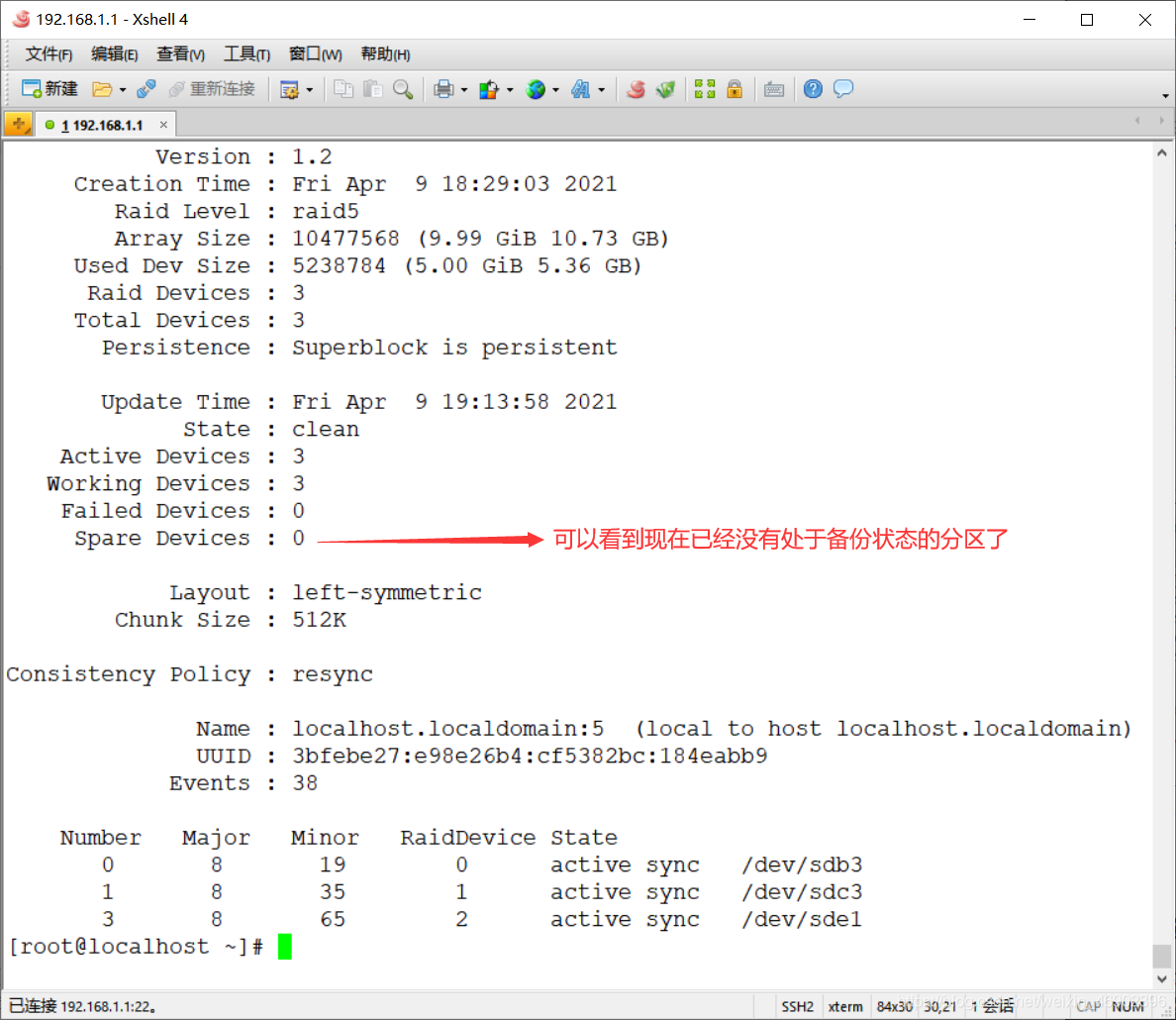

6)再次查看 /dev/md5 状态

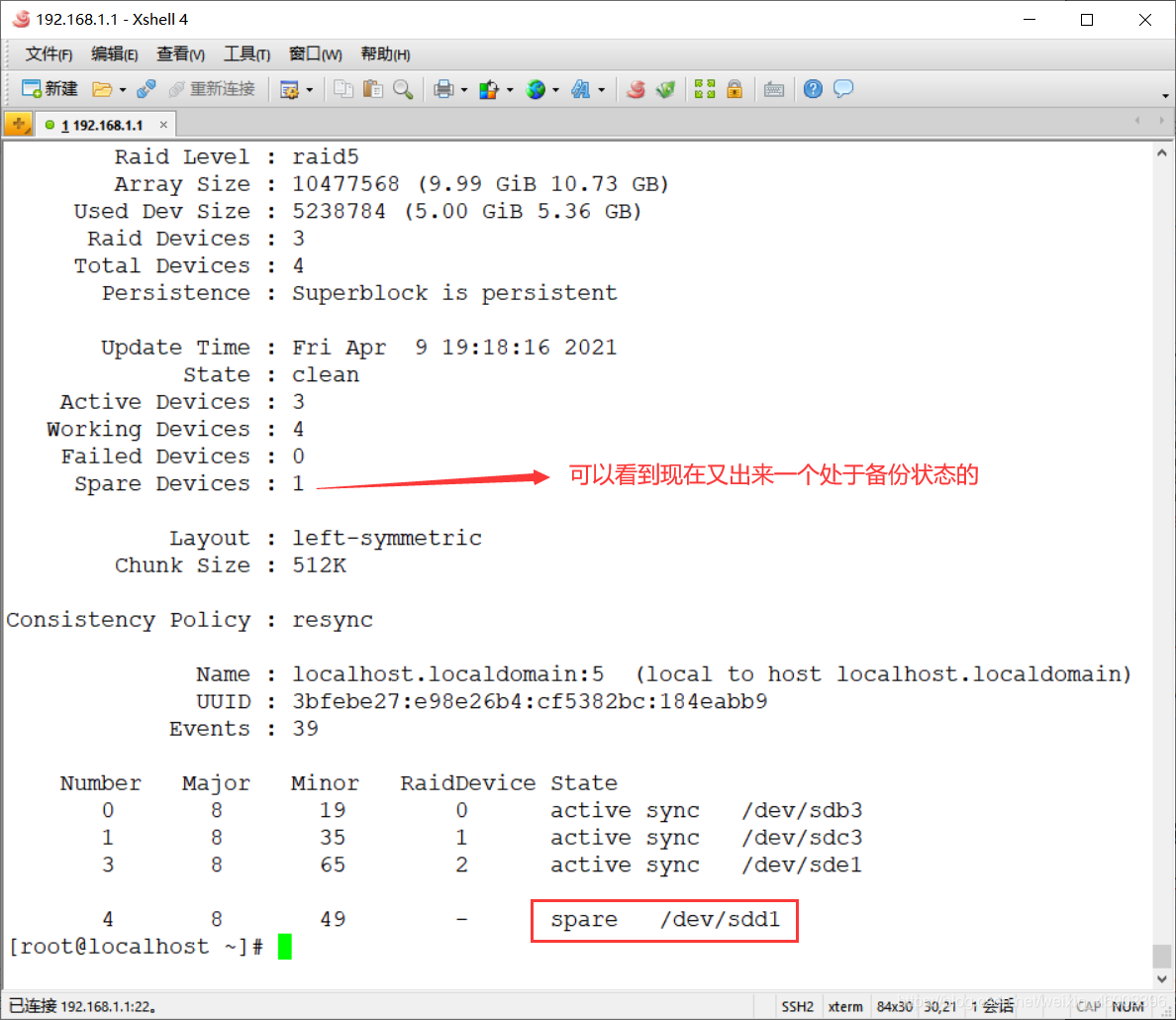

[root@localhost ~]# mdadm -D /dev/md5

7)新加热备磁盘

[root@localhost ~]# mdadm /dev/md5 -a /dev/sdd1

8)查看 /dev/md5 状态

[root@localhost ~]# mdadm -D /dev/md5

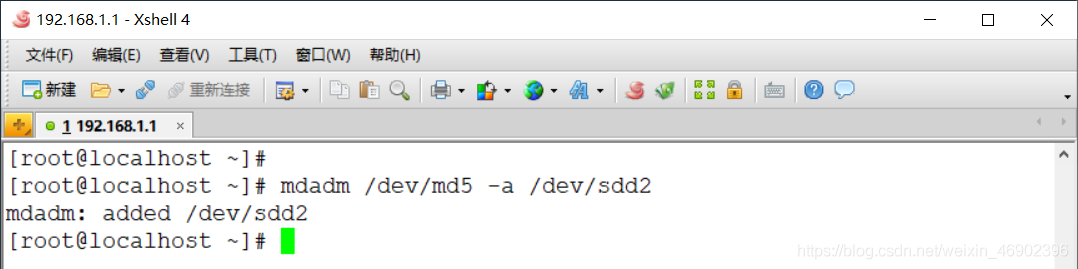

1)向 RAID 中新加一块硬盘

[root@localhost ~]# mdadm /dev/md5 -a /dev/sdd2

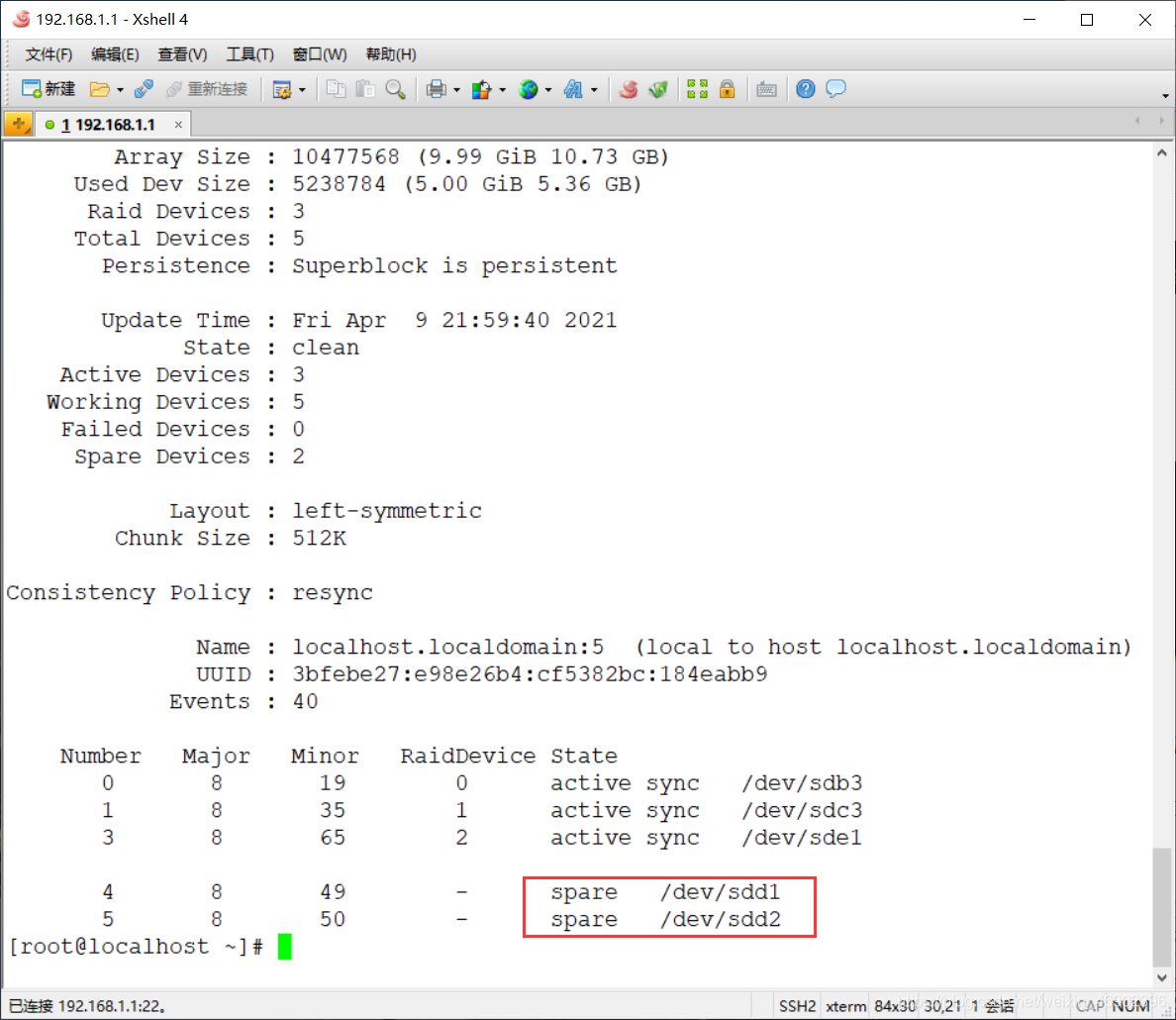

2)查看此时的 RAID 状态

[root@localhost ~]# mdadm -D /dev/md5

3)热备盘转换成活动盘

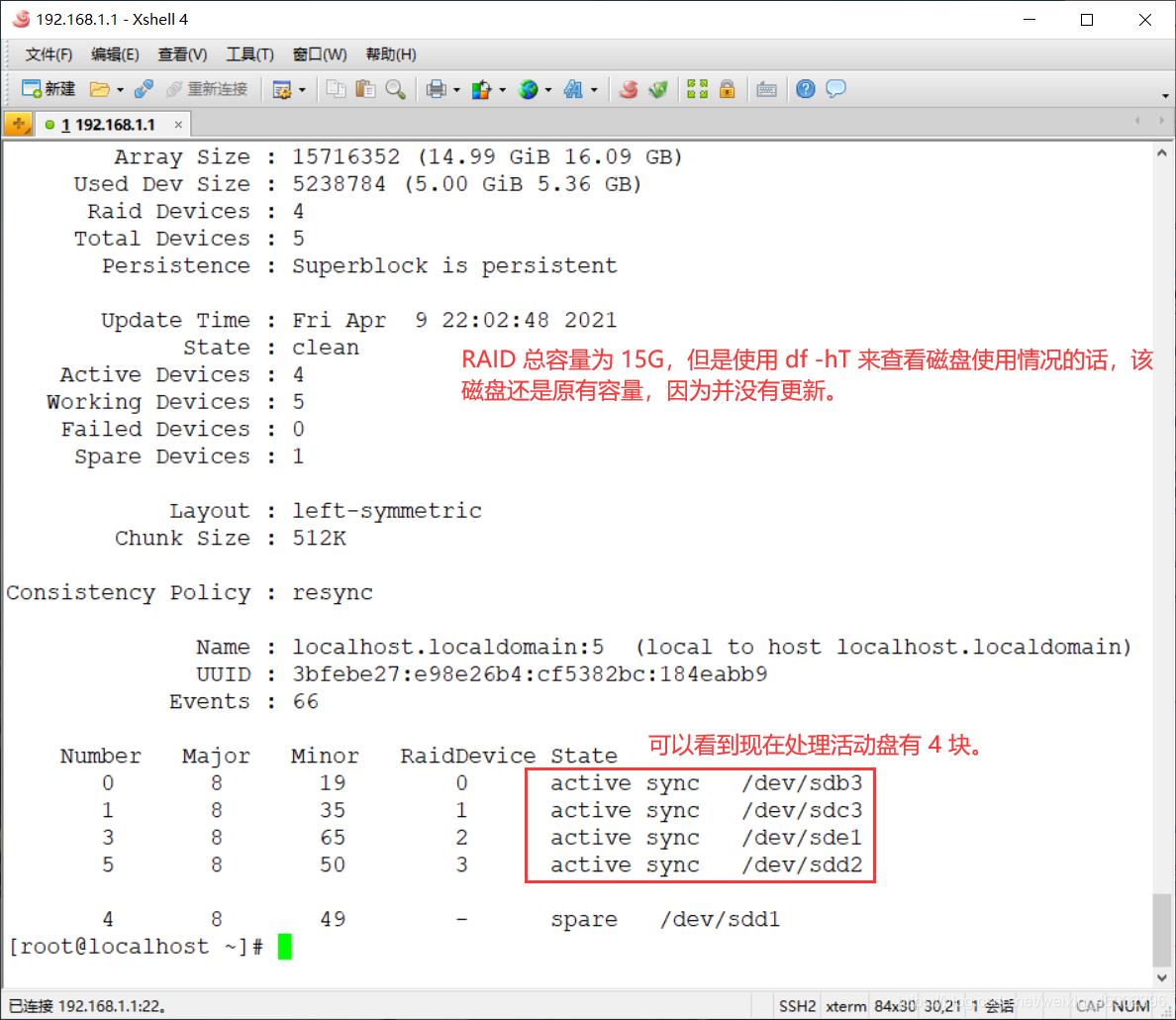

[root@localhost ~]# mdadm -G /dev/md5 -n 4

4)查看此时的 RAID 状态

[root@localhost ~]# mdadm -D /dev/md5

5)扩容文件系统

[root@localhost ~]# xfs_growfs /dev/md5

6)修改 RAID 配置文件

[root@localhost ~]# vim /etc/mdadm.conf

将原来的 RAID5 配置删除

[root@localhost ~]# echo "DEVICE /dev/sdb3 /dev/sdc3 /dev/sdd2 /dev/sde1" >> /etc/mdadm.conf

[root@localhost ~]# mdadm -Ds /dev/md5 >> /etc/mdadm.conf

7)验证 RAID5 是否开机自动挂载

[root@localhost ~]# reboot

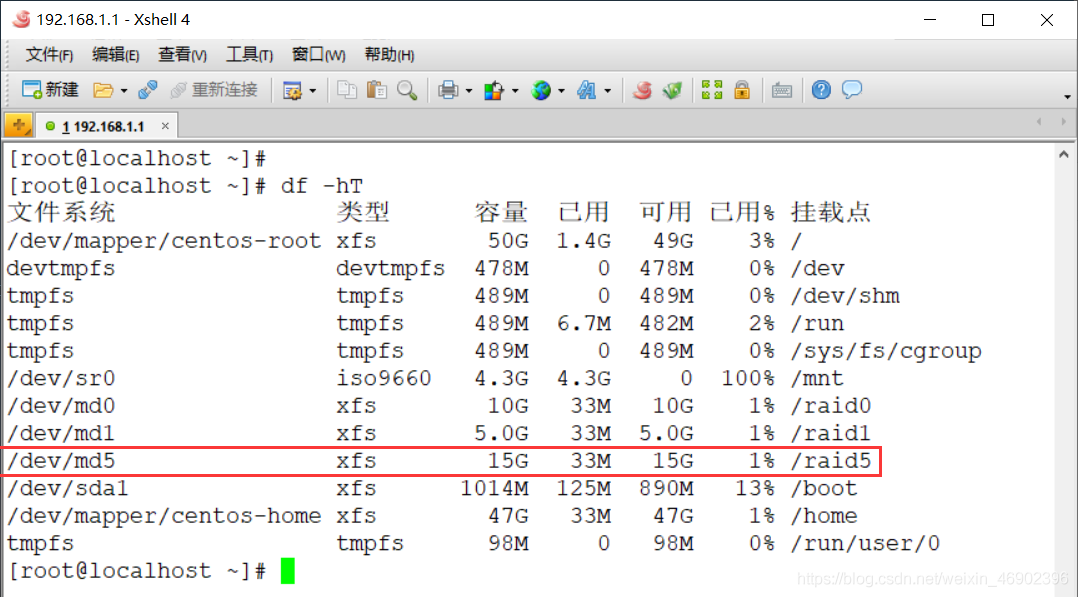

[root@localhost ~]# df -hT

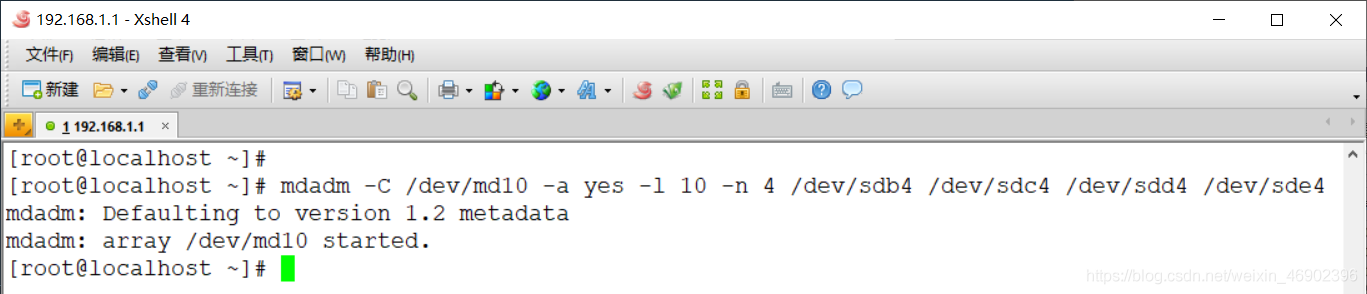

[root@localhost ~]# mdadm -C /dev/md10 -a yes -l 10 -n 4 /dev/sdb4 /dev/sdc4 /dev/sdd4 /dev/sde4

1)查看 RAID10 状态

[root@localhost ~]# mdadm -D /dev/md10

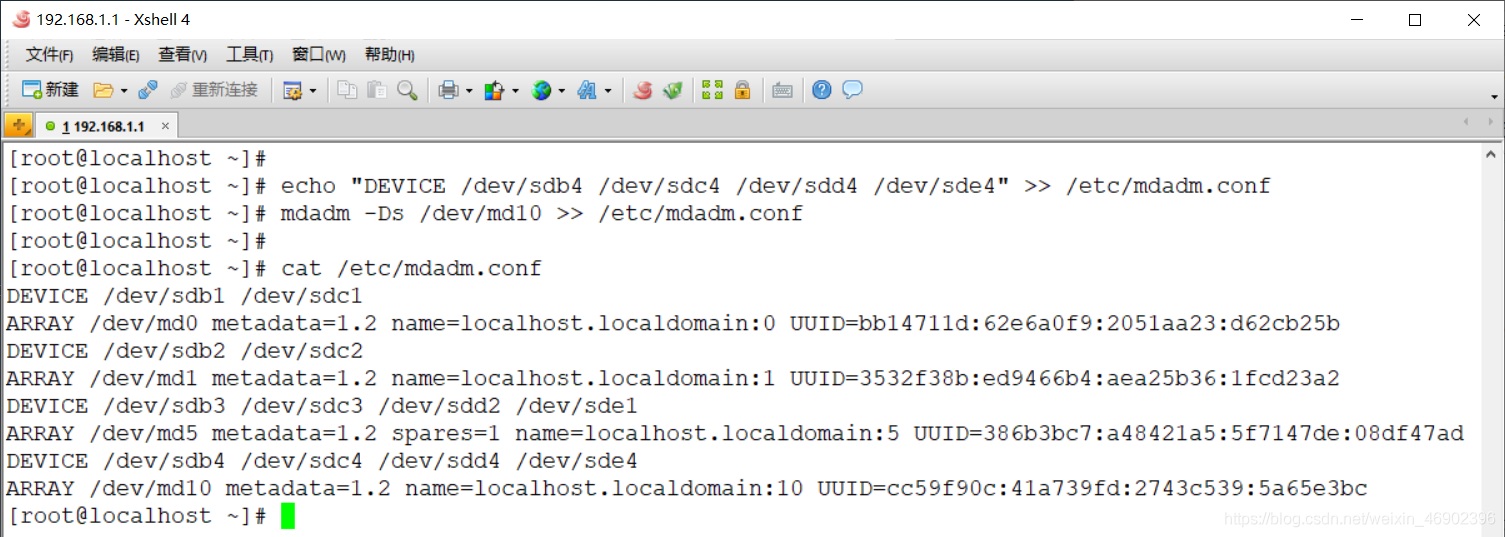

2)修改 mdadm 配置文件

[root@localhost ~]# echo "DEVICE /dev/sdb4 /dev/sdc4 /dev/sdd4 /dev/sde4" >> /etc/mdadm.conf

[root@localhost ~]# mdadm -Ds /dev/md10 >> /etc/mdadm.conf

3)格式化磁盘阵列

[root@localhost ~]# mkfs.xfs /dev/md10 #格式化为 xfs 文件格式

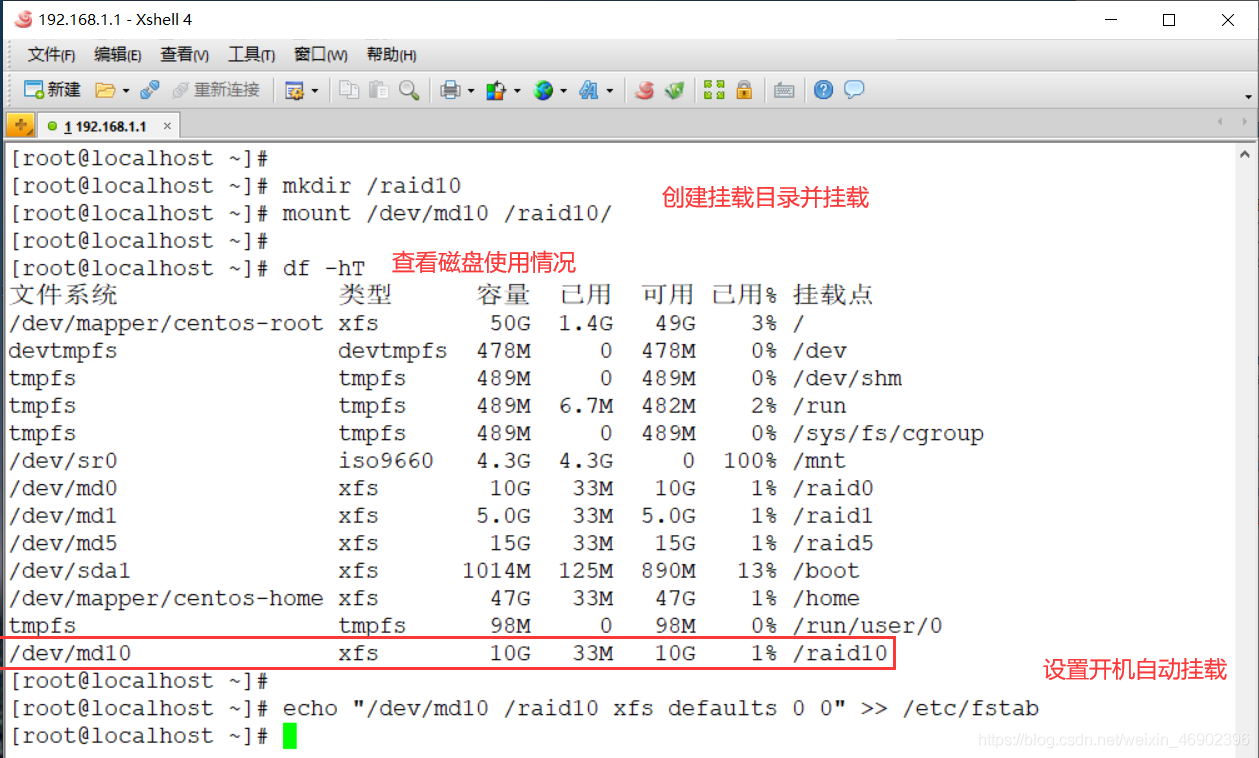

4)建立挂载点并挂载

[root@localhost ~]# mkdir /raid10 #创建挂载目录

[root@localhost ~]# mount /dev/md10 /raid10/ #挂载

[root@localhost ~]# df -hT #查看磁盘使用情况

[root@localhost ~]# echo "/dev/md10 /raid10 xfs defaults 0 0" >> /etc/fstab

7)验证 RAID10 是否开机自动挂载

[root@localhost ~]# reboot

[root@localhost ~]# df -hT

简介 “ 大家好我是帅哥欢迎来到帅哥的程序人生我会把经历分享出来助你了解圈内...

前言 aop即是面向切面编程,众多Aop框架里Castle是最为人所知的,另外还有死去的...

开发过程中,我们经常会遇到代码回滚的情况。正常人都知道,git 回滚有两大宝: ...

互联网业务往往使用MySQL数据库作为后台存储,存储引擎使用InnoDB。我们针对互联...

不少Windows 10用户之前都抱怨一个问题,那就是系统的屏幕出现了渲染问题,而微...

本文转载自微信公众号「Linux开发那些事儿」,作者 LinuxThings 。转载本文请联...

2月26日消息 众所周知,Windows 10 的安全更新和其他重要累计更新通常是在同一天...

继 Australis 和 Photon 之后,Mozilla 现又酝酿为 Firefox 带来名为Proton的全...

一、Postman背景介绍 用户在开发或者调试网络程序或者是网页B/S模式的程序的时候...

console.log ,作为一个前端开发者,可能每天都会用它来分析调试,但这个简单函...