在处理表达谱数据的时候,你是否遇到过在设置行名的时候,出现行名不能重复的问题,那时候的你会怎么处理呢?当年的我,花费了很大的力气,最后才解决这个问题,由刚开始的用excel一个一个手动删除,到现在用脚本删除,这个过程用了很长时间。

现在为了让初学者更容易解决这个问题,不再走小编当前走过的艰难老路,小编将该部分功能进行封装,并做了可视化的界面,方便大家更好的理解和使用!

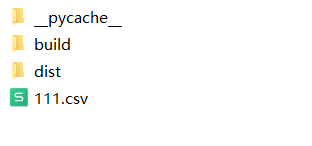

首先,该软件是用python包装,大家需要在使用前安装python3.8及以上的版本,安装完成后,退出杀毒软件,解压压缩包。压缩包下有这么几个文件,其实111.csv文件为小编为大家准备的测试文件

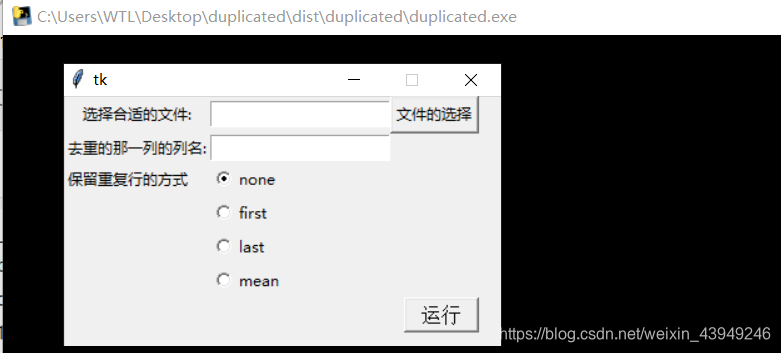

在文件夹下dist\duplicated\duplicated.exe,双击该程序。

在文件夹下dist\duplicated\duplicated.exe,双击该程序。

选择文件所在的位置

选择文件所在的位置

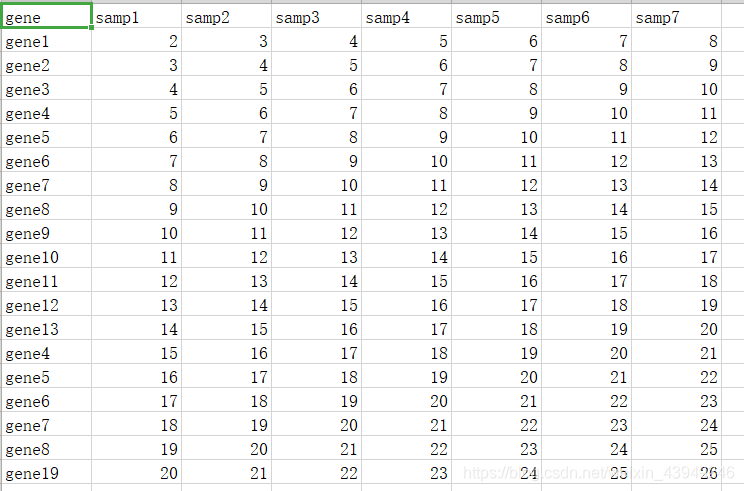

在测试之前,我们需要知道根据哪一列进行去重,我们测试数据重复的这列名称为‘gene’

在测试之前,我们需要知道根据哪一列进行去重,我们测试数据重复的这列名称为‘gene’

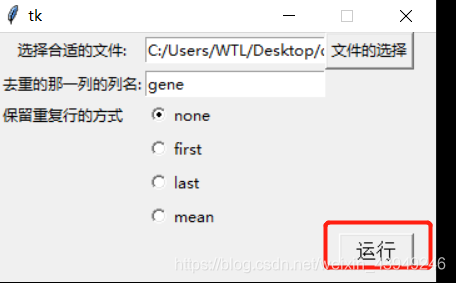

按照上面显示,直接运行,这时候在去重的这个文件下多了一个result.csv的文件。

按照上面显示,直接运行,这时候在去重的这个文件下多了一个result.csv的文件。

那么这列的保留重复行的方式是什么意思?

none:为所有重复的,全部删除

first:对于重复的,仅仅只保留第一次出现的那一行

last:对于重复的,仅仅只保留最后一次出现的那一行

mean:对于重复的行,取平均值

操作是不是很简单,大家有兴趣也可以试试哈!

可以加我微信获取压缩包

也可以自行下载,压缩包已经上传。

https://download.csdn.net/download/weixin_43949246/16779467?spm=1001.2014.3001.5501

简介 redis_exporter就是为了收集redis服务指标的应用。 下载运行 wget-c-t100ht...

复制代码 代码如下: !--doctype指定文档类型htm-- !doctype html html header !-...

近期 Docker 发布了全新的 Docker Desktop 3.0.0 版本,这个版本采用补丁形式进...

近期,海量数据研发团队再添一名重量级专家前Oracle中国研发中心高级研发总监李年...

前言 相信大家应该都知道吧,.amr格式用于移动设备的音频,压缩比比较大,多用于...

本文实例为大家分享了js局部自定义鼠标右键菜单的具体代码,供大家参考,具体内...

一、背景 随着分布式应用的崛起单台应用服务器很难支撑起业务真实场景中往往一个...

? ? ? ? 在CT107D单片机综合训练平台上首先将J5处的跳帽接到2~3引脚使按键S4~S7...

本文实例讲述了JSP+EXt2.0实现分页的方法。分享给大家供大家参考。具体如下: Ja...

一、模式说明 Work Queues 与入门程序的简单模式相比多了一个或一些消费端多个消...