YOLO算法

YOLO介绍?

YOLO,全称为You Only Look Once: Unified, Real-Time Object Detection,是一种实时目标检测算法。目标检测是计算机视觉领域的一个重要任务,它不仅需要识别图像中的物体类别,还需要确定它们的位置。与分类任务只关注对象是什么不同,目标检测需要同时处理离散的类别数据和连续的位置数据。YOLO算法基于深度学习的回归方法,它将目标检测问题转化为一个回归问题,使用单个卷积神经网络(CNN)直接从输入图像预测边界框(bounding box)和类别概率。这种方法避免了传统目标检测算法中复杂的多阶段处理流程,如区域提议、特征提取等。

- YOLO的网络结构受到了GoogLeNet的启发,包含24个卷积层和2个全连接层。在YOLO v1中,作者使用了1×1的降维层紧跟着3×3的卷积层来代替GoogLeNet的inception模块。

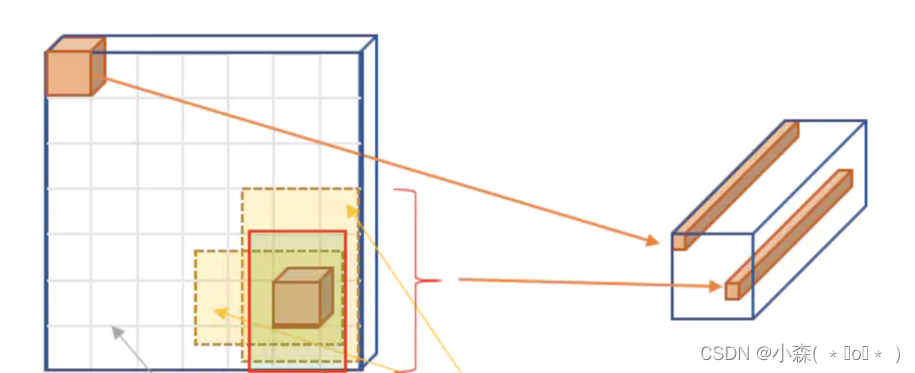

- YOLO将输入图像分割成S×S的网格,每个网格单元负责检测中心点落在该单元内的目标。这种策略简化了目标的定位过程,并允许模型快速地对多个目标进行定位和分类。

- YOLO的设计强调实时性能,通过一次前向传播就可以完成检测任务,这使得它非常适合用于视频流分析或其他需要快速响应的应用场合。

Yolo算法采用一个单独的CNN模型实现end-to-end的目标检测,核心思想就是利用整张图作为网络的输入,直接在输出层回归 bounding box(边界框) 的位置及其所属的类别:

首先将输入图片resize到448x448,然后送入CNN网络,最后处理网络预测结果得到检测的目标。相比R-CNN算法,其是一个统一的框架,其速度更快。

Yolo算法思想?:

Yolo模型采用预定义预测区域的方法来完成目标检测,具体而言是将原始图像划分为 7x7=49 个网格(grid),每个网格允许预测出2个边框(bounding box,包含某个对象的矩形框),总共 49x2=98 个bounding box。我们将其理解为98个预测区,很粗略的覆盖了图片的整个区域,就在这98个预测区中进行目标检测。

?Yolo的网络结构?

YOLO的结构非常简单,就是单纯的卷积、池化最后加了两层全连接,从网络结构上看,与前面介绍的CNN分类网络没有本质的区别,最大的差异是输出层用线性函数做激活函数,因为需要预测bounding box的位置(数值型),而不仅仅是对象的概率。YOLO的整个结构就是输入图片经过神经网络的变换得到一个输出的张量?

- 网络的输入是原始图像,唯一的要求是缩放到448x448的大小。主要是因为Yolo的网络中,卷积层最后接了两个全连接层,全连接层是要求固定大小的向量作为输入,所以Yolo的输入图像的大小固定为448x448。

- 网络的输出就是一个7x7x30 的张量。

根据YOLO的设计,输入图像被划分为 7x7 的网格(grid),输出张量中的 7x7 就对应着输入图像的 7x7 网格。

Yolo模型的训练?

?在进行模型训练时,需要构造训练样本和设计损失函数,才能利用梯度下降对网络进行训练。

将一幅图片输入到yolo模型中,对应的输出是一个7x7x30张量,构建标签label时对于原图像中的每一个网格grid都需要构建一个30维的向量。

- 20个对象分类的概率

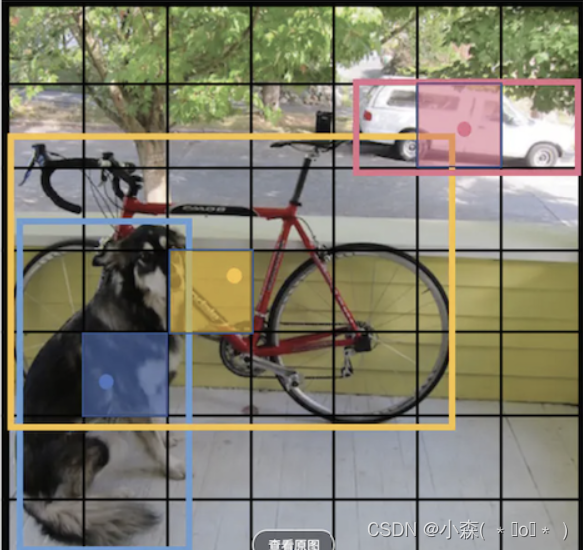

对于输入图像中的每个对象,先找到其中心点。上图中自行车,其中心点在黄色圆点位置,中心点落在黄色网格内,所以这个黄色网格对应的30维向量中,自行车的概率是1,其它对象的概率是0。所有其它48个网格的30维向量中,该自行车的概率都是0。这就是"中心点所在的网格对预测该对象负责"。

- 2个bounding box的位置

训练样本的bbox位置应该填写对象真实的位置bbox,填哪一个需要根据网络输出的bbox与对象实际bbox的IOU来选择。

Yolo先使用ImageNet数据集对前20层卷积网络进行预训练,然后使用完整的网络,在PASCAL VOC数据集上进行对象识别和定位的训练。

Yolo的最后一层采用线性激活函数,其它层都是Leaky ReLU。训练中采用了drop out和数据增强来防止过拟合。

?yoloV4算法

YOLOv4是YOLO系列算法的第四代版本,它在YOLOv3的基础上进行了一系列改进和优化,以实现更高的检测精度和更快的处理速度,为了提高模型的泛化能力和防止过拟合,YOLOv4还引入了Dropblock正则化方法。这种方法在训练过程中逐渐增加遮挡的比例,迫使网络学习更加鲁棒的特征表示。

YOLOv4的网络结构由四个关键部分组成:Input、Backbone、Neck和Head。

- Input部分:这是网络的输入端,负责接收待处理的图像数据。

- Backbone部分 (CSPDarknet53):这部分是整个网络结构的主干,主要负责对输入图像进行特征提取。CSPDarknet53是一种残差网络,它通过CSP(Cross Stage Partial)模块优化了梯度流和计算量,相较于DarkNet53,CSPDarknet53在保持准确率的同时减少了计算量。每个CSP模块都会使输出的特征图大小减半而通道数增倍,有利于提取更深层的特征。

- Neck部分 (SPP和PANet):Neck部分紧随Backbone,用于进一步加强特征提取。SPP(空间金字塔池化)可以融合不同尺寸的特征,增大模型的感受野,而PANet(路径聚合网络)则是FPN(特征金字塔网络)的加强版,它融合了自底向上和自顶向下的特征信息,反复提取特征,以增强模型的表征能力。

- Head部分 (YOLOv3):最后是Head部分,也就是预测头部,负责进行最终的边界框预测和类别概率输出。YOLOv4采用了YOLOv3作为其Head,利用前面提取的特征来执行实际的目标检测任务。

yoloV4网络的输入依然要求是32的倍数,但大小不是固定的,在yoloV4中默认是608×608,在实际项目中也可以根据需要修改,比如320×320,一般是32的倍数。 输入图像的大小和最后的三个特征图的大小也是对应的,比如416×416的输入,最后的三个特征图大小是13×13,26×26,52×52, 如果是608×608,最后的三个特征图大小则是19×19,38×38,76×76。

yoloV4在输入端除了采用常规的反转、裁切、旋转等方法外,主要采用了CutMix和马赛克数据增强,马赛克增强方式将4张训练图像按一定比例组合成1张。Mosaic增强方式使得模型能够学习如何识别尺寸小的物体,还能够帮助模型在图像的不同部分定位不同类型的目标。

模型训练?

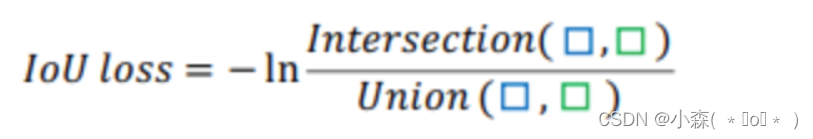

yoloV4中的模型训练与预测和YoloV3几乎是一样的,包括正负样本的设置方式,损失函数的构成及训练过程。唯一不同是在计算回归值得损失时,V4中采用了IOU的损失。IOU损失非常简单,直接使用检测框与真实框的交并比并取对数作为回归的损失函数

GIOU损失是为了缓解IOU损失的问题提出来的,这种方式存在的问题是当检测框在真实框内部或正式框在检测框内部时,无法衡量差集,损失函数退化为1-IOU。

- 系统环境配置:确保您的计算机系统满足训练YOLOv4的要求。常见的配置包括Windows或Linux操作系统,以及安装有CUDA和cuDNN的NVIDIA显卡。

- 获取YOLOv4代码:从GitHub上克隆YOLOv4的官方代码仓库,该仓库提供了训练YOLOv4所需的所有脚本和配置文件。

- 数据集准备:准备用于训练的目标检测数据集。如果是视频数据,需要先将视频帧提取为图片格式。此外,还需要对数据集进行标注,生成包含物体类别和位置信息的注释文件。

- 修改配置文件:根据您的数据集和训练需求,修改YOLOv4的配置文件。这些配置文件中定义了模型参数、训练参数以及数据加载方式等重要信息。

- 模型训练:使用准备好的数据集和配置文件开始训练YOLOv4模型。训练过程中,模型会学习识别和定位图像中的物体。

- 模型评估:在训练完成后,使用验证集对模型的性能进行评估,检查模型的准确率和召回率等指标。

- 模型部署:将训练好的模型部署到实际应用中,如监控系统、自动驾驶车辆或其他需要实时目标检测的场合。

- 优化调整:根据模型在实际应用场景中的表现,进一步调整模型参数或数据集,以提高模型的准确性和鲁棒性。

?我们还需要参考YOLOv4的官方文档、相关教程以及社区提供的经验分享。