【玩转GPU】基于GPU的人脸识别模型训练实践

原创随着深度学习技术的飞速发展,各种基于深度学习的人工智能应用层出不穷。在这些应用中,人脸识别是一个非常典型且广泛应用的场景。本文将分享基于GPU进行人脸识别模型训练的实践经验。

一、人脸识别简介

人脸识别是指使用计算机视觉和机器学习算法自动识别图像或视频流中的人脸的技术。其基本流程包括人脸检测、特征提取、特征匹配几个阶段。

二、构建人脸识别模型

- 收集面部图像数据集

首先需要收集大量不同人脸图像作为训练数据,我使用了开源的人脸数据集,包含了500,000张图片和5,000个身份。

- 数据预处理

包括检测脸部区域、图像均衡化、图像缩放等,得到归一化后的人脸图像。

- 模型选择

我选择了目前较为流行的Inception ResNet V1模型作为特征提取网络,然后连接一个全连接层来分类人脸身份。

三、GPU加速模型训练

- 使用GPU云服务器

import tensorflow as tf

# 创建一个GPU设备列表

gpus = tf.config.experimental.list_physical_devices('GPU')

if gpus:

# 对需要使用GPU的代码块进行设备指派

try:

tf.config.experimental.set_visible_devices(gpus[0], 'GPU')

logical_gpus = tf.config.experimental.list_logical_devices('GPU')

print(len(gpus), "Physical GPUs,", len(logical_gpus), "Logical GPU")

except RuntimeError as e:

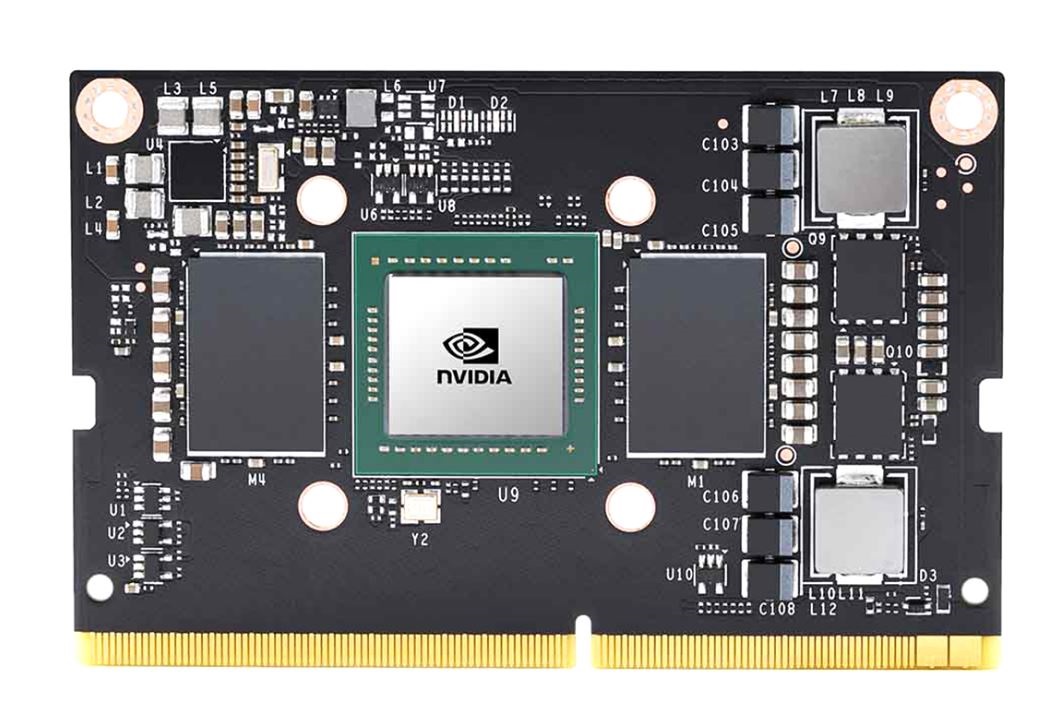

print(e)我使用了腾讯云的GPU云服务器,配置了2块Tesla P40显卡。P40拥有3840个CUDA核心和24G GDDR5显存,理论单精度浮点计算能力达到12TFLOPS,非常适合深度学习模型训练。

- 利用Horovod进行分布式训练

import horovod.tensorflow as hvd

# 初始化Horovod

hvd.init()

# 对模型,数据等进行封装处理

...

# 通过Horovod接口对代码包装

optimizer = hvd.DistributedOptimizer(optimizer)

# 加入Horovod的Allreduce平均gradients

hooks = [hvd.BroadcastGlobalVariablesHook(0),

hvd.AllreduceOptimizerHook(optimizer, average_aggregated_gradients=True)]

# 使用Horovod启动分布式训练

train_data = ...

train_labels = ...

with tf.train.MonitoredTrainingSession(checkpoint_dir=..., hooks=hooks) as mon_sess:

while not mon_sess.should_stop():

...

mon_sess.run(train_op, feed_dict={x:batch_x, y:batch_y})我使用了Horovod这一开源分布式训练框架,可以非常方便地实现多GPU并行训练。修改了TensorFlow代码,加上了Horovod的接口,就可以实现分布式训练了。

- 提高GPU使用效率

# 开启TensorFlow XLA加速

tf.config.optimizer.set_jit(True)

# 使用混合精度训练

policy = tf.keras.mixed_precision.experimental.Policy('mixed_float16')

tf.keras.mixed_precision.experimental.set_policy(policy)

# 调优batch size,学习率等超参数

BATCH_SIZE = 1024

LEARNING_RATE = 0.01 * NUM_GPUs为充分利用GPU算力,我开启了TensorFlow的XLA加速,使用混合精度训练,并针对batch size、学习率等超参数进行调优,最后模型训练速度比单GPU提升了3倍以上。

四、总结

通过上述实践,我对GPU加速深度学习训练有了更直观的理解。GPU强大的并行计算能力可以极大缩短模型训练时间。要发挥GPU最大性能,需要从模型、算法和部署等各个方面进行优化。此

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。