每日论文速递 | AutoLoRA:通过meta learning学习LoRA最优秩

每日论文速递 | AutoLoRA:通过meta learning学习LoRA最优秩

深度学习自然语言处理 分享 整理:pp

摘要:在各种 NLP 任务中,大规模预训练和针对特定任务的微调取得了巨大成功。由于对大型预训练模型的所有参数进行微调会带来巨大的计算和内存挑战,人们开发出了几种高效的微调方法。其中,低秩适应(Low-rank adaptation,LoRA)在冻结的预训练权重基础上对低秩增量更新矩阵进行微调,已被证明特别有效。然而,LoRA 在所有层中统一分配秩,并依赖穷举搜索来找到最佳秩,这导致了高计算成本和次优的微调性能。为了解决这些局限性,我们引入了 AutoLoRA,这是一种基于元学习的框架,用于自动识别每个 LoRA 层的最佳等级。AutoLoRA 将低秩更新矩阵中的每个秩-1 矩阵与一个选择变量相关联,该选择变量决定是否应丢弃秩-1 矩阵。我们开发了一种基于元学习的方法来学习这些选择变量。通过对这些变量的值进行阈值化处理,确定最佳秩。我们在自然语言理解、生成和序列标注方面的综合实验证明了 AutoLoRA 的有效性。

https://arxiv.org/abs/2403.09113

Q1: 这篇论文试图解决什么问题?

A:这篇论文试图解决的问题是如何在大型预训练语言模型(LLMs)的微调(finetuning)过程中,自动确定每个低秩适应(Low-Rank Adaptation, LoRA)层的最佳秩(rank)。在大型预训练模型(如GPT-3和RoBERTa)的应用中,微调所有参数会导致显著的计算和内存挑战。LoRA通过在冻结的预训练权重上微调低秩增量更新矩阵来提高效率,但LoRA在所有层上使用统一的秩分配,并且依赖于耗时的穷举搜索来找到最佳秩,这导致了高计算成本和次优的微调性能。

为了解决这些限制,论文提出了AutoLoRA框架,这是一个基于元学习(meta learning)的方法,用于自动识别每个LoRA层的最优秩。AutoLoRA通过将每个低秩更新矩阵中的秩-1矩阵与一个选择变量关联起来,这些变量决定了是否应该丢弃秩-1矩阵。通过元学习方法开发了一种方法来学习这些选择变量,并通过对这些变量的值进行阈值处理来确定最优秩。论文的实验表明AutoLoRA在自然语言理解、生成和序列标注任务上的有效性。

Q2: 有哪些相关研究?

A:相关研究主要集中在以下几个方面:

参数高效的微调方法(Parameter Efficient Finetuning Methods):

Adapters: 通过在预训练网络中插入轻量级层(称为adapters)来进行微调,仅更新这些adapters而保持预训练层冻结。

Prefix Tuning: 引入可训练的前缀参数,这些参数被添加到输入序列的前面,同时保持预训练模型参数冻结。

Prompt-tuning: 学习“软提示”来执行特定的下游任务。

P-tuning: 优化一个小型神经网络,该网络为自然语言理解任务生成连续的提示嵌入来微调GPT模型。

LLaMAAdapter: 为LLaMA模型学习可训练的提示。

元学习(Meta Learning):

ModelAgnostic Meta-Learning (MAML): 一种基于梯度的元学习方法,旨在训练模型权重,以便在少量数据的情况下快速适应新任务。

Meta-SGD: MAML的扩展,不仅学习模型权重,还优化学习率以快速适应新任务。

Reptile: 一种一阶元学习算法,作为MAML的简化替代方案。

LoRA的改进:

AdaLoRA: 旨在解决LoRA在所有LoRA层中均匀分配更新预算的问题,根据它们的重要性分数自适应地分配预算。这些相关研究为AutoLoRA提供了理论和技术基础,AutoLoRA通过结合元学习方法和LoRA的低秩参数化,提出了一种新的自动确定每个LoRA层最优秩的方法。

Q3: 论文如何解决这个问题?

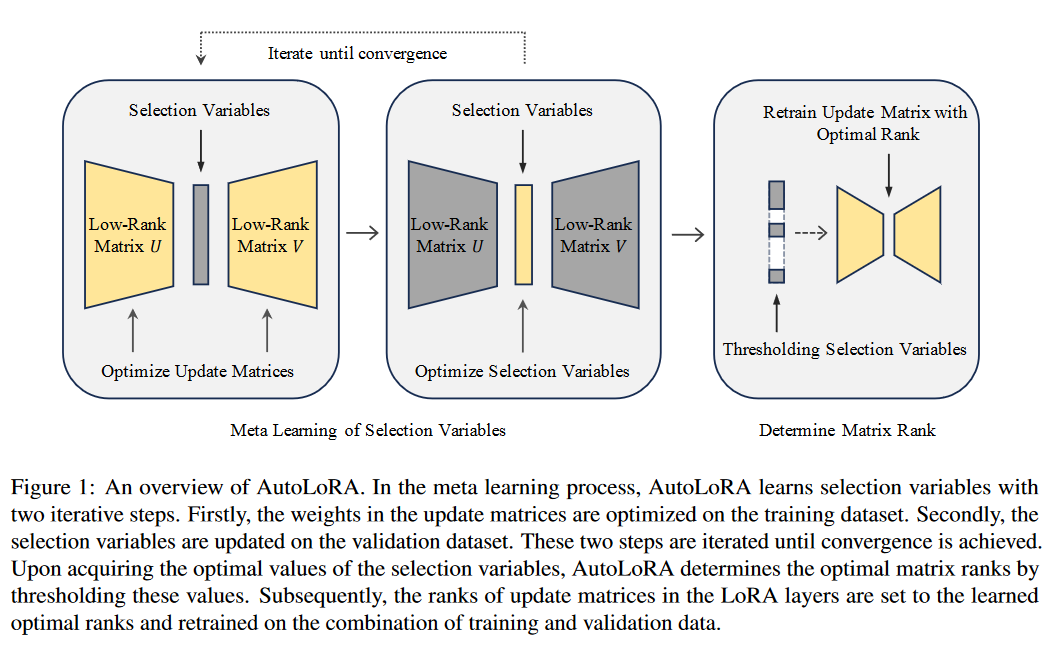

A:论文通过引入AutoLoRA框架来解决这个问题,AutoLoRA是一个基于元学习的框架,用于自动确定每个LoRA层的最优秩。具体的解决方案包括以下几个关键步骤:

- 重参数化更新矩阵:

- 将LoRA中的更新矩阵分解为两个低秩矩阵的乘积,并将其表达为秩-1矩阵的和。

- 为每个秩-1矩阵分配一个连续的可训练选择变量α,表示该矩阵在总和中的相对重要性。

- 学习选择变量:

- 通过元学习方法来学习这些选择变量。首先,在训练集上微调权重参数,然后在验证集上优化选择变量以最小化损失。

- 使用softmax函数来参数化选择变量,并通过梯度下降方法来学习这些变量。

- 确定矩阵秩:

- 通过阈值化学习到的选择变量来确定每个LoRA层的最优秩。如果选择变量的值接近零,则相应的秩-1矩阵被移除,从而确定了更新矩阵的最优秩。

- 重新训练更新矩阵:

- 在确定了每个层的最优秩后,将更新矩阵的秩设置为最优值,并在训练和验证数据的组合上重新训练这些矩阵。

这种方法允许不同层根据其对下游任务的重要性具有不同数量的可训练参数,而不是像LoRA那样在整个模型中使用统一的秩。通过这种方式,AutoLoRA能够在保持参数效率的同时提高微调性能,并减少了手动调整秩的需要。

Q4: 论文做了哪些实验?

A:论文进行了以下几类实验来验证AutoLoRA框架的有效性:

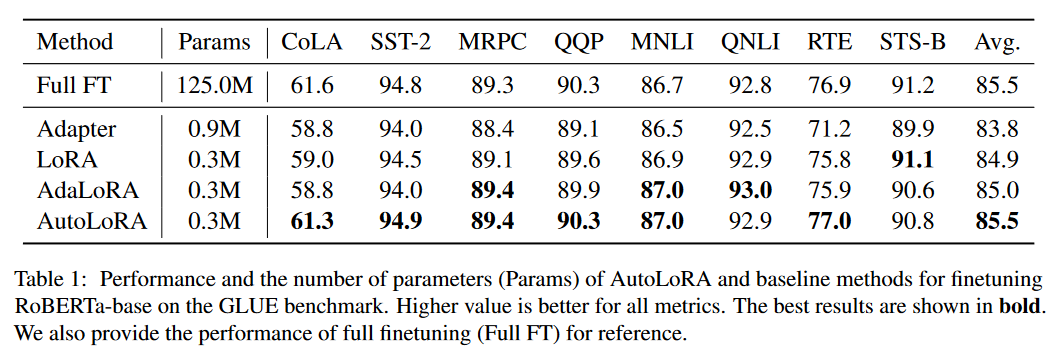

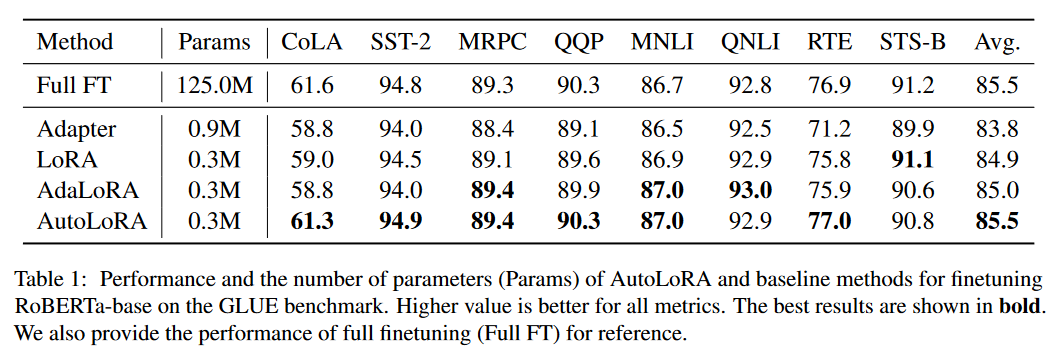

- 自然语言理解(NLU)任务:

在GLUE基准测试的八个数据集上进行了广泛的实验,这些数据集包括单句分类、句子对分类和回归任务等不同类型的NLU任务。

使用准确率作为评估指标,并对AutoLoRA与基线方法(包括全参数微调、Adapter、LoRA和AdaLoRA)进行了比较。

- 自然语言生成(NLG)任务:

在E2E和WebNLG数据集上评估AutoLoRA在NLG任务上的有效性。

使用BLEU、NIST、METEOR、ROUGE-L和CIDEr等指标来评估生成文本的质量,并与基线方法进行了比较。

- 序列标注任务:

在BioNLP数据集上评估AutoLoRA在序列标注任务上的性能,该任务涉及对句子中的每个标记进行分类。

使用精确度(Precision)和召回率(F1)作为评估指标,并与基线方法进行了比较。

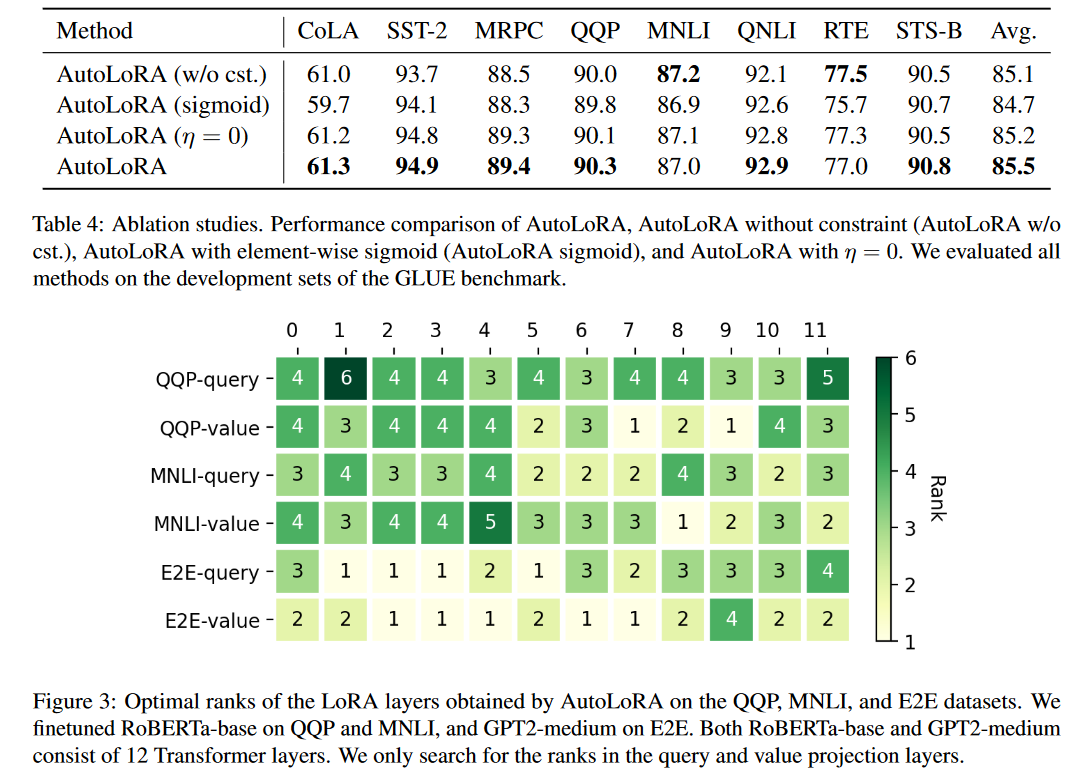

- 消融研究(Ablation Studies):

对AutoLoRA的不同组件进行了消融研究,以评估每个模块的有效性。

包括移除选择变量的约束条件、使用逐元素Sigmoid操作代替softmax、以及关闭元学习框架的特定部分等。

- 定性分析:

展示了AutoLoRA在QQP、MNLI和E2E数据集上为LoRA层确定的最优秩,以及这些秩是如何根据数据集和层类型(查询投影层和值投影层)变化的。

- 计算成本分析:

比较了AutoLoRA与基线方法在SST-2、MNLI和QQP数据集上的平均训练成本。

通过与AdaLoRA进行比较,展示了AutoLoRA在计算效率方面的优势。

这些实验结果表明AutoLoRA在各种NLP任务上都能取得与全参数微调相当甚至更好的性能,同时显著减少了参数数量和计算成本。此外,消融研究和定性分析进一步证实了AutoLoRA方法设计中各个组成部分的重要性和有效性。

Q5: 有什么可以进一步探索的点?

A:论文提出了以下几个可以进一步探索的点:

自动选择LoRA层: 论文中提到,LoRA层是手动指定的,这可能导致次优的选择。未来的工作可以探索如何自动选择哪些层应该使用LoRA进行微调,可能通过开发类似于论文中用于优化选择变量的元学习框架。

在更大的语言模型上的应用: 论文没有在最新的大型语言模型(如LLaMA和LLaMA-2)上评估AutoLoRA。这些模型比之前的模型更强大,将AutoLoRA应用于这些模型是一个有前景的研究方向。

在非英语预训练模型上的应用: 论文没有在非英语文本上预训练的模型上评估AutoLoRA。探索AutoLoRA在多语言和跨语言场景中的应用是一个有趣的研究领域。

进一步减少计算和内存开销: 尽管AutoLoRA相对于其他方法增加了一些计算和内存开销,但仍然有改进空间。未来的研究可以探索更高效的算法或技术来减少这些开销。

超参数优化: 论文中提到了使用贝叶斯优化和梯度优化等方法进行超参数配置的重要性。研究如何将这些方法与AutoLoRA结合,以进一步优化微调过程,是一个潜在的研究方向。

更广泛的任务和数据集上的评估: 扩展AutoLoRA到更广泛的NLP任务和数据集上,以验证其泛化能力和有效性。

理论和实验的深入分析: 对AutoLoRA的工作原理进行更深入的理论分析,以及通过更多的实验来探索其在不同设置下的性能表现。

这些潜在的研究方向可以进一步增强AutoLoRA框架的性能和适用性,同时也有助于理解大型预训练模型微调过程中的深层次机制。

Q6: 总结一下论文的主要内容?

A:论文介绍了大型语言模型在NLP任务中的成功,以及微调这些模型时面临的计算和内存挑战。它讨论了现有的高效微调方法,如Adapters和Prefix Tuning,并指出了它们的局限性。

相关工作: 论文回顾了参数高效微调方法和元学习方法的相关研究,为AutoLoRA提供了背景和理论基础。

方法:

- 重参数化更新矩阵: 将更新矩阵重参数化为秩-1矩阵的加权和,并为每个矩阵分配选择变量。

- 学习选择变量: 使用元学习方法在训练集和验证集上交替优化权重参数和选择变量。

- 确定矩阵秩: 通过阈值化选择变量来确定每个LoRA层的最优秩。

- 重新训练更新矩阵: 在确定最优秩后,重新训练更新矩阵以桥接阈值化引起的差异。

实验:

- 在GLUE基准测试的NLU任务、E2E和WebNLG的NLG任务以及BioNLP的序列标注任务上评估了AutoLoRA。

- 与全参数微调、Adapter、LoRA和AdaLoRA等基线方法进行了比较。

- 进行了消融研究和计算成本分析。

结论: 论文展示了AutoLoRA在各种NLP任务上的有效性,它能在保持参数效率的同时提高微调性能,并减少了手动调整秩的需要。论文还提出了未来工作的方向,包括自动选择LoRA层和在更大的语言模型上的应用。

代码: 论文提供了AutoLoRA的代码,公开可用于研究和进一步的开发。

以上内容均由KimiChat生成,深入了解论文内容仍需精读论文