刚刚,Mistral AI最新磁力链放出!8x22B MoE模型,281GB解禁

刚刚,Mistral AI最新磁力链放出!8x22B MoE模型,281GB解禁

新智元

发布于 2024-04-12 19:26:37

发布于 2024-04-12 19:26:37

新智元报道

编辑:编辑部

【新智元导读】初创团队Mistral AI再次放出一条磁力链,281GB文件解禁了最新的8x22B MoE模型。

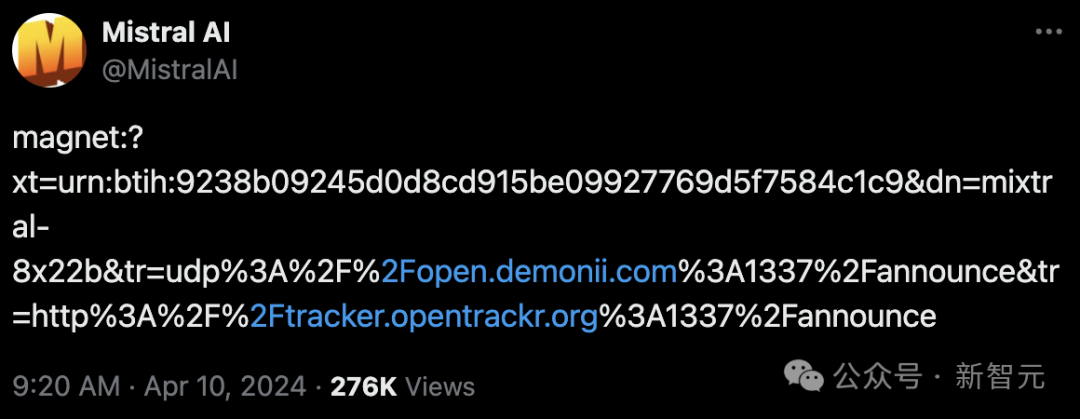

一条磁力链,Mistral AI又来闷声不响搞事情。

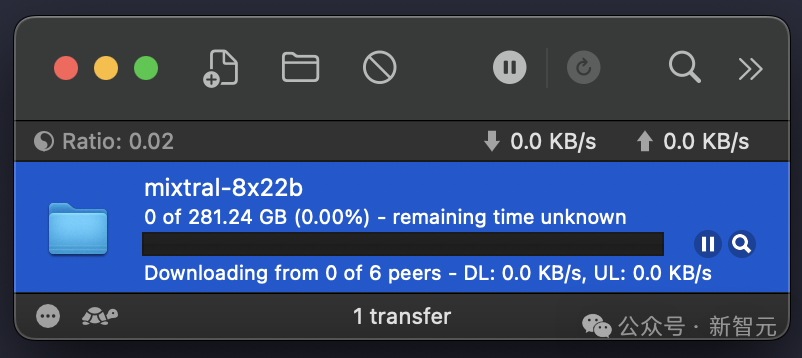

281.24GB文件中,竟是全新8x22B MOE模型!

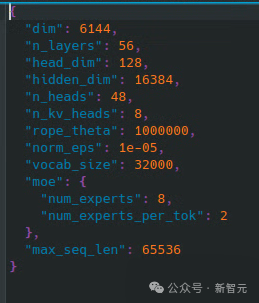

全新MoE模型共有56层,48个注意力头,8名专家,2名活跃专家。

而且,上下文长度为65k。

网友纷纷表示,Mistral AI一如既往靠一条磁力链,掀起了AI社区热潮。

对此,贾扬清也表示,自己已经迫不及待想看到它和其他SOTA模型的详细对比了!

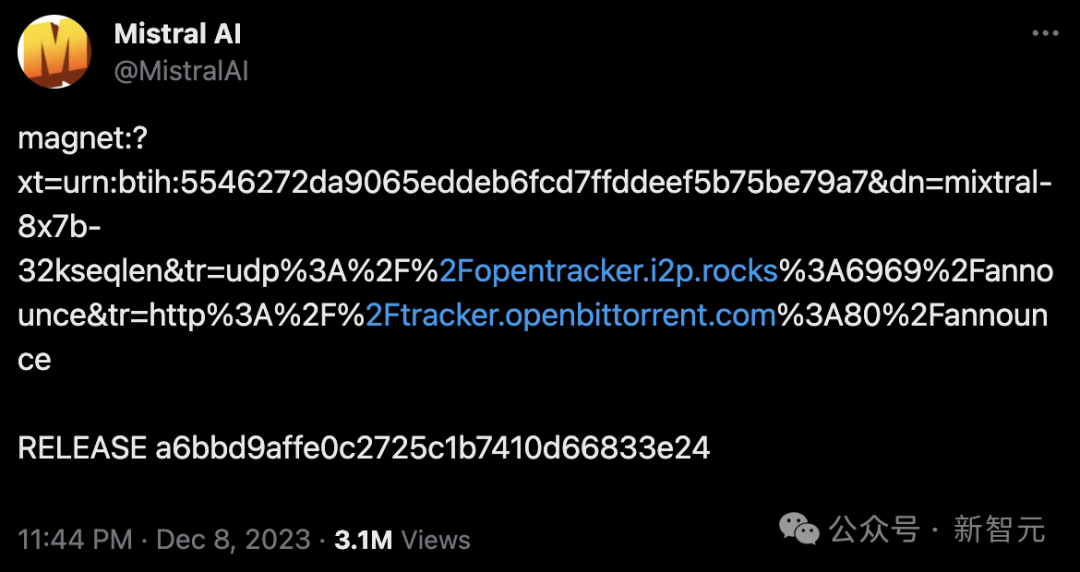

靠磁力链火遍整个AI社区

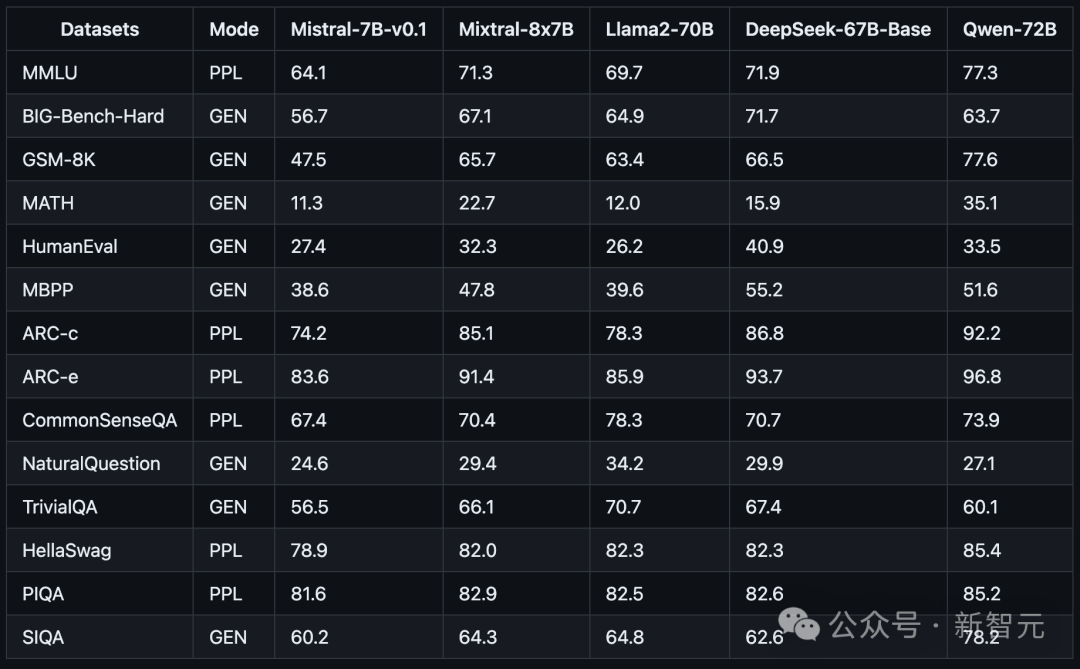

去年12月,首个磁力链发布后,Mistral AI公开的8x7B的MoE模型收获了不少好评。

基准测试中,8个70亿参数的小模型性能超越了多达700亿参数的Llama 2。

它可以很好地处理32k长度的上下文,支持英语、法语、意大利语、德语和西班牙语,且在代码生成方面表现出强大的性能。

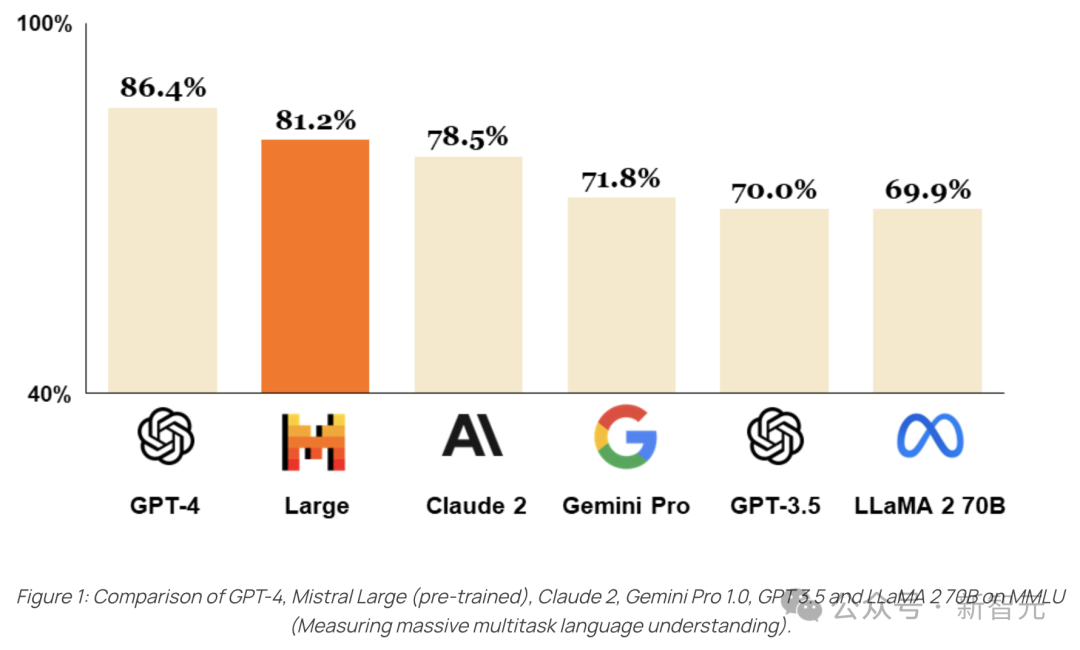

今年2月,最新旗舰版模型Mistral Large问世,性能直接对标GPT-4。

不过,这个版本的模型没有开源。

Mistral Large具备卓越的逻辑推理能力,能够处理包括文本理解、转换以及代码生成在内的复杂多语言任务。

也就是半个月前,在一个Cerebral Valley黑客松活动上,Mistral AI开源了Mistral 7B v0.2基础模型。

这个模型支持32k上下文,没有滑动窗口,Rope Theta = 1e6。

现在,最新的8x22B MoE模型也在抱抱脸平台上上线,社区成员可以基于此构建自己应用。

参考资料:

https://twitter.com/MistralAI/status/1777869263778291896

本文参与?腾讯云自媒体分享计划,分享自微信公众号。

原始发表:2024-04-10,如有侵权请联系?cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录

相关产品与服务

腾讯云服务器利旧

云服务器(Cloud Virtual Machine,CVM)提供安全可靠的弹性计算服务。 您可以实时扩展或缩减计算资源,适应变化的业务需求,并只需按实际使用的资源计费。使用 CVM 可以极大降低您的软硬件采购成本,简化 IT 运维工作。