深度学习NLP - 激活函数

激活函数

作用:为模型添加非线性因素,使模型具有拟合非线性函数的能力。

什么是线性函数:导函数为常数,那么这个函数是线性函数

Sigmoid

公式:

图形:

作用: 将实数域(向量)映射到(0,1)区间;避免梯度爆炸

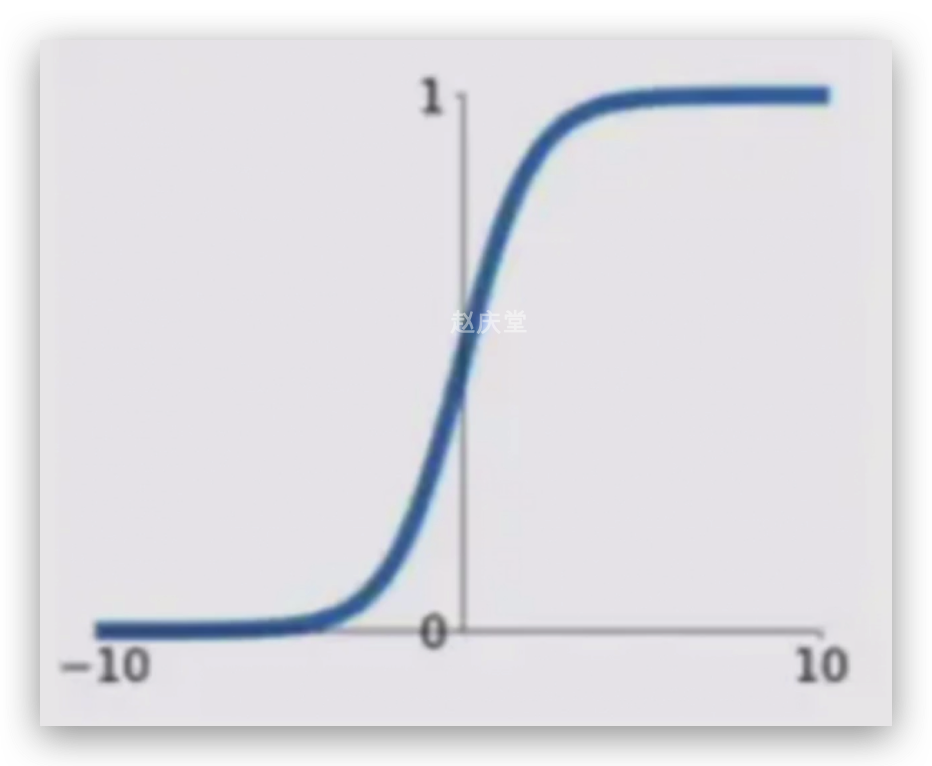

tanh

公式:

图形:

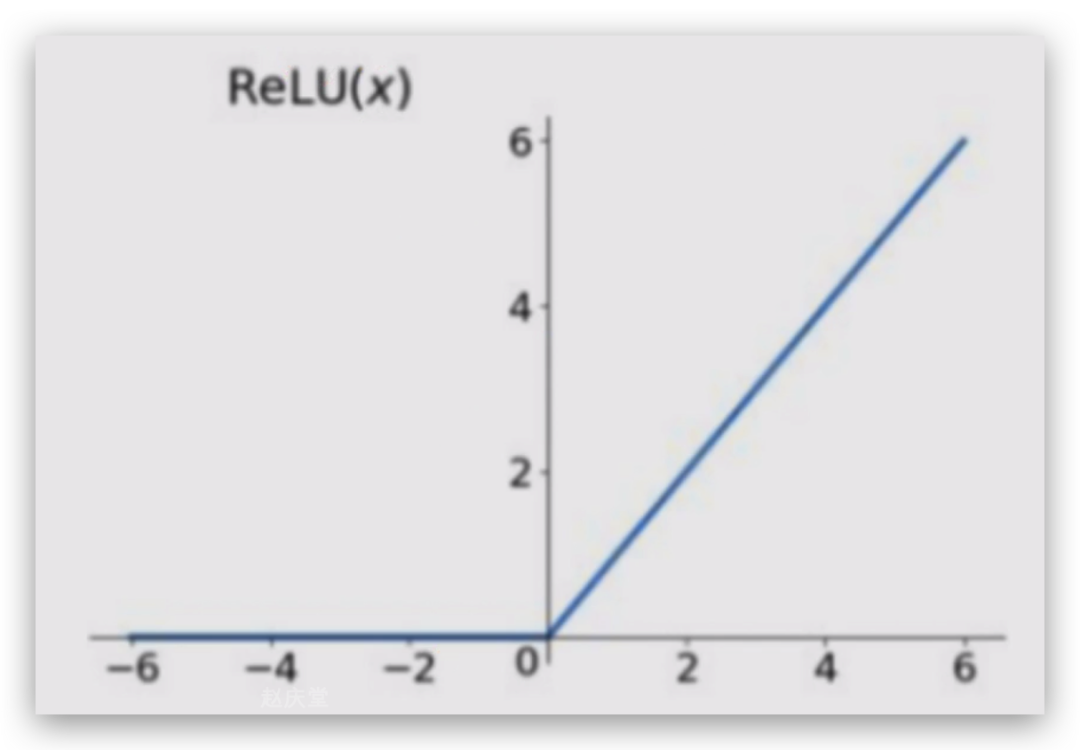

Relu

公式: Relu = max(0, x)

图形:

Softmax

公式:

作用:归一化,预测出的结果为概率分布,加和为1

本文参与?腾讯云自媒体分享计划,分享自微信公众号。

原始发表:2024-04-23,如有侵权请联系?cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录