Pytorch激活函数最全汇总

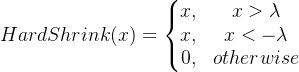

Pytorch激活函数最全汇总

向AI转型的程序员都关注了这个号???

为了更清晰地学习Pytorch中的激活函数,并对比它们之间的不同,这里对最新版本的Pytorch中的激活函数进行了汇总,主要介绍激活函数的公式、图像以及使用方法,具体细节可查看官方文档。

目录

1、ELU

2、Hardshrink

3、Hardsigmoid

4、Hardtanh

5、Hardswish

6、LeakyReLU

7、LogSigmoid

8、PReLU

9、ReLU

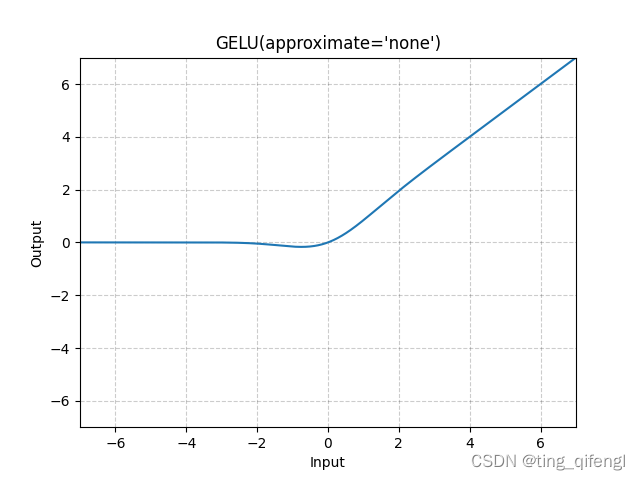

10、ReLU6

11、RReLU

12、SELU

13、CELU

14、GELU

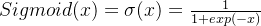

15、Sigmoid

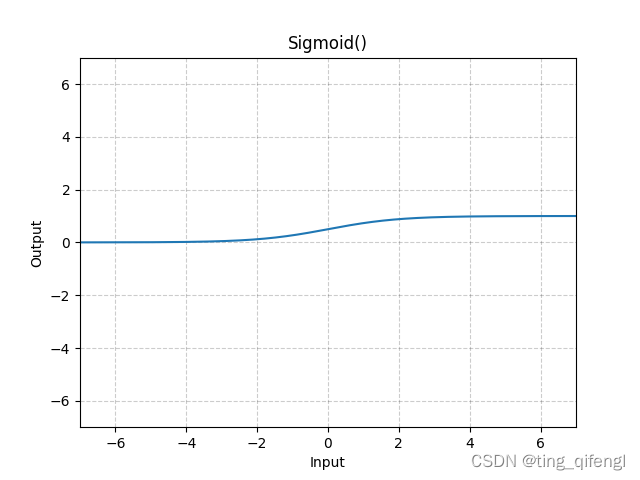

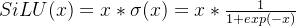

16、SiLU

17、Mish

18、Softplus

19、Softshrink

20、Softsign

21、Tanh

22、Tanhshrink

23、Threshold

24、GLU

25、Softmin

26、Softmax

27、LogSoftmax

28、其它

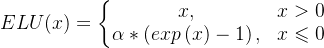

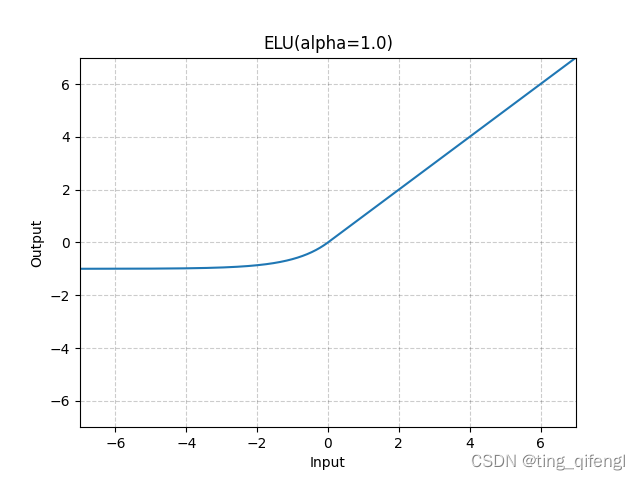

1、ELU

公式:

图像:

示例:

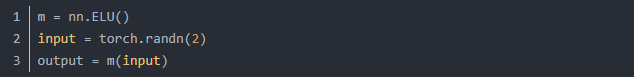

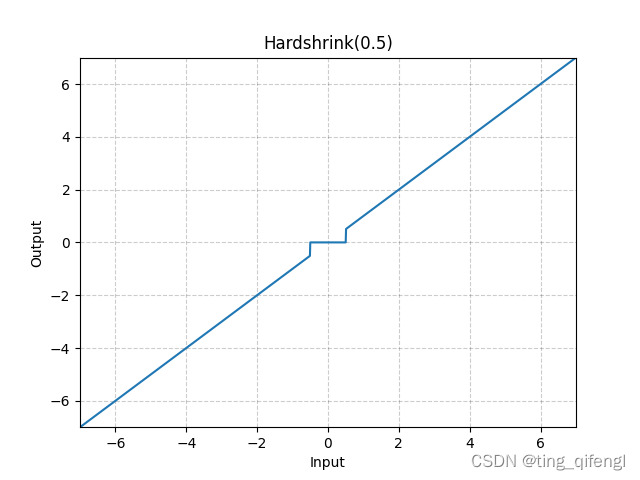

2、Hardshrink

公式:

图像:

示例:

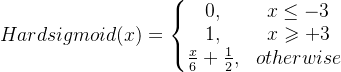

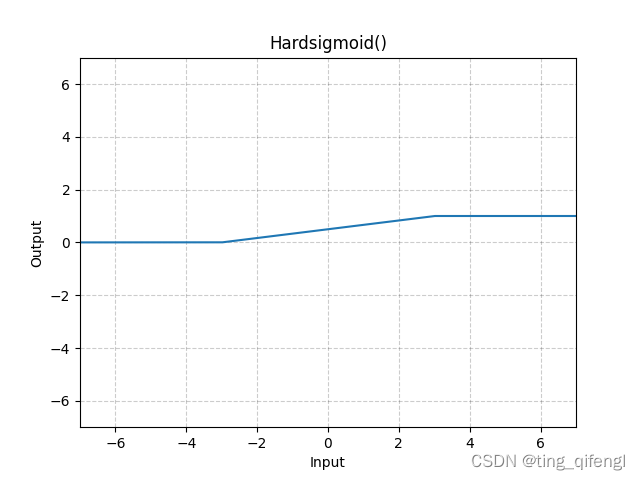

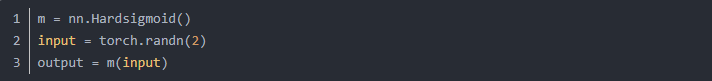

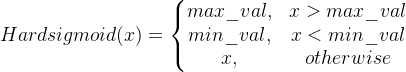

3、Hardsigmoid

公式:

图像:

示例:

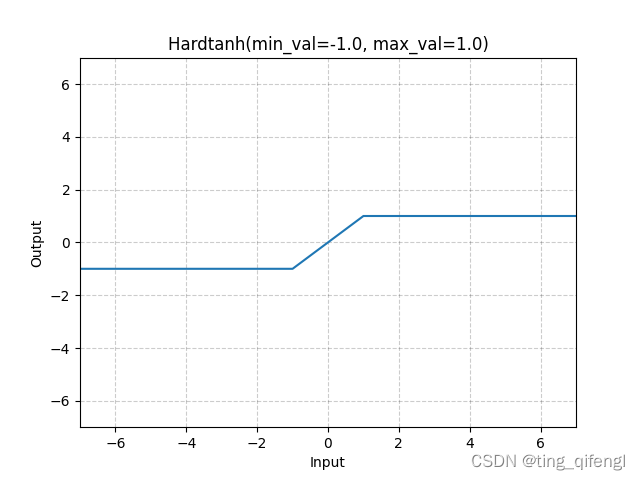

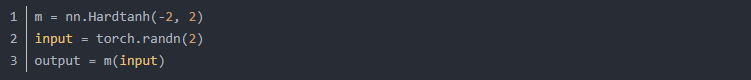

4、Hardtanh

公式:

图像:

示例:

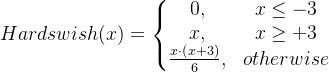

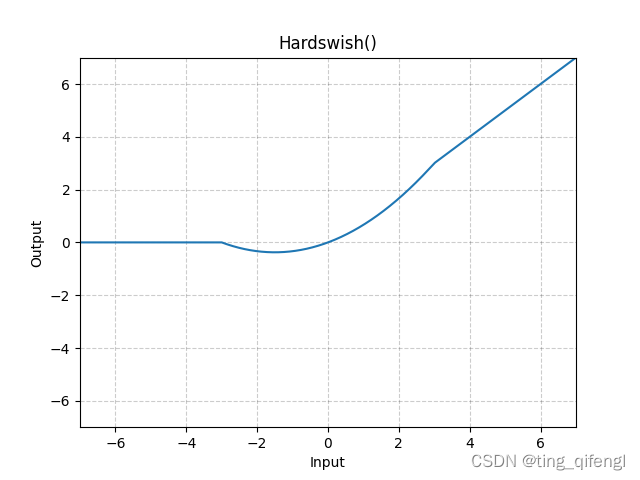

5、Hardswish

公式:

图像:

示例:

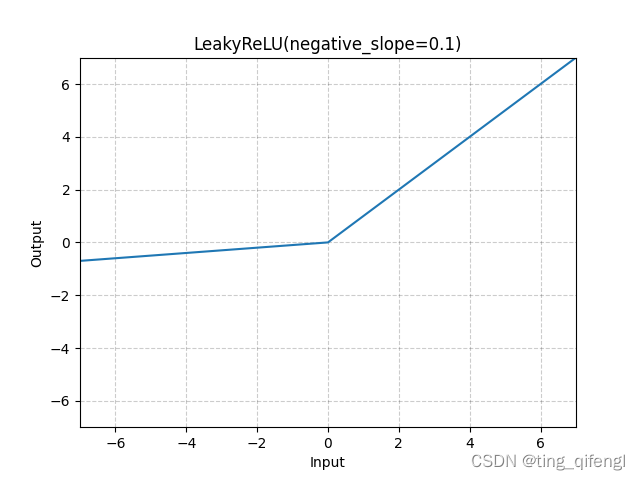

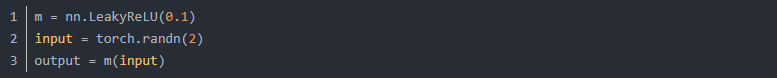

6、LeakyReLU

公式:

图像:

示例:

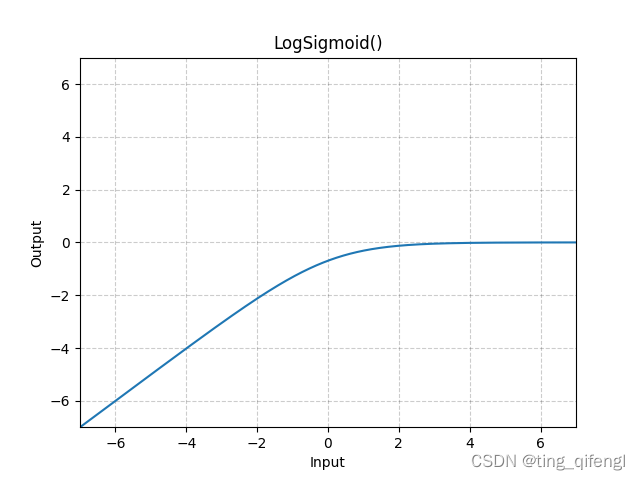

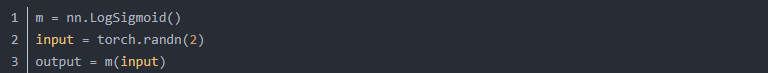

7、LogSigmoid

公式:

图像:

示例;

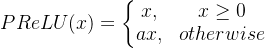

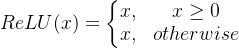

8、PReLU

公式:

其中,a是可学习的参数。

图像:

示例:

m = nn.PReLU()

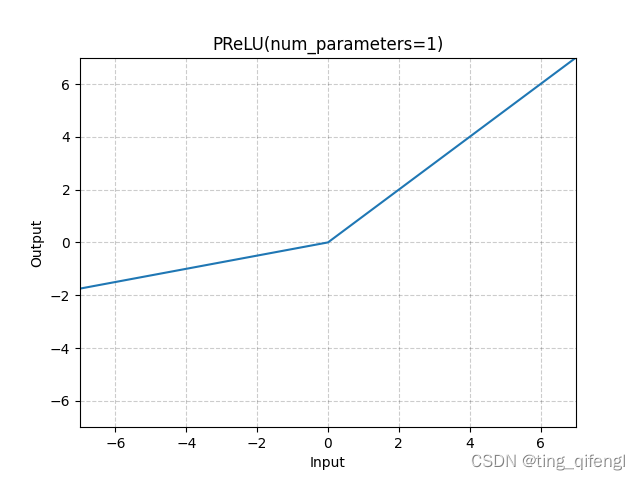

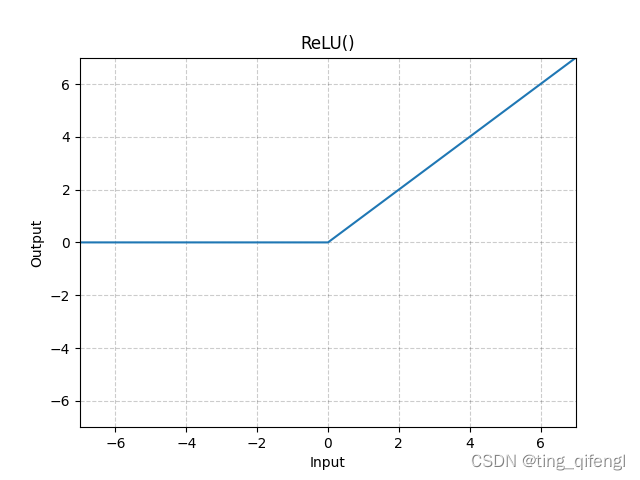

9、ReLU

公式:

图像:

示例:

m = nn.ReLU()

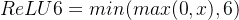

10、ReLU6

公式:

图像:

示例:

m = nn.ReLU6()

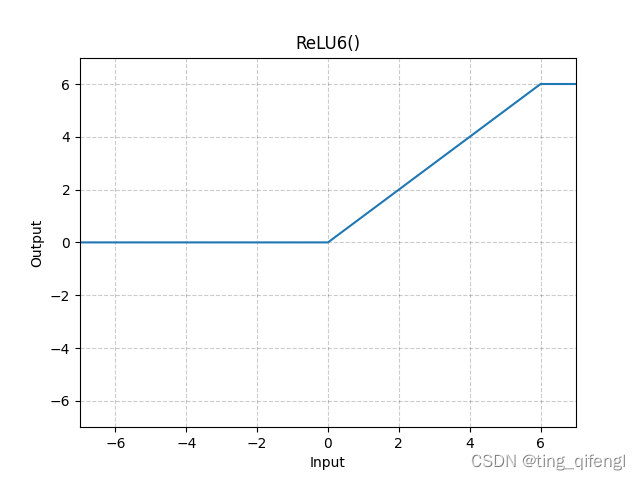

11、RReLU

公式:

其中,a从均匀分布U(lower,upper)随机采样得到。

图像:

示例:

m = nn.RReLU(0.1, 0.3)

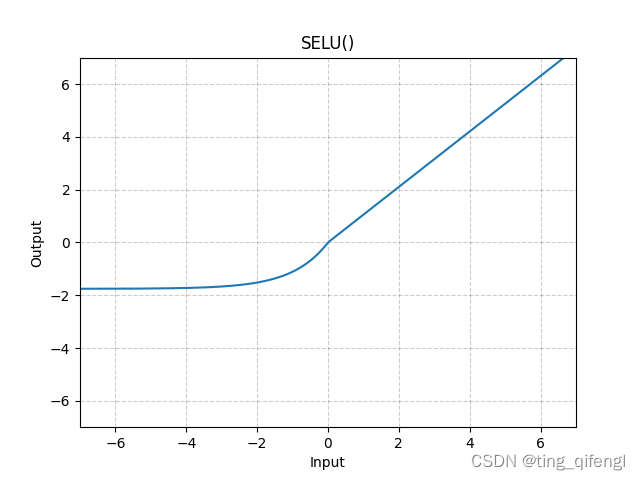

12、SELU

公式:

其中,a=1.6732632423543772848170429916717,scale=1.0507009873554804934193349852946。

图像:

示例:

m = nn.SELU()

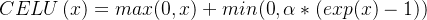

13、CELU

公式:

图像:

示例:

m = nn.CELU()

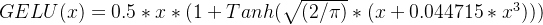

14、GELU

公式:

图像:

示例:

m = nn.GELU()

15、Sigmoid

公式:

图像:

示例:

m = nn. Sigmoid()

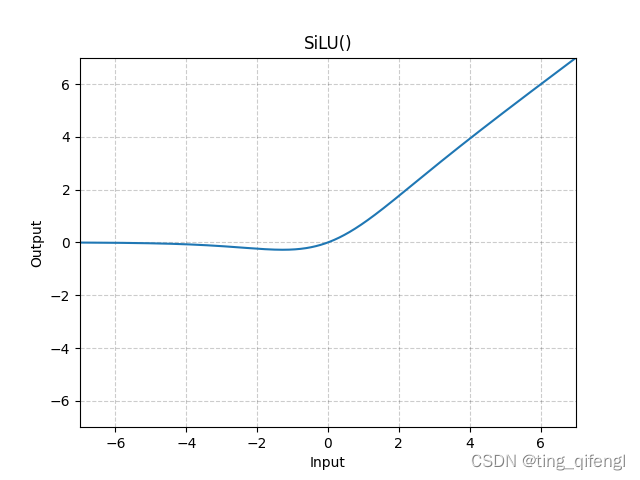

16、SiLU

公式:

图像:

示例:

m = nn.SiLU()

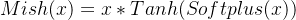

17、Mish

公式:

图像:

示例:

m = nn.Mish()

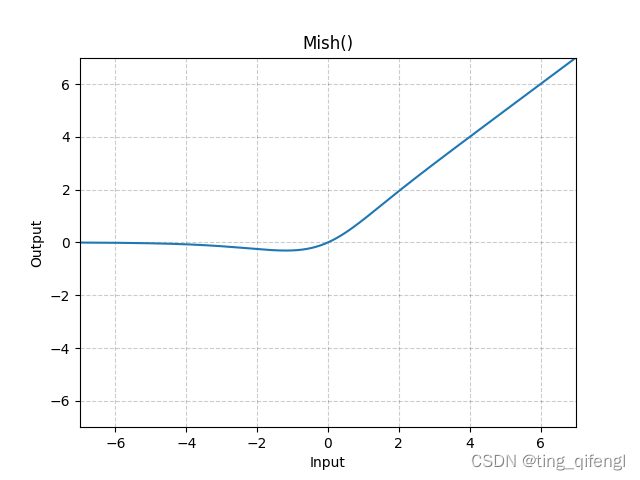

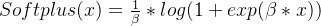

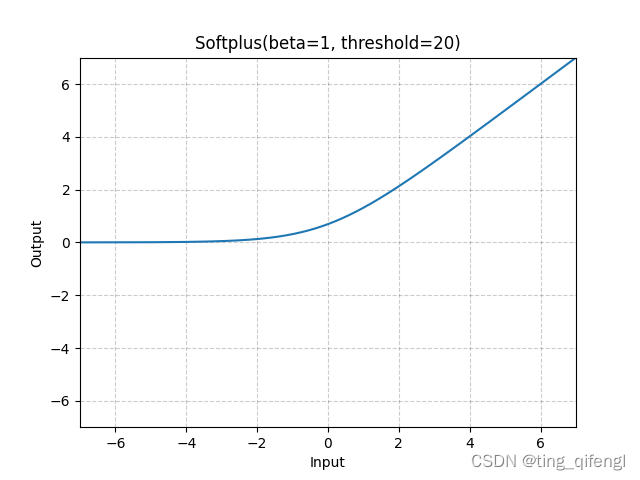

18、Softplus

公式:

对于数值稳定性,当

时,恢复到线性函数。

图像:

示例:

m = nn.Softplus()

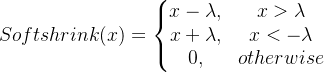

19、Softshrink

公式:

图像:

示例:

m = nn.Softshrink()

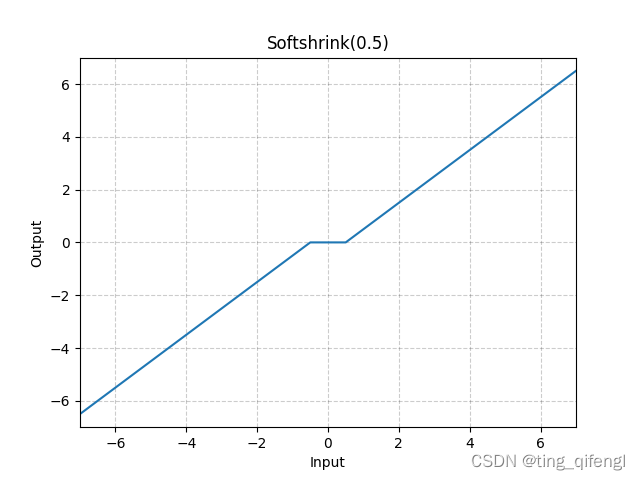

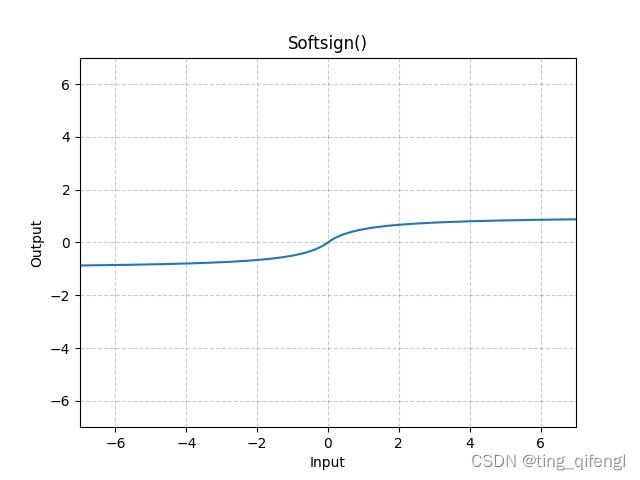

20、Softsign

公式:

图像:

示例:

m = nn.Softsign()

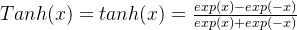

21、Tanh

公式:

图像:

示例:

m = nn.Tanh()

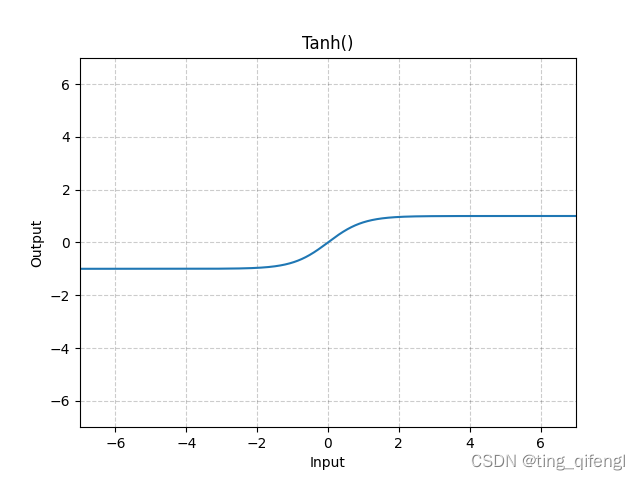

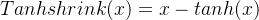

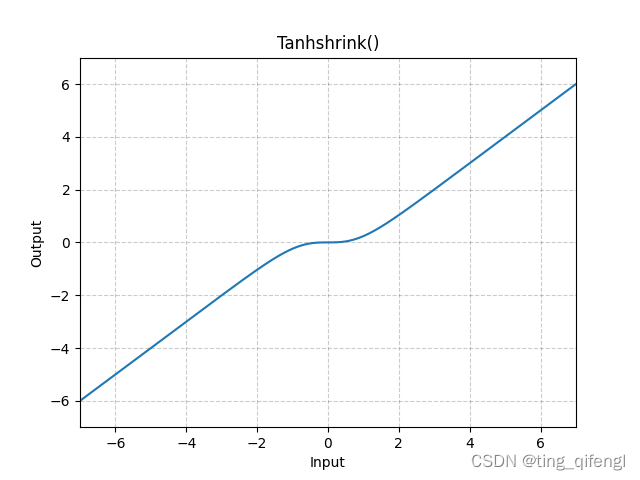

22、Tanhshrink

公式:

图像:

示例:

m = nn.Tanhshrink()

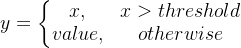

23、Threshold

公式:

示例:

m = nn.Threshold(0.1, 20)

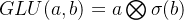

24、GLU

公式:

其中,a是输入矩阵的前半部分,b是后半部分。

示例:

m = nn.GLU()

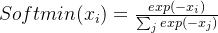

25、Softmin

公式:

示例:

m = nn.Softmin(dim=1)

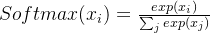

26、Softmax

公式:

示例:

m = nn.Softmax(dim=1)

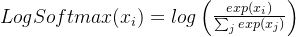

27、LogSoftmax

公式:

示例:

m = nn.LogSoftmiax(dim=1)