学习规则的视觉抽象推理概率溯因

学习规则的视觉抽象推理概率溯因

通过‘向量符号架构中的学习规则’进行视觉抽象推理的概率溯因

在OOD测试中显著优于LLMs

背景信息:

通向一般人工智能的桥梁之一 未来十年的人工智能和超维向量计算

AI的TCPIP协议I:超维计算(向量符号体系结构)综述,第一部分:模型和数据转换

AI的TCPIP协议II:超维计算(向量符号体系结构)综述II 应用及认知模型

摘要?????????

抽象推理是人类智能的基石,而用人工智能(AI)复制它则是一个持续的挑战。本研究着重于通过使用分布式计算和矢量符号体系结构(VSA)提供的运算符,高效解决雷文逐步矩阵(RPM)的问题,这是一种用于评估抽象推理能力的视觉测试。与硬编码与RPM相关的规则公式不同,我们的方法可以通过对训练数据的一次遍历来学习 VSA 规则公式(因此命名为 Learn-VRF)。然而,我们的方法具有简洁的参数,仍然是透明且可解释的。Learn-VRF在I-RAVEN的内部数据上产生准确的预测,并在未见过的属性规则对上展现出强大的越界能力,明显优于包括大型语言模型在内的纯连接主义基线。

1 简介

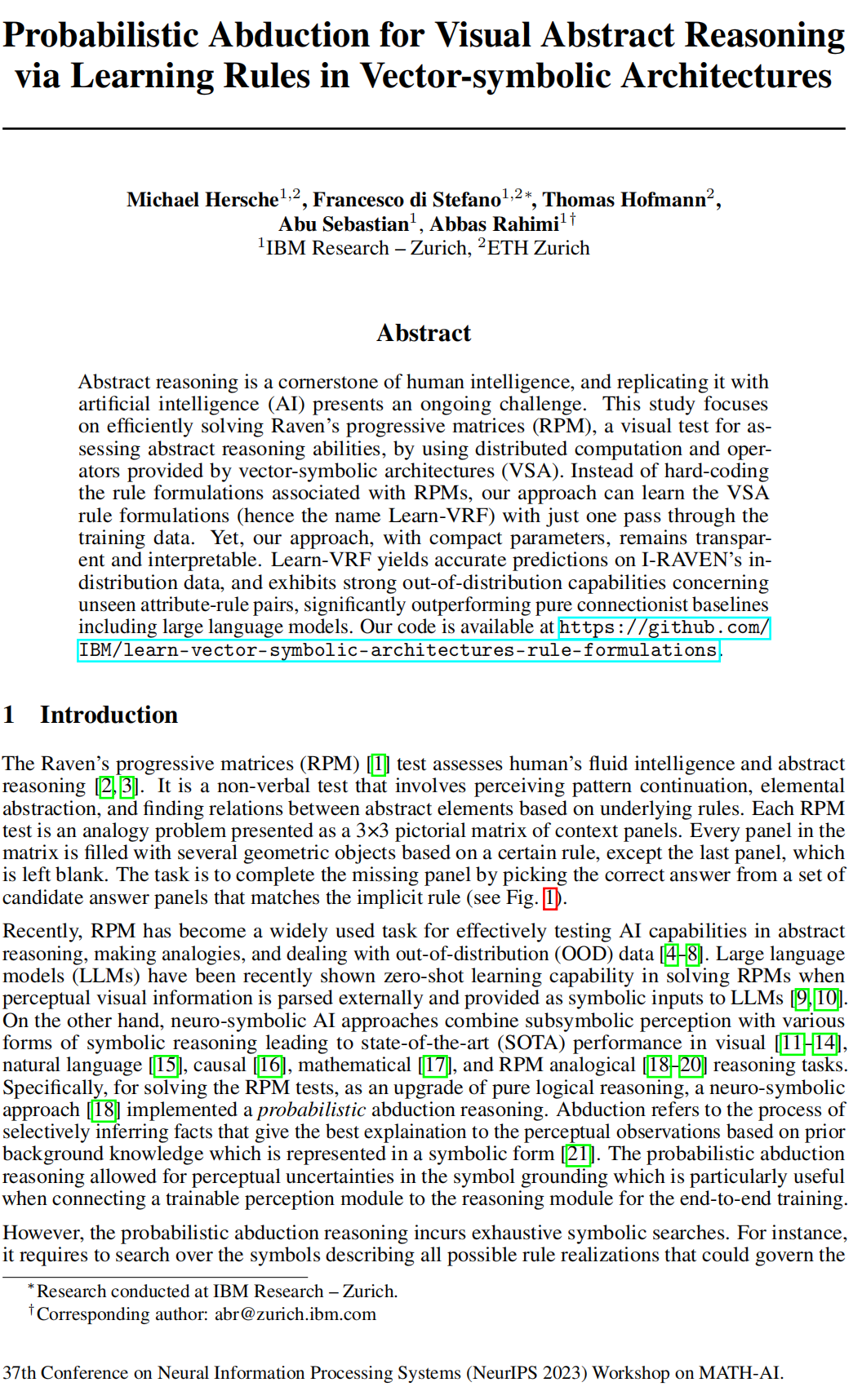

雷文逐步矩阵(RPM)[1] 测试评估人类流体智力和抽象推理[2, 3]。这是一种非语言评估,涉及感知模式的延续,元抽象,以及基于潜在规则找到抽象元素之间的关系。每个RPM测试都是一个3×3的图形矩阵,包含上下文面板。矩阵中的每个面板都根据某个规则填充了几何对象,最后一个面板除外,它是空白的。任务是通过从一组候选答案面板中选择符合隐含规则的正确答案来完成缺失的面板(见图1)。

最近,RPM已成为在抽象推理、类比思维和处理分布之外(OOD)数据方面有效测试人工智能能力的广泛任务[4–8]。最近表明,当感知视觉信息被外部解析并提供为LLMs的符号输入时,大型语言模型(LLMs)具有零-shot学习能力,能够解决RPM问题[9, 10]。另一方面,神经符号AI方法将亚符号感知与各种形式的符号推理结合起来,在视觉[11–14]、自然语言[15]、因果[16]、数学[17]以及RPM类比[18–20]推理任务中表现出最新技术(SOTA)性能。

具体而言,为了解决RPM测试问题,作为纯逻辑推理的升级,神经符号方法[18]实现了概率绑架推理。绑架指的是有选择性地推断出对感知观察提供最佳解释的事实,这是基于以符号形式表示的先前背景知识的[21]过程。概率性绑架推理允许在符号接地中存在感知不确定性,这在将可训练的感知模块连接到推理模块进行端到端训练时特别有用。

然而,概率性绑架推理涉及详尽的符号搜索。例如,它需要搜索描述可能统治RPM测试的所有可能规则实现的符号,以便能够推导规则的概率分布[18]。减少这种搜索复杂性的一个可行选择是利用由矢量符号体系结构(VSA)[22–25]提供的分布式表示,该表示建立在支持明确定义的操作的丰富代数基础上,包括乘法绑定、解绑、加法叠加、排列和相似性搜索,从而能够在高维分布式表示之上执行符号计算。因此,提出了神经矢量符号体系结构(NVSA)[20],该体系结构利用分布式VSA表示和运算符执行可行的概率性绑架推理,提供在叠加计算中进行的两个数量级更快的推理。然而,与其他神经符号方法一样,NVSA必须仔细选择适当的运算符和操作数来制定单个RPM规则。虽然NVSA允许将领域知识纳入模型,但要求对问题具有完全的了解。

我们提出了Learn-VRF,一种新颖的概率性绑架推理方法,通过解决凸优化问题从示例中学习VSA规则公式。除了更高的灵活性、更好的普遍性和一次学习之外,Learn-VRF还保持了神经符号方法的优势,包括透明性和可解释性。Learn-VRF通过抽象掉表面统计模式,在规则空间中透明地运行。在具有提取的视觉属性标签的I-RAVEN数据集[5]上,Learn-VRF在分布内数据上取得了竞争性的准确性,并在OOD测试中显著优于LLMs [10]和神经MLP方法,同时具有数量级更低的可训练参数。

2 背景

矢量符号体系结构(VSA)通过维持维度不变的操作来操作高维分布表示,与产生高阶张量的张量积表示形成对比[15, 17, 26]。存在许多不同表示和操作的VSA变体(请参阅[27]进行回顾).在这项工作中,我们使用二进制稀疏块编码(SBC)[28],它引入了一种展现理想变量绑定属性的本地块状结构[29]。在二进制SBC中,绑定被定义为块状循环卷积(?),而近似解绑是块状循环相关(?).VSA的绑定具有类似于实数域中的乘法的属性,包括交换律、结合律和存在中性元素(e).余弦相似度(cossim(·, ·))用于衡量两个向量之间的相似性。

I-RAVEN数据集 I-RAVEN数据集[5]提供了带有无偏候选集的RPM测试。图1显示了I-RAVEN示例测试。每个RPM测试由九个上下文面板组成,排列成3x3矩阵,以及八个候选面板。面板包含根据七种不同的星座之一排列的对象。对象的属性(颜色、大小、形状、数量、位置)受不同的基础规则支配:常数、算术、级数或分布三。

3 方法

本节介绍Learn-VRF,它基于示例学习预测性的VSA规则公式,如图1所示。首先,属性值(由I-RAVEN元数据提供)被映射到独热概率质量函数(PMFs),并转换为一个VSA向量。Learn-VRF 学习了 R 个规则,这些规则在属性之间共享。每个规则生成一个带有置信度值的预测。空面板的预测表示(?a(3,3))可以是基于选择具有高置信度的规则的预测(采样),也可以是所有规则的加权组合。最后,与预测属性向量的余弦相似性之和最大的候选面板即为答案。

将 PMFs 转换为 VSA 本文专注于RPM的推理方面;因此,我们直接提取了I-RAVEN元数据提供的属性标签,这是LLMs [9, 10]的常用做法。面板中每个对象的属性被映射到属性的独热PMFs,这些PMFs进一步组合,生成描述面板属性分布的面板级PMFs [18]。每个属性产生八个PMFs(每个上下文面板一个)表示为Pc := (p(1,1), p(1,2), ...p(3,2))。接下来,我们将面板级PMFs转换为高维VSA表示:

其中,N 是面板级 PMF 空间的维度。类似于 NVSA [20],我们使用一个二进制的 SBC 字典 {bk}^N_k=1,其中每个基向量(bi)具有1024维和四个块。结合分数幂编码 [24],这个基允许对连续属性(例如颜色或大小)进行表示。不同上下文面板的 VSA 表示由 Ac := (a(1,1), a(1,2), ... a(3,2)) 表示。

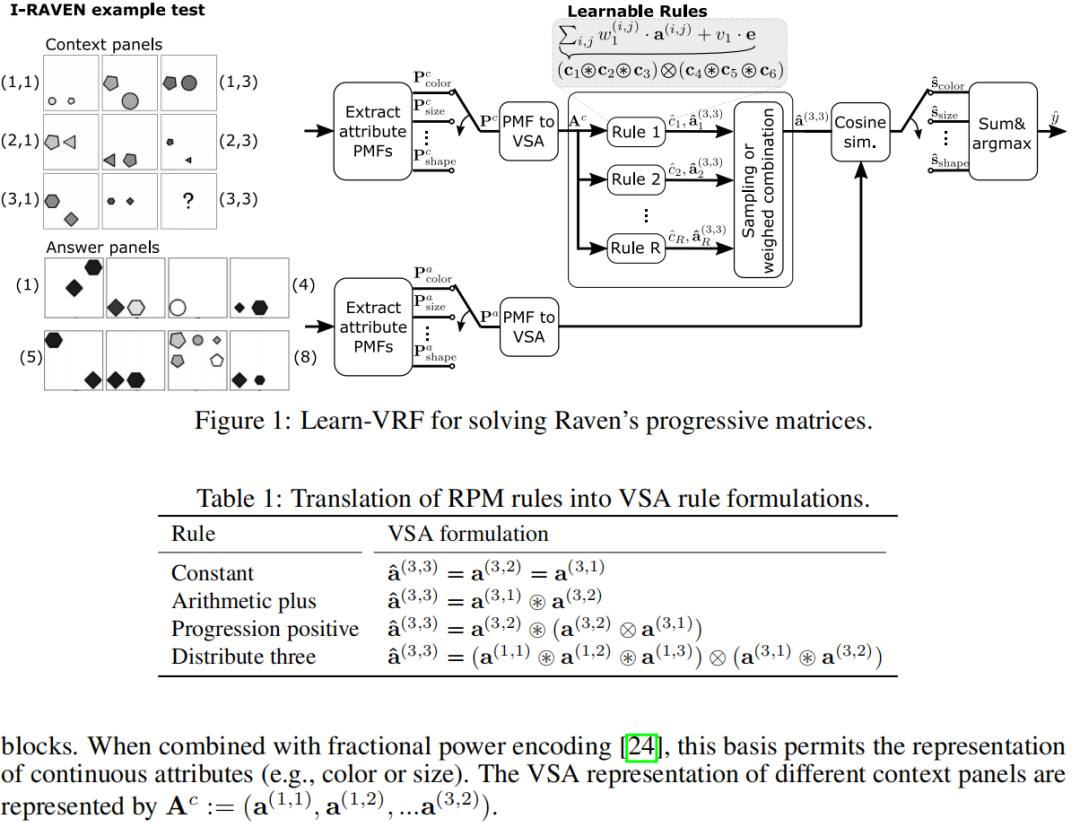

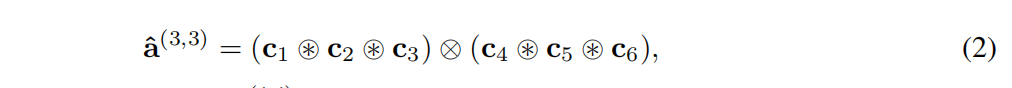

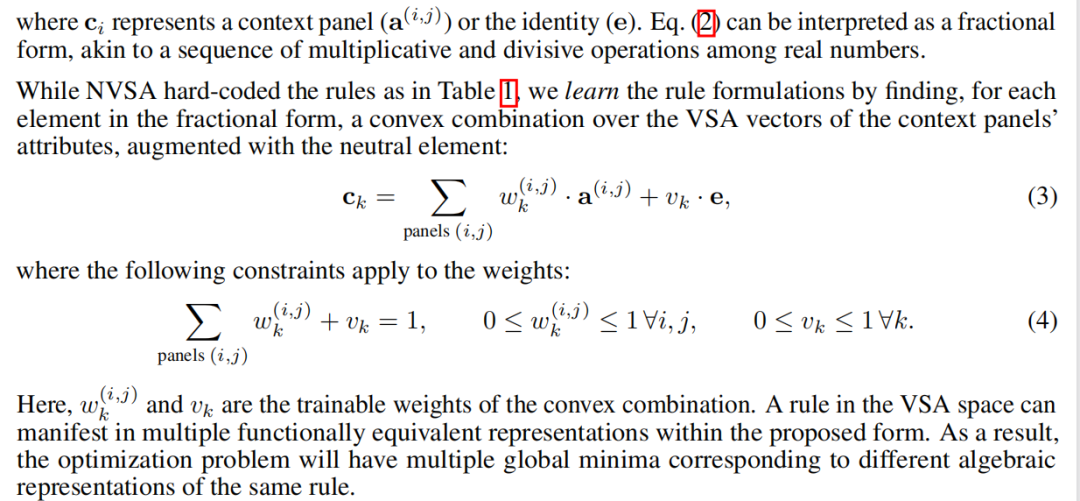

学习VSA规则公式 (Learn?VRF)VSA允许我们使用操作数(即上下文面板的选择)和操作(绑定和解除绑定)的特定规则组合来预测空面板的表示。表1总结了每个RPM规则可能的VSA公式。所有规则都表示为一系列绑定和解除绑定操作,可以概括为:

Learn?VRF学习R?many规则表述。允许比I?RAVEN中实际嵌入的规则更多的规则(即R>R* )会产生Learn?VRF来提出功能等效的重复。因此,通过提供超完备的规则空间,Learn?VRF仍然可以运行,并且不需要精确了解规则的数量(R* )。相比之下,相关的可学习神经符号方法[30]对SATNet中的属性和规则的最佳数量进行了网格搜索。为简单起见,我们将规则数量设置为 I?RAVEN 中的规则数量 (R = R* )。

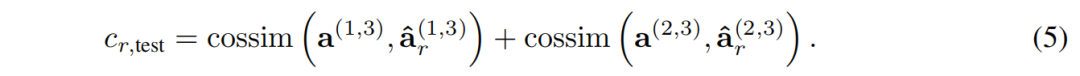

置信度值计算 每个规则(r)生成一个VSA向量(a(3,3) r ) 以及一个置信度值(cr)。置信度是通过为每个规则部署三个公式来计算的,该公式预测第三列的所有面板。在推理时,置信度值计算为第一行和第二行的预测 VSA 向量与其各自的真实向量之间的余弦相似度之和:

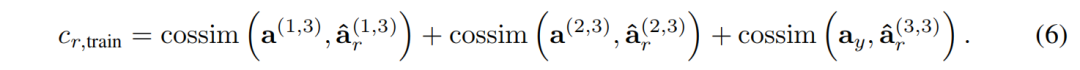

在训练期间,最后一行的真实值是可访问的,从而能够将预测面板和真实值答案(ay)之间的余弦相似度包含到置信度分数中:

使用采样或加权组合的最终估计我们区分两种变体以确定空面板的最终估计。一种变体是对具有高置信度值的规则(r^)进行采样。在训练期间,我们从置信值的分布中进行采样,而在推理时,我们选择具有最大化置信值的规则。估计面板然后定义为:

或者,我们建议使用置信度值作为权重创建所有规则的凸加权组合:

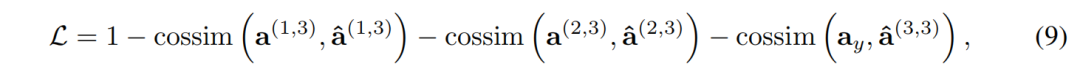

训练损失通过随机梯度下降(SGD)更新模型权重,减少所选规则的反余弦相似度作为损失:

其中a(i,3)来自采样或加权组合。从第一行和第二行导出的项完善了规则选择机制,而与真实答案相关的项则调整负责预测空面板的 VSA 向量的权重。

4 实验结果

I?RAVEN:分布内 2将Learn?VRF的准确性与SOTA深度神经网络SCL[31]、概率溯因神经符号方法(例如:PrAE[18]和NVSA[20])以及基于GPT的LLM实验进行了比较3[10]关于分布内(ID) I?RAVEN任务.作为附加基线,我们训练了一个模型,该模型使用单独的MLP预测每个属性的 PMF。应用程序.A描述了MLP基线和App.B我们的实验装置。

Learn?VRF在使用基于采样的规则选择时实现了81.3%的平均准确度,在使用加权规则组合时实现了84.1%的平均准确度,同时仅需要5 k个可训练参数。加权组合相对于采样方法的优越性能可能源于其统一的更新机制,该机制调整所有规则(包括“正确”规则)而不是仅调整采样规则.Learn?VRF在对训练数据进行单次训练时仍然准确,使用采样和加权组合分别达到 80.0%和81.0%。

Learn?VRF可以在没有位置属性(即中心、左右、上下、中心外)的星座中生成准确的预测。在这些星座中,它的性能优于GPT?3和PrAE,并且与NVSA和SCL相当.相反,2x2网格、3x3网格和出入网格需要在其位码向量上采用逻辑规则的位置属性,而VSA规则公式无法支持这一点(请参阅附录D).虽然NVSA通过处理原始PMF域中位置属性的一些规则来规避此限制,但Learn?VRF统一实现VSA空间中的所有规则,但精度有所下降.MLP基线可以提高位置相关星座的精度,但需要60倍以上的参数(300 k 与 5 k),同时也会牺牲透明度和可解释性。

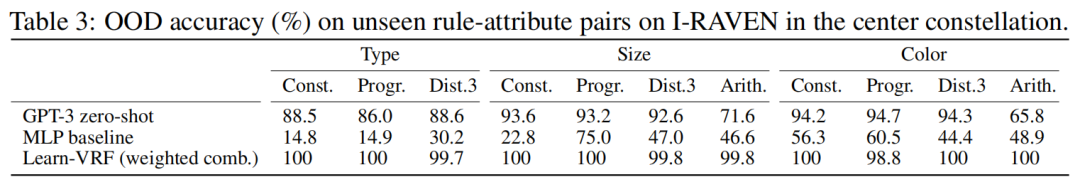

I-RAVEN:分布外 我们在未见过的环境上测试 GPT-3、MLP基线和Learn-VRF中心星座中的规则属性对,验证其OOD泛化能力(参见应用程序B).在这个OOD任务中,Learn-VRF 已经训练了 50个epoch。如表3所示,MLP尽管基线在ID上是准确的,但在OOD中仍面临挑战。此外,GPT-3 显示了尽管存在数据污染的可能性,但准确性较低,尤其是算术规则[32],并且我们为进行情境学习而付出的额外努力(参见附录 E).相比之下,Learn-VRF概括了到OOD,借助 Learn-VRF 的规则,在大多数规则属性对上实现了近乎完美的准确性共享,这是通过使用VSA空间中统一的、富有表现力的PMF表示来实现的分数功率编码。

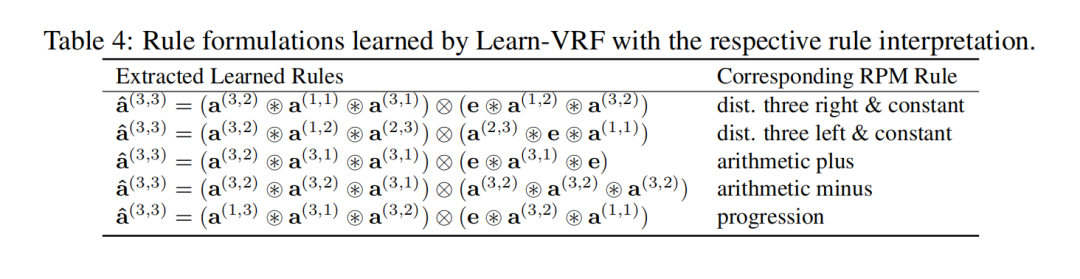

学习规则表述的解释Learn-VRF提供透明度和可解释性融入到所学的规则中。我们可以通过选择VSA向量来推导最主要的公式:在Learn-VRF模型的内部表示中,每个术语的权重最高。表 4 显示了中心星座的学习规则公式.分析这些规则并执行简单的代数简化.我们辨别出以下所示的等价性:第二栏。应用程序.C 提供了有关学习规则公式的解释的更多细节。

5 结论

我们提出了Learn-VRF,这是一种基于VSA的新颖概率溯因方法,可以学习规则表述.该模型的结构本质上提供了透明度:通过识别索引权重分布中每一项的概率质量最高,我们可以重建Learn-VRF选择的规则公式.此外,Learn-VRF具有参数数量少的特点,单遍学习以及针对未见过的属性-规则组合的OOD泛化。

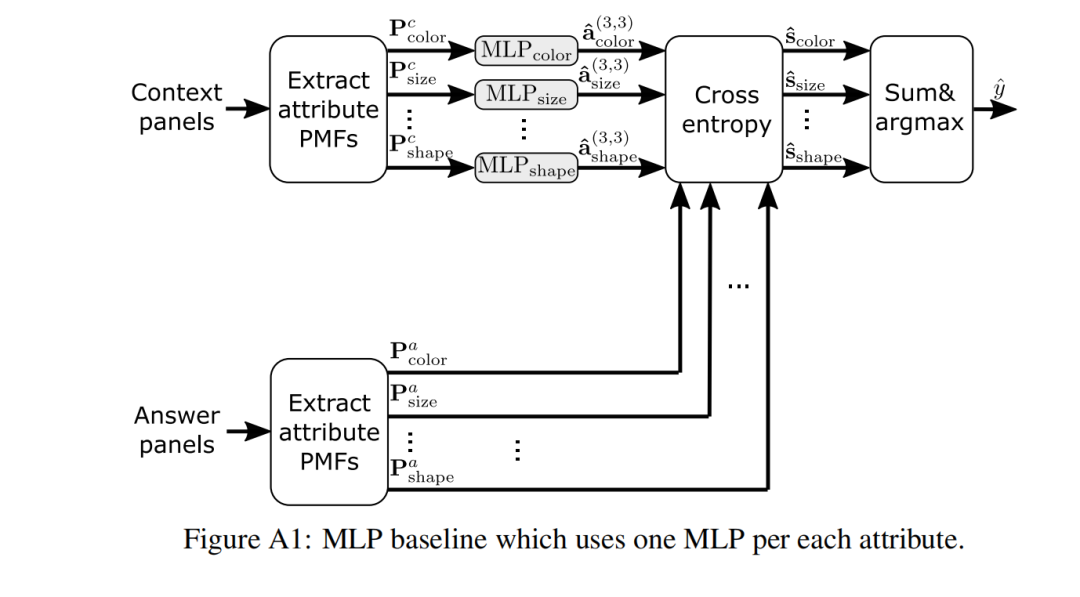

A. MLP 基线

如图A1所示,该基线是基于MLP的A实例的使用而构建的,其中A表示属性总数。MLP直接对属性PMF的转换进行建模。对于每个属性,都有一个专用的MLP,确保每个属性都是独立建模的。由于属性的PMF具有不同的维度(即不同数量的可能值),因此MLP无法在属性之间共享,而我们的Learn?VRF则可以实现,这要归功于使用基于VSA的分数功率编码,该编码允许将任意大小的 PMF向量映射到固定宽度但富有表现力的分布式表示。得益于这种统一的接口Learn?VRF 可以从一个属性即插即用到另一个属性。

MLP基线的第一步涉及处理派生的属性值。这些值被转换为one?hot PMF。一旦转换为PMF 格式,这些表示将由每层具有1024个隐藏维度的3层MLP进行处理。该MLP的输出是另一个跨越属性值的PMF。对于每个属性,使用交叉熵将其关联的PMF向量与所有候选面板的PMF向量进行比较。对于每个属性,我们获得与八个候选面板相对应的八个分数。最后,我们计算每个属性的平均值,得出八个总体候选分数。选择得分最高的候选小组。

该基线在规则选择和执行之间没有任何区别。与Learn?VRF不同,MLP可以潜在地捕获非线性关系,例如2x2网格、3x3网格和out?in网格中位置属性中存在的逻辑规则。

B 实验装置

训练设置

在我们使用MLP基线的实验设置中,我们使用了三个隐藏层,每个隐藏层包含1024个神经元。在连续层之间应用层归一化。我们将学习率设置为1e?4,使用的批量大小为32,并对模型进行50轮训练。选择这些时期中验证损失最低的模型来对测试数据集进行进一步评估。

在Learn?VRF中,我们使用1024维、4个块的VSA向量。此外,我们使用的学习率为0.1,批量大小为4。我们将可学习规则(R)的数量设置为等于I?RAVEN中规则的数量.最后,我们使用了0.01的softmax温度,有利于利用而不是探索,使我们能够快速收敛。

OOD 测试设置

在分布外(OOD)实验中,我们评估模型在包含所有属性的示例上进行训练后是否可以解决看不见的目标属性?规则对(例如,类型属性上的常量规则)?除特定目标规则对之外的规则对(例如,关于大小和颜色的恒定规则、关于所有属性的渐进规则以及关于所有属性的分布规则)。

我们生成一个新的训练和验证集,其中包含除具有目标属性?规则对的示例之外的所有示例,以及一个仅包含具有目标属性?规则对的示例的测试集。

在这些实验中,我们关注中心单个星座,因为它包含单个面板。相反,诸如上下、左右和进出之类的配置需要两个中心单星座,从而在应用属性规则过滤时引入歧义。

数据集是通过过滤现有的分割I?RAVEN生成的。训练集包含2622到3437个样本,验证集包含 841到1160个样本,测试集包含803到1117个样本。

C Learn-VRF中学到的规则公式的解释

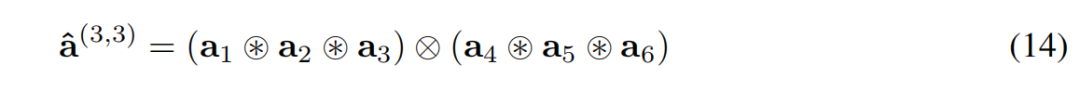

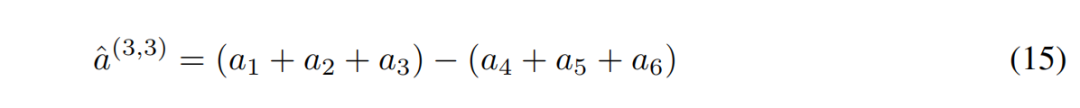

在Learn?VRF中,VSA空间中的单一规则可以通过各种同义表示来描述。作为示例,让我们检查最后一行的算术加法规则:

该规则可以通过多种方式重新表述为VSA分数形式,该规则的所有可能代数形式的示例子集如下:

当对来自Learn?VRF的结果VSA向量及其相关目标VSA向量采用回归损失函数时,损失曲线的全局最小值与同一规则的不同代数解释一致。

D 模型的局限性

Learn?VRF模型的主要限制在于其表达能力。为了理解这一点,请考虑在VSA空间中,两个属性值的和由它们各自的VSA向量的绑定表示,而差值由解除绑定操作来描述。鉴于支持 Learn?VRF的VSA分数形式:

在数字属性空间中,这转换为:

这意味着该模型仅限于表示属性的和与差,排除了对线性组合建模的可能性。这种限制在复杂的星座中变得很明显,例如 2x2网格、3x3网格或出入网格,其中位置属性在其位码向量上采用逻辑规则。

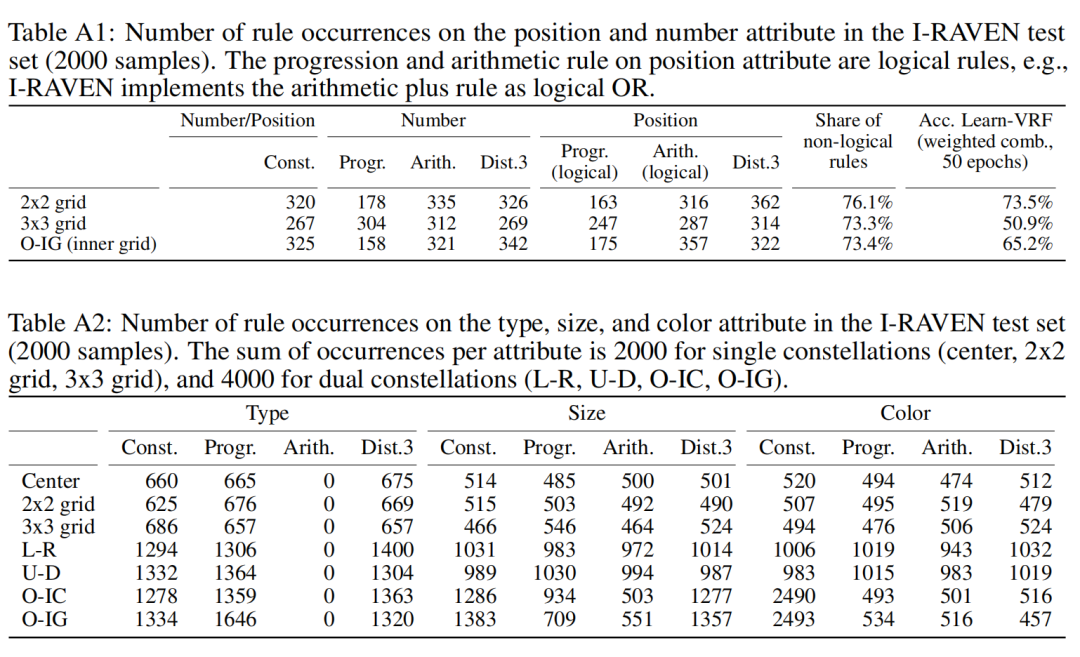

表A1和表A2分别显示了数量/位置和类型/尺寸/颜色属性的规则出现次数。在位置属性上,逻辑规则(级数和算术)在2x2网格.3x3网格和出入网格星座上分别占23.9%、26.7%和26.6%。由于Learn?VRF无法表示这些逻辑规则,因此可以通过非逻辑规则的份额来确定准确性的上限(即76.1%、73.3%和73.4%)事实上,Learn?VRF(加权组合,50个epoch)几乎达到了2x2网格的上限(73.5%vs.76.1%),而在3x3网格(50.9%vs.73.3%)和out?in网格上的性能(65.2% vs.73.4%)稍稍落后。

LLM实验

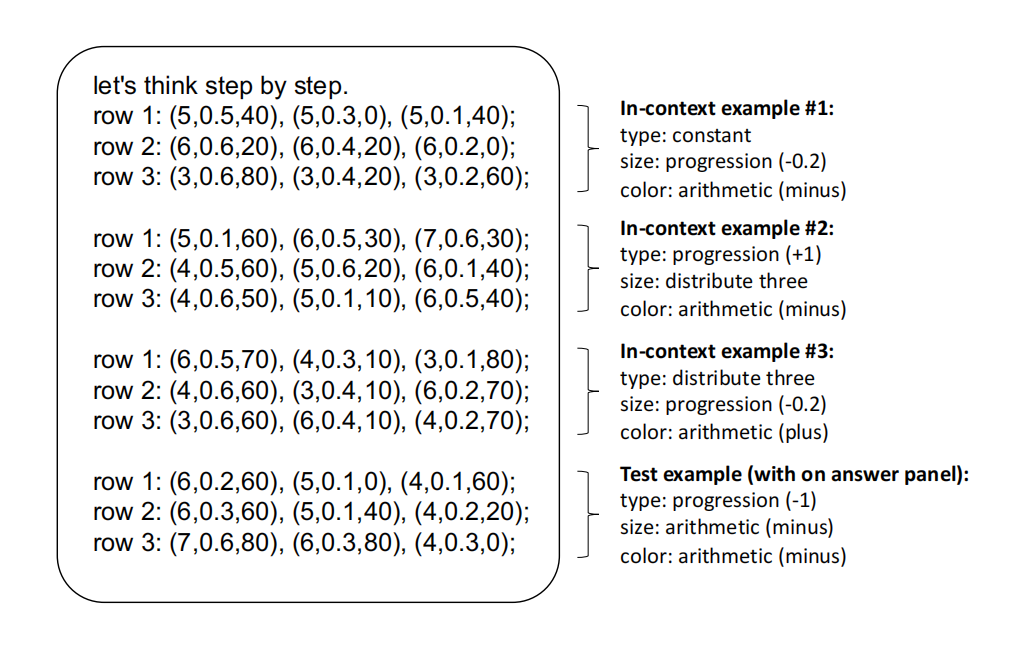

本附录描述了我们在I?RAVEN上测试GPT?3 OOD泛化的附加实验。我们的实现基于[33],它使用text?davinci?002模型。

使用两种不同的方法将属性标签转换为提示。纠结中设置(又名实体属性命名),对象的不同属性在一个实体中表示(例如,放在括号中),产生一个提示。相反,属性被完全分解为解开设置中的每个属性都有一个提示(也称为属性分解)。两种方法执行选择性分类,即通过上下文中的每个答案面板提示LLM实验矩阵并选择候选面板作为产生最高对数概率总和的答案在答案部分。在 ID 数据上,显式解开改善了 LLM 的推理:在中心

星座图上,GPT-3 在解缠结情况下的准确率达到 86.4%,在没有解缠结情况下的准确率达到 80.8%解开[33]。

我们使用解缠结设置在 OOD 测试集上测试了 GPT-3.请注意,我们没有有关用于训练 GPT-3 的数据的完整知识。因此,数据污染是可能的,即该模型可以在 RPM 上进行训练。因此,无法确定该测试是否真实面向对象; 需要创建新的综合数据集才能完全控制 OOD 测试,因为它已在合成问答数据集中完成[32]。表3显示GPT-3主要面临挑战算术规则,尺寸属性达到 71.6%,颜色达到 65.8%。

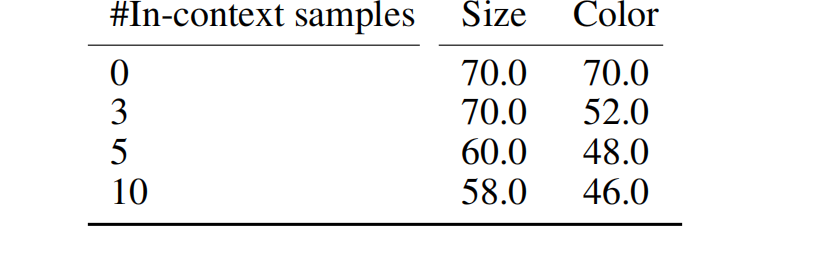

作为附加实验,我们测试了情境学习对算术规则的影响。我们随机选择的上下文示例,其中包含不同属性的算术规则从被测试的情况来看,例如,对于带有属性大小算术OOD测试,我们展示了对颜色(但不是尺寸)应用算术的其他示例。由于没有上下文示例可以在解缠结配置中显示,我们切换到纠缠设置。图A2显示一个例子。为了减少提示的量,我们只对 50 个样本的子集进行了测试,这仍然是给出趋势的指示。表 A3 中显示的结果表明情境学习在此应用中是相当有害的。进一步的努力,例如提示调整(例如,上下的选择和安排可以提高LLM实验的情境学习表现[34]。

表A3:使用 I?RAVEN OOD 测试集的子集(50个样本)进行分类准确率(%)GPT?3(纠缠设置)使用不同数量的上下文示例。

图 A2:在纠缠设置中使用三个上下文示例提示进行 GPT-3 实验。这中心星座中的单个物体被编码为(类型,大小颜色).OOD 测试侧重于属性大小的算术规则.上下文示例显示了算术规则的示例属性颜色.在此提示中,文本示例中的空白面板填充有第一个候选者面板,这不是正确的面板。