打造本地ChatGPT,部署LlaMA3最简单的方法来了!

打造本地ChatGPT,部署LlaMA3最简单的方法来了!

double

发布于 2024-04-30 16:28:56

发布于 2024-04-30 16:28:56

你好,我是郭震

现在还没有用上ChatGPT的朋友,现在平替方法来了,在本地部署大模型。实现与GPT几乎一样的问答效果!

这是一篇关于大模型本地部署的教程,使用目前最强开源大模型LlaMA3,这篇先总结一种最简单、操作步骤最精简的本地部署方法。主要有2步。

2024年4月19日,Meta公司发布Llama3,共有8B,70B两种参数,分为基础预训练和指令微调两种模型。与Llama2相比,Llama3使用了15Ttokens的训练数据,在推理、数学、代码生成、指令跟踪等能力获得大幅度提升。

使用完全免费。

步骤1:安装Ollama

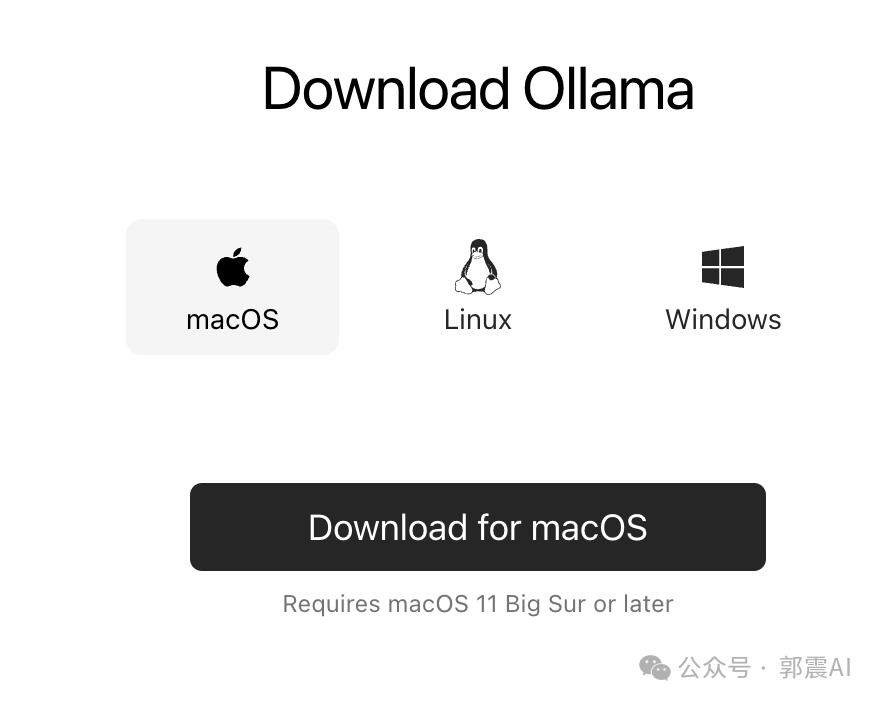

Ollama可以简单理解为客户端,实现和大模型的交互。ollama软件win和mac都包括:

在这里已经为大家准备好,只需要在我的公众号回复消息:ollama,就能下载到软件。

下载之后打开,直接点击Next以及Install安装ollama,安装步骤非常简单。

步骤2:安装Llama

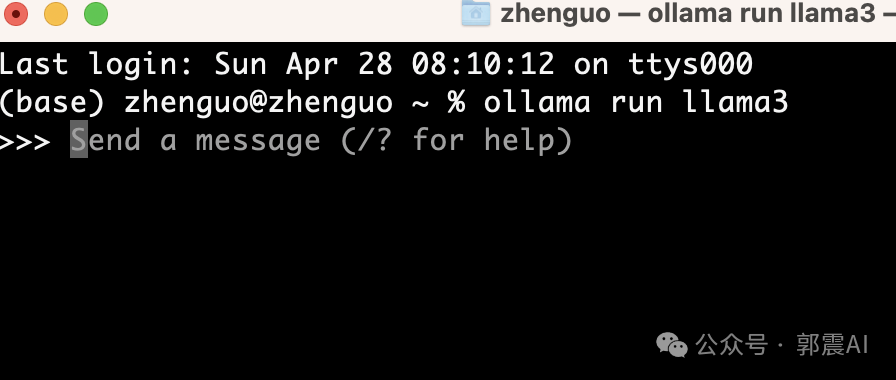

下载Llama3,打开新的终端/命令行窗口,执行以下命令:

ollama run llama3

程序会自动下载Llama3的模型文件,默认是8B,也就80亿参数版本,个人电脑完全可以运行。

等待安装完成:

以上就已经安装完毕,到现在大模型已经在本地部署完成。

使用Llama3

打开一个终端窗口,再次输入 ollama run llama3,自动就会启动,进入会话界面:

发第一条消息,你是谁,用中文回答,与Llama2相比,Llama3确实在回答速度上大幅提升,基本小于秒级:

发第二条消息,Python代码,冒泡排序,代码+解释,回答响应非常快,如下图所示:

再告诉它,用中文回答,返回中文回答结果:

总结

Llama3 本地部署大模型,这是最精简的一种方法,推荐大家先按照此方法去实践,使用起来。

本文参与?腾讯云自媒体分享计划,分享自微信公众号。

原始发表:2024-04-28,如有侵权请联系?cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录