在线教程|零门槛部署 Llama 3,70B 版本只占 1.07G 存储空间,新用户免费体验 8B 版本

在线教程|零门槛部署 Llama 3,70B 版本只占 1.07G 存储空间,新用户免费体验 8B 版本

作者:十九

编辑:李宝珠,三羊

Llama 3 实际用例包括但不限于:征求建议、集体讨论、分类、封闭式问答、编程、创意写作、信息抽取、角色扮演、开放式问答、逻辑推理、文本重写以及总结等。

4 月 18 日,Meta 宣布开源 Llama 3,这个号称「迄今为止最好的开源大模型」一经发布,立刻引爆科技圈!

发布当天恰逢斯坦福大学教授、AI 顶尖专家吴恩达的生日,作为 AI 开源倡导者,他激动地发文表示:这是我收到过最好的生日礼物,谢谢 Meta。

Meta 首席科学家、图灵奖获得者 Yann LeCun 也在自己的账号上硬核推荐了自己的最新开源模型——支持 8k 长文本,在 24k GPU 集群上使用超过 15T tokens 进行训练,在多项评测基准中表现优异,部分任务中,Llama 3-8B 的表现优于 Llama 2-70B。更多版本将在数月后发布。

据其官网显示,Llama 3 采用了包括监督微调 (SFT)、近端策略优化 (PPO) 和直接策略优化 (DPO) 在内的先进指令调优技术,与 Llama 2 相比有质的飞跃。在安全性上,采用 Llama Guard 2、Code Shield、CyberSec Eval 2 的新版信任和安全工具,比 Llama 2 有更好的「错误拒绝表现」。

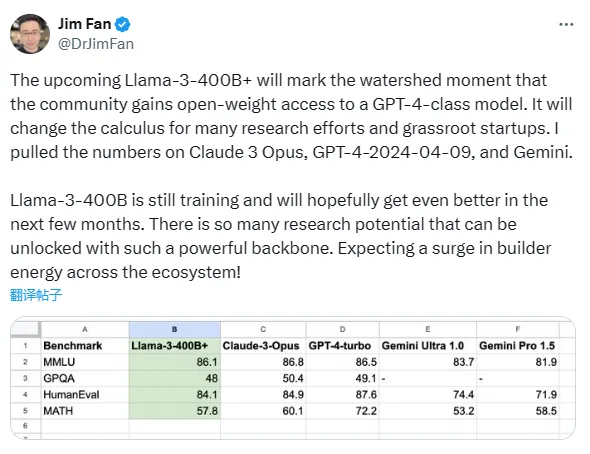

值得一提的是,Llama 3 发布时,Meta 还在官方博客上表示,其正在训练一款超过 400B 参数的新版本模型。英伟达高级科学家 Jim Fan 认为,未来可能推出的 Llama 3-400B 标志着开源社区或能用上 GPT-4 级别模型,这会改变许多研究工作和基层初创公司的计算方式。

为了评估 Llama 3 在真实世界场景中的性能,Meta 特意开发了一个全新的高质量人类评估数据集,覆盖的实际用例包括但不限于:征求建议、集体讨论、分类、封闭式问答、编程、创意写作、信息抽取、角色扮演、开放式问答、逻辑推理、文本重写以及总结等。

结果表明,在与 Claude Sonnet、Mistral Medium 和 GPT-3.5 的比较中,Meta Llama 70B 占据优势地位。

性能超越 GPT-3.5、直逼 GPT-4,相信大家现在都迫不及待地想要上手体验 Llama 3 了。为了帮助大家减少漫长的下载等待时间,节省计算资源,降低模型部署难度,HyperAI超神经在教程页面上线了「使用 Ollama 和 Open WebUI 部署 Llama3-8B-Instruct」和「使用 Ollama 和 Open WebUI 部署 Llama3-70B」教程。

* Ollama 和 Open WebUI 分别提供了强大的后端模型管理和前端界面交互功能,结合使用这两个工具,可以轻松完成大模型的部署和管理。

Llama3-70B 只占用 1.07GB 的存储空间,一键克隆即可启动!

HyperAI超神经教程地址:

* 8B:https://hyper.ai/tutorials/31129

* 70B:https://hyper.ai/tutorials/31155

小编已经根据教程部署了 Llama 3 模型,帮大家浅试了一下实际效果。

* 小编故意引导了一下 Llama 3,结果它没被骗到。但是同样的问题却骗过了 GPT-3.5!看它一本正经地回答问题,小编忍不住快要相信了。

* 五一快要来了,假期去哪里玩,这么多地方选哪个呢?

* 数学问题它也能解决哦,再也不用头疼给家里的小朋友辅导功课了!

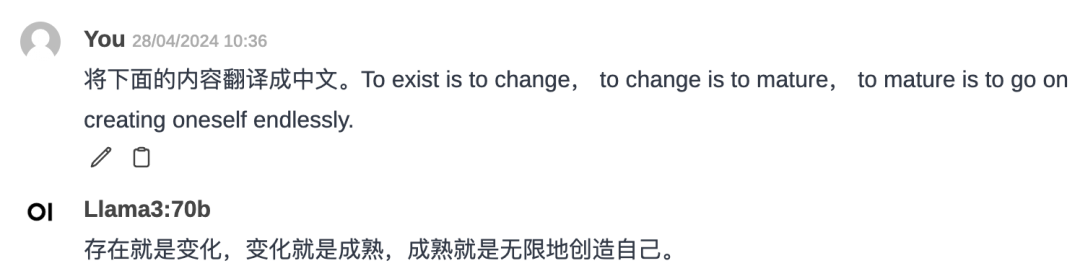

* 还可以翻译,解决我大麻烦了!

* 睡前小故事,又一个技巧 get 到了。

Demo 运行

1. 登录 hyper.ai,在「教程」页面,选择「使用 Ollama 和 Open WebUI 部署 Llama3-8B-Instruct」或「用 Ollama 和 Open WebUI 部署 Llama3 70B」。

接下来小编将以「使用 Ollama 和 Open WebUI 部署 Llama3-70B」教程为例介绍。

2. 点击「在线运行此教程」,页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

3. 点击右下角「下一步:选择算力」。

4. 跳转后,选择「NVIDIA RTX A6000 48GB 」、选择镜像「PyTorch」,点击「下一步:审核」。新用户使用下方邀请链接注册,还可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费算力时长!

HyperAI超神经专属邀请链接(直接复制到浏览器打开即可注册):

https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

注意:如果运行的是「使用 Ollama 和 Open WebUI 部署 Llama3-8B-Instruct」教程,选择「NVIDIA GeForce RTX 4090」运行即可。

5. 点击「继续执行」,等待分配资源,当状态变为「运行中」后,点击「打开工作空间」。

6. 打开工作空间后,在启动页新建一个终端会话,然后在命令行里输入以下内容,启动 Ollama。

OLLAMA_MODELS=/openbayes/home/ollama-models ./ollama serve

7. 再新建一个终端页面,然后在命令行里输入以下内容,启动 Open WebUI。

bash /openbayes/input/input1/open-webui/backend/start.sh

8. 稍等片刻,当命令行出现「INFO:Uvicorn running on http://0.0.0.0:8080」后,拷贝右侧 API 地址到浏览器地址栏中,即可打开 Open WebUI 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果展示

1. 打开 Open WebUI 界面后,登录账号。

账号:admin@example.com

密码:adminadmin

2.选择 Llama 3-70B 模型。

3.输入问题,即可使用啦。

目前,HyperAI超神经官网已上线了数百个精选的机器学习相关教程,并整理成 Jupyter Notebook 的形式。

点击链接即可搜索相关教程及数据集:

https://hyper.ai/tutorials

以上就是小编本次分享的全部内容了,希望这次的内容对您有所帮助。如果大家还想学习其他好玩的教程,欢迎留言或私信告诉我们项目地址,小编将会为你量身打造课程,教你如何玩转 AI。

参考资料:

1.https://mp.weixin.qq.com/s/bw1-e9Nou7CeR-9iaGNLNA

2.https://mp.weixin.qq.com/s/GoxWufZhemddpvCkOwYAKg

3.https://mp.weixin.qq.com/s/tkMb2RRblCvOpxP7yBTl-w