数据不平衡问题

数据不平衡问题

对于一些二分类问题或者多分类问题,部分类别数据相较于其它类别数据而言是要小得多的,这种现象就是数据不平衡问题。数据不平衡问题会导致什么情况呢?假如是基于一些特征判断病人是否患有该疾病,且该疾病是一个小概率获得的疾病,假设概率为0.0001, 那么表明有10000个来看病的人中只有一个人患有该疾病,其余9999个人都是正常病人。如果用这样的一批数据进行训练模型算法,即使该模型什么都不学,都判定为正常人,其准确率高达0.9999, 完全满足上线要求。但我们知道,这个模型是不科学的,是无用的模型。这种数据分布严重不平衡的情况下,模型将具有严重的倾向性,倾向于数据样本的多的类别,因为模型每次猜样本多对应的类别的对的次数多。因此,如果直接将严重数据不平衡的数据拿来直接训练算法模型,将会遇到上述问题。一般在10倍以上可以判定为数据不平衡问题。

解决办法

解决数据不平衡的方法比较多,这里大致罗列一下,具体原理可以针对每种方式去详细搜索对应的文章介绍,这里不做过多的解释。

- 欠采样(Under sampling): 欠采样是一种通过保留少数类中的所有数据并减少多数类的大小来平衡不均匀数据集的技术。简单来说就是少样本数据全部保留,对多样本数据按照小样本的数量及比例采样量级差不是那么大的多样本数据,比如说正样本10个,负样本1000个,二者相差两个量级。那么可以对负样本进行采样,从中随机选100个,再与正样本10个作为训练数据,这样二者的数量差距不会太大。但该方法显然存在缺点,即部分负样本数据没有被使用,丢失潜在的重要信息。

- 优点:多数样本与少数样本到达相同量级,数据变少导致更少的存储需求和运行时间;

- 缺点:导致数据丢失,丢失潜在的重要信息,多数类选择的样本可能有偏差;

- 随机选择(Random under sampling):从多数类中随机删除事件;

- 基于最近邻欠采样(Nearest neightbors sampling):在散点图上,保持从多数类到少数类的三个最接近事件的平均距离最小的事件;

- Tomek Links sampling: 通过删除 Tomek 链接来采样,寻找 Tomek 链接用来定位所有跨类的最近邻居。如果少数类中的例子保持不变,那么这个过程可以用来找到多数类中最接近少数类的所有例子,然后移除;

- 编辑最近邻(edited nearest neighbors): 该规则涉及使用 k = 3最近邻来定位数据集中那些被错误分类的例子,然后在应用 k = 1分类规则之前删除这些例子;

- One-sided selection: OSS 结合了 Tomeks Links和 NN, 首先识别并移除大多数类的类边界上的Tomeks links, 并基于NN从多数类中删除冗余样本;

- Neighborhood cleaning rule(NCR):通过 ENN 去除噪声或模糊的样本,该技术保留下来的是高质量的数据;

- 采样方法:

- 优缺点:

- 过采样(over sampling):过采样技术是对少样本进行扩增,使得少样本数据能变多的一种技术。

- 优点:不会丢失来自原始培训集的信息

- 缺点:随机采样复制导致数据集扩大,造成模型训练复杂度增加,另外容易造成模型过拟合问题,不利于算法的泛化能力

- 重复复制:随机重复复制少样本数据

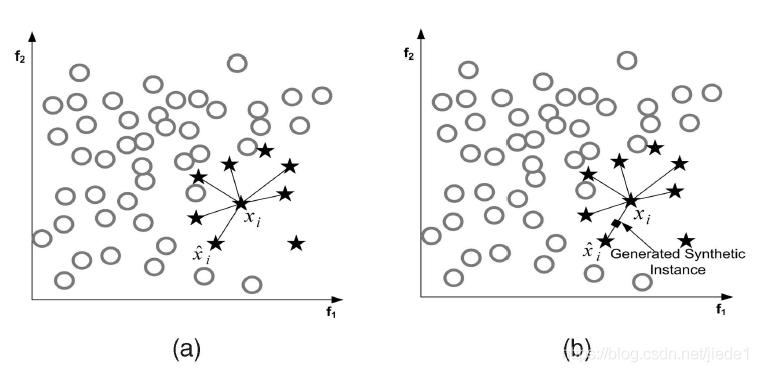

- SMOTE:基本思想就是对少数类别样本进行分析和模拟,并将人工模拟的新样本添加到数据集中,进而使原始数据中的类别不再严重失衡。该算法的模拟过程采用了KNN技术,模拟生成新样本的步骤如下:

- 采样最邻近算法,计算出每个少数类样本的K个近邻;

- 从K个近邻中随机挑选N个样本进行随机线性插值;

- 构造新的少数类样本;

- 将新样本与原数据合成,产生新的训练集;

- ADASYN:建立在 SMOTE 方法的基础上,通过将分类边界的重要性转移到那些困难的少数类

- Augmentation:通过添加已有数据的略微修改的副本或从现有数据中新创建的合成数据来增加数据量的技术

- 采样方法:

在这里插入图片描述

- 优缺点:

- 转化为一分类问题:将分类问题转变为异常检测问题

- 多模型集成:对两类样本选取 N 组不同比例的数据进行训练并测试,得出模型预测的准确率;然后基于各模型的准确率进行归一化处理,得到新的权重分布;按权重分布 组合多个模型,作为最终的训练器

- Loss函数设计方面,对正负样本给予不同的权重:比如focal loss等

在这里插入图片描述

- 评价指标的选取,一般来说,使用AUC PR作为评价指标,在不平衡分类问题上的性能表征是更加准确的。

结论

- 样本不均衡会影响模型精度

- 随着分类任务复杂度的上升,样本不均衡对模型的影响会显著上升

- 样本不均衡问题导致模型精度下降的原因不仅是训练样本的减少,主要是因为样本类别的分布

- 在绝大多数多分类任务中,过采样是最能有效抑制样本不均衡的方法

- 在部分样本极度不平衡的情况下,欠采样和过采样取得相近的效果;如果出于训练时间的考虑,选择欠采样更为合适

- 为了达到更好的精度,在采样的基础上对分类器的概率输出进行优化,即采用采样-阈值联合的优化方式可达到更加的分类精度

- 与传统机器学习不同,过采样方法并不会引起卷积神经网络的过拟合问题

参考

- https://www.mastersindatascience.org/learning/statistics-data-science/undersampling/

- https://blog.csdn.net/qq_37151108/article/details/105344107

- https://zhuanlan.zhihu.com/p/44055312

- https://blog.csdn.net/jiede1/article/details/70215477

- https://zhuanlan.zhihu.com/p/368352445

- Undersampling Algorithms for Imbalanced Classification

- https://en.wikipedia.org/wiki/Oversampling_and_undersampling_in_data_analysis

- https://developer.aliyun.com/article/177007

- 分类样本不平衡问题

- https://www.zhihu.com/question/435795754/answer/1638366440

本文参与?腾讯云自媒体分享计划,分享自微信公众号。

原始发表:2023-02-02,如有侵权请联系?cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录