文本情感识别系统python+Django网页界面+SVM算法模型+数据集

原创文本情感识别系统python+Django网页界面+SVM算法模型+数据集

原创

一、介绍

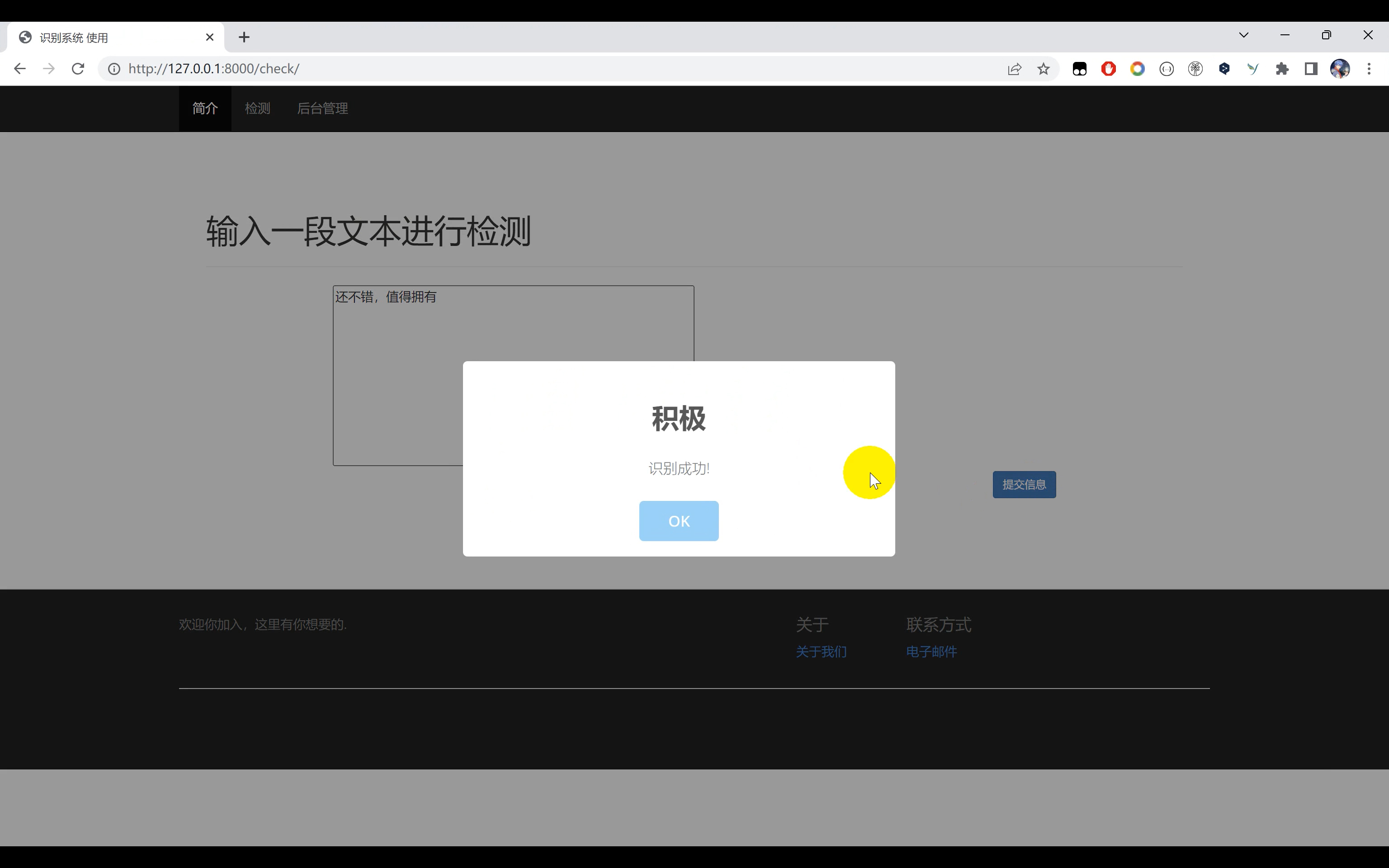

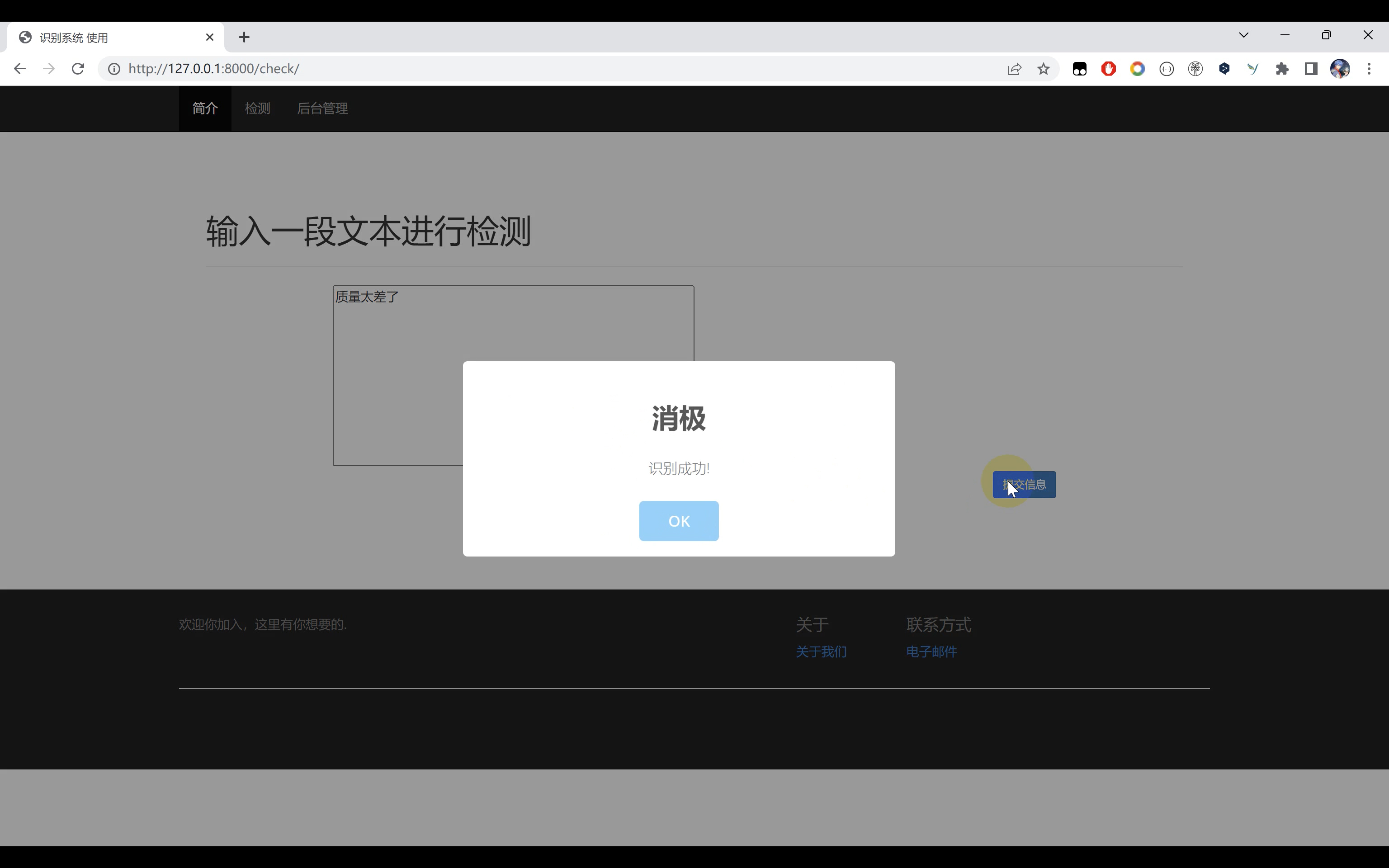

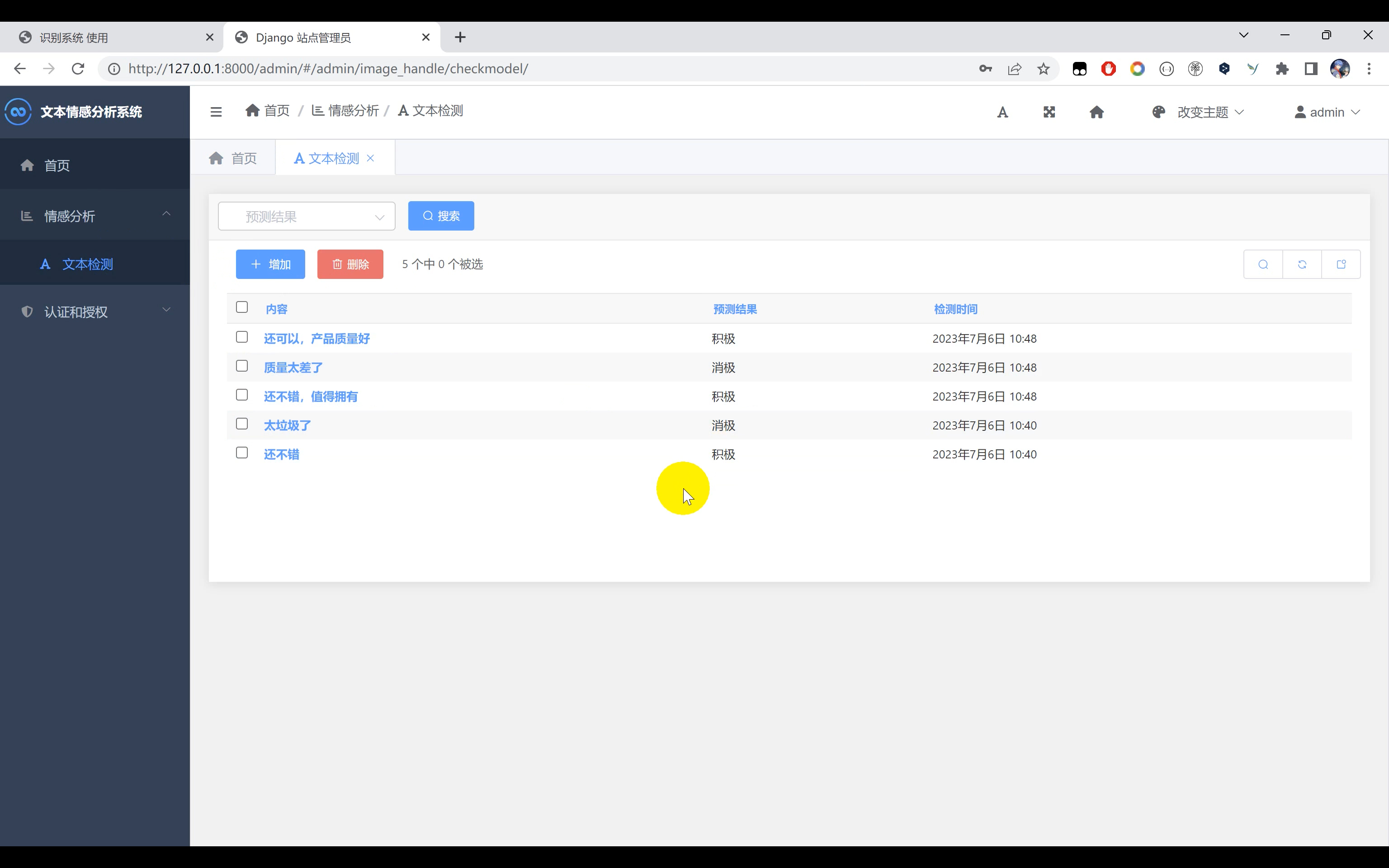

文本情感分析系统,使用Python作为开发语言,基于文本数据集,使用Word2vec对文本进行处理。通过支持向量机SVM算法训练情绪分类模型。实现对文本消极情感和文本积极情感的识别。并基于Django框架开发网页平台实现对用户的可视化操作和数据存储。

二、效果展示

三、演示视频

视频+代码:https://www.yuque.com/ziwu/yygu3z/yn2icplnbkwafd10

四、Word2vec介绍

当今社会,文本处理在自然语言处理领域中占据着重要地位。Word2Vec是一种常用的文本处理方法,它能够将文本数据转化为向量表示,从而实现文本的语义分析和比较。本文将介绍如何使用Python中的gensim库来实现Word2Vec算法,并附有相应的代码示例。

首先,我们需要确保已经安装了所需的Python库。Word2Vec库通常是通过gensim库来实现的,因此我们需要使用以下命令来安装它们:

pip install gensim

pip install numpy

pip install nltk接下来,我们需要导入所需的库和模块:

import nltk

from gensim.models import Word2Vec

from nltk.corpus import stopwords

from nltk.tokenize import sent_tokenize, word_tokenize我们将使用一个示例文本进行演示,可以是任何英文文本。在这里,我们使用《白鲸记》作为示例。首先,我们需要加载文本数据:

# 加载文本数据

nltk.download('gutenberg')

from nltk.corpus import gutenberg

raw_data = gutenberg.raw('melville-moby_dick.txt')接下来,我们需要将文本数据进行预处理。预处理的主要目的是去除文本中的噪声和冗余信息,使得Word2Vec能够更好地进行向量化处理。在这里,我们将使用NLTK库来完成预处理的任务。NLTK库是Python中常用的自然语言处理库,其中包含了许多有用的函数和工具。

我们首先将文本进行分句和分词处理。分句将文本拆分成句子,而分词则将句子拆分成单词。我们可以使用NLTK库中的sent_tokenize和word_tokenize函数来完成这些操作。示例代码如下:

# 分句

sentences = sent_tokenize(raw_data)

# 分词

tokenized_sentences = [word_tokenize(sentence.lower()) for sentence in sentences]在分词之后,我们还可以进行一些其他的预处理步骤,比如去除停用词、标点符号和数字。停用词是那些在文本中频繁出现但通常没有实际意义的词语,比如"the"、"and"等。我们可以使用NLTK库中提供的停用词列表进行去除。示例代码如下:

# 去除停用词、标点符号和数字

stop_words = set(stopwords.words('english'))

filtered_sentences = []

for sentence in tokenized_sentences:

filtered_sentence = [word for word in sentence if word.isalpha() and word not in stop_words]

filtered_sentences.append(filtered_sentence)在预处理完成之后,我们可以使用Word2Vec库来训练我们的词向量模型了。Word2Vec库提供了两种训练模式:连续词训练(CBOW)和跳字模型(Skip-gram)。在这里,我们将使用Skip-gram模型进行训练。示例代码如下:

# 训练Word2Vec模型

model = Word2Vec(filtered_sentences, size=100, window=5, min_count=1, sg=1)

# 查找与给定词最相似的词

similar_words = model.wv.most_similar('whale')

print(similar_words)在上面的代码中,我们首先创建了一个Word2Vec模型对象,传入经过预处理的句子列表filtered_sentences作为训练数据。参数size表示生成的词向量的维度,window表示窗口大小,min_count表示最小词频阈值,sg表示训练模式选择了Skip-gram模型。

接着,我们可以使用训练好的Word2Vec模型来查找与给定词最相似的词。在示例代码中,我们查找与词'whale'最相似的词,并打印出结果。

除了查找相似词之外,Word2Vec还可以用于计算词语之间的相似度。我们可以使用similarity方法来计算两个词之间的余弦相似度。示例代码如下:

# 计算两个词之间的相似度

similarity = model.wv.similarity('whale', 'ship')

print(similarity)上述代码将计算词'whale'和词'ship'之间的余弦相似度,并将结果打印出来。

此外,我们还可以使用Word2Vec模型进行词语间的线性运算。例如,我们可以找到一个词语的向量表示并通过加减运算来找到与之相关的词语。示例代码如下:

# 找到与 'king' - 'man' + 'woman' 最相似的词

result = model.wv.most_similar(positive=['king', 'woman'], negative=['man'])

print(result)上述代码通过将'king'和'woman'加入positive参数,并将'man'加入negative参数来找到与'king' - 'man' + 'woman'最相似的词,并将结果打印出来。

通过以上代码示例,我们介绍了如何使用Python中的gensim库实现Word2Vec算法进行文本处理。我们可以通过预处理文本数据,训练Word2Vec模型,并使用模型进行相似词查询、词语相似度计算和线性运算等操作。Word2Vec算法的应用广泛,可以用于词义相似度计算、文本分类、信息检索等任务中,为我们提供了丰富的语义分析能力。希望本文对你理解和应用Word2Vec有所帮助。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。