CentOS配置Spark实验环境

原创1. 连接网络

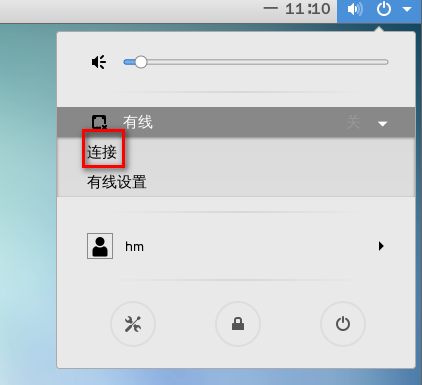

桌面右上角 电源 > 有线 > 连接

2. 安装 jdk8 和 maven

sudo yum install wget maven # maven会自动安装jdk8安装过程需要输入 y 进入下一步

如果不能用yum安装:

su #切到root

usermod -aG wheel hm

su hm

curl -O -k https://mirrors.tuna.tsinghua.edu.cn/Adoptium/8/jdk/x64/linux/OpenJDK8U-jdk_x64_linux_hotspot_8u392b08.tar.gz

mkdir ~/hadoop

tar -xzvf OpenJDK8U-jdk_x64_linux_hotspot_8u392b08.tar.gz -C ~/hadoop

mv jdk8u392-b08/ jdk8

export JAVA_HOME="~/hadoop/jdk8"

export PATH=$PATH:$JAVA_HOME/bin3. 解压安装 Spark

mkdir ~/hadoop

cd ~/hadoop

wget "https://archive.apache.org/dist/spark/spark-3.1.1/spark-3.1.1-bin-hadoop3.2.tgz"远程下载有时候速度比较慢,可以直接把本地压缩档拖到 CentOS 桌面上:

可能会拷贝出错,重试几次可以成功:

然后移动或者复制到 ~/hadoop 目录中:

cp ~/**/spark*.tgz ~/hadoop或者直接在压缩档所在目录解压到目标路径也可以

解压缩然后重命名:

tar -xzvf spark-3.1.1-bin-hadoop3.2.tgz -C ~/hadoop/

mv ~/hadoop/spark-3.1.1-bin-hadoop3.2/ ~/hadoop/spark如果解压缩失败,可能是拷贝操作失败,使用 ls -l spark* 查看文件大小,218MB的大小应该是228开头的数字,不是的话说明文件有损坏,需要删掉再拷贝多试几次

一般拷贝到桌面的文件用鼠标选中删除,其它目录也可以用文件管理界面打开用鼠标选中删除,实在不知道位置可以用命令删:

rm -f ~/**/spark*.tgz4. 配置环境变量

A. 仅对当前终端生效

直接在当前终端运行export命令:

export SPARK_HOME=~/hadoop/spark

export PATH=$PATH:~/hadoop/spark/binB. 对所有终端生效:

将export命令加入配置文件 ~/.bashrc 中:

vi ~/.bashrc启动vi后,按 G 可以定位光标到末尾行,按 o 可以在光标所处的行的末尾换到新行开始编辑

加入export命令:

export SPARK_HOME=~/hadoop/spark

export PATH=$PATH:~/hadoop/spark/bin按 :wq 保存编辑并退出

完成编辑后,使用source命令强制在当前终端加载配置文件

source ~/.bashrc之后启动的终端无需强制加载,但是在source命令之前启动的终端都要强制加载

5. 启动spark-shell

配置环境变量后,可以在任意路径下启动 spark-shell

不配置环境变量,直接启动spark-shell:

cd ~/hadoop/spark

bin/spark-shell6. 命令脚本

虚拟环境下可以直接运行以下命令完成安装:

# 设置提示符:export PS1="\e[0;32m[\u:\w]\$ \e[0m"

sudo yum install wget git maven

mkdir ~/hadoop

cd ~/hadoop

wget "https://archive.apache.org/dist/spark/spark-3.1.1/spark-3.1.1-bin-hadoop3.2.tgz"

tar -xzvf spark-3.1.1-bin-hadoop3.2.tgz -C ~/hadoop/

mv ~/hadoop/spark-3.1.1-bin-hadoop3.2/ ~/hadoop/spark

export SPARK_HOME=~/hadoop/spark

export PATH=$PATH:~/hadoop/spark/bin原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录