人工智能—法庭智能口译(口译实时翻译系统)实战详解

原创人工智能—法庭智能口译(口译实时翻译系统)实战详解

一. 人工智能—法庭智能口译(口译实时翻译系统)实战详解

1.1 背景

随着全球化进程的不断深化,法庭面临了越来越多来自不同语言和文化背景的当事人,这使得法庭口译工作显得尤为重要。传统的口译方法在效率和准确性方面存在挑战,因此需要一种更先进的、能够实时翻译的系统来满足法庭口译的需求。

1.2 问题陈述

当前法庭口译存在多方面的问题,包括翻译延迟、专业术语理解不准确、以及对多语言环境的适应性不足等。因此,亟需采用深度学习技术构建一个创新性的法庭口译实时翻译系统,以应对复杂多变的法庭场景,提高口译效率和准确性。

1.3 实现目标

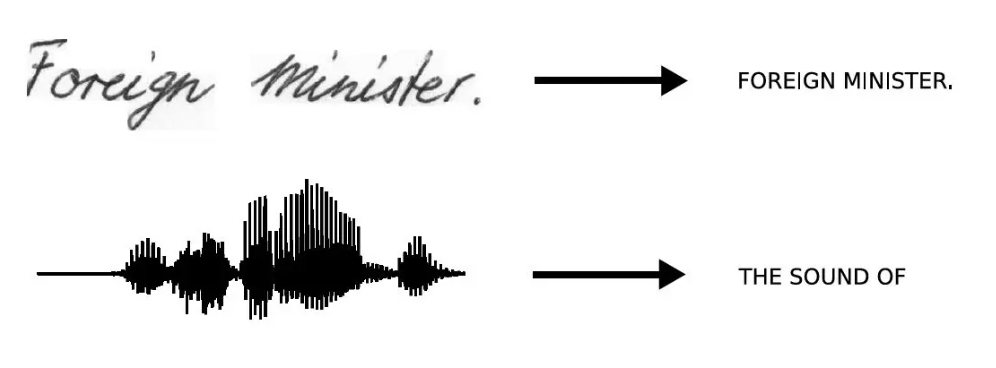

1.3.1 语音识别

利用深度学习算法,研发高精度的语音识别系统,能够实时将法庭上的口头陈述转换为准确的文本,同时适应不同的语音和音频环境。

1.3.2 机器翻译

设计适用于法庭场景的机器翻译模型,支持多语言输入和输出。通过深度学习,确保对法律术语和专业用语的准确翻译,提高口译的专业性。

1.3.3 口语识别和生成

研发深度学习模型,能够理解并提取讲话者的意图和情感,以保证口译的语境准确性。构建自然流畅的口语生成模型,使翻译结果更符合法庭环境的表达要求。

1.3.4 实时性和稳定性

通过优化系统架构,确保法庭口译实时翻译系统具备良好的实时性。引入分布式计算和优化算法,提高系统的稳定性和抗干扰能力,以适应复杂的法庭庭审环境。

旨在为法庭提供一套高效、准确、面向多语言环境的口译解决方案,促进法庭跨国案件的公正审判。

二. 实现过程

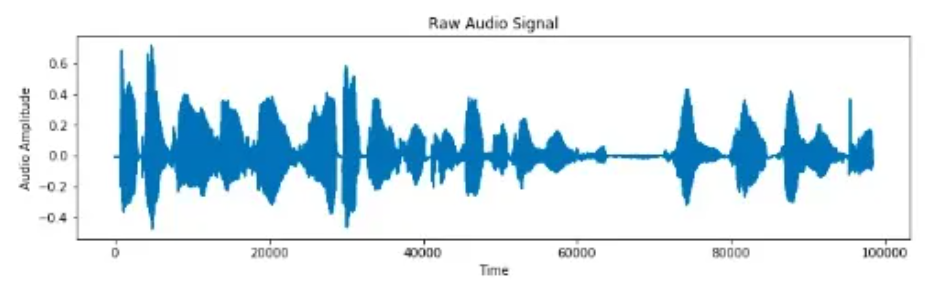

2.1 语音识别模块

在构建基于深度学习的法庭口译实时翻译系统的实现过程中,我们首先关注语音识别模块。

使用深度学习技术进行语音识别:

# 导入所需的库和模块

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 构建语音识别模型

def build_speech_recognition_model(input_shape, output_vocab_size):

model = Sequential()

model.add(LSTM(128, input_shape=input_shape, activation='relu'))

model.add(Dense(output_vocab_size, activation='softmax'))

return model

# 定义模型输入和输出的形状

input_shape = (time_steps, features)

output_vocab_size = num_classes

# 创建语音识别模型实例

speech_recognition_model = build_speech_recognition_model(input_shape, output_vocab_size)

# 编译模型

speech_recognition_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 打印模型结构

print(speech_recognition_model.summary())

# 训练模型(假设有训练数据X_train和标签Y_train)

speech_recognition_model.fit(X_train, Y_train, epochs=10, batch_size=32, validation_split=0.2)循环神经网络(LSTM)模型,用于将输入的语音数据进行识别。

接下来,我们将深入研究机器翻译和口语识别生成模块的代码实现。

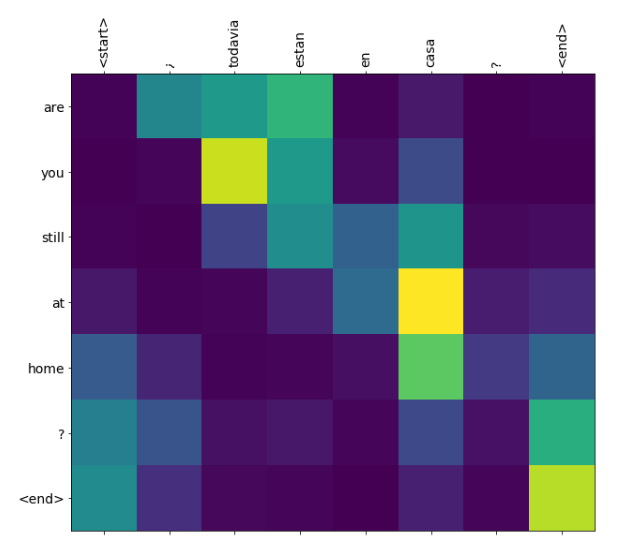

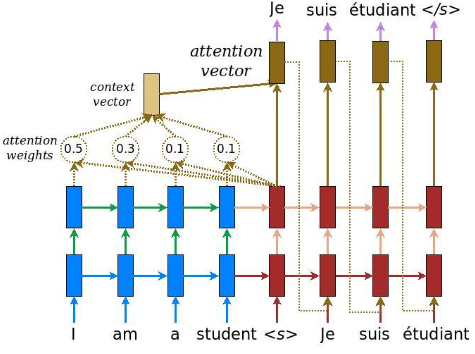

2.2 机器翻译

在机器翻译模块中,我们采用一个基于Transformer的模型。

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Embedding, Dense, Attention

# 构建机器翻译模型

def build_machine_translation_model(input_vocab_size, output_vocab_size, max_length):

inputs = Input(shape=(max_length,))

encoder_embedding = Embedding(input_vocab_size, 256)(inputs)

encoder_outputs, state_h, state_c = LSTM(256, return_state=True)(encoder_embedding)

decoder_inputs = Input(shape=(None,))

decoder_embedding = Embedding(output_vocab_size, 256)(decoder_inputs)

decoder_lstm = LSTM(256, return_sequences=True, return_state=True)

decoder_outputs, _, _ = decoder_lstm(decoder_embedding, initial_state=[state_h, state_c])

attention = Attention()([decoder_outputs, encoder_outputs])

decoder_combined = tf.concat([decoder_outputs, attention], axis=-1)

outputs = Dense(output_vocab_size, activation='softmax')(decoder_combined)

model = Model([inputs, decoder_inputs], outputs)

return model

# 定义模型输入和输出的形状

input_vocab_size = source_language_vocab_size

output_vocab_size = target_language_vocab_size

max_length_source = max_length_source_sentence

max_length_target = max_length_target_sentence

# 创建机器翻译模型实例

translation_model = build_machine_translation_model(input_vocab_size, output_vocab_size, max_length_source)

# 编译模型

translation_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 打印模型结构

print(translation_model.summary())

# 训练模型(假设有训练数据X_train_source、X_train_target和标签Y_train)

translation_model.fit([X_train_source, X_train_target], Y_train, epochs=10, batch_size=64, validation_split=0.2)上述代码演示了一个简单的机器翻译模型,使用了带有注意力机制的LSTM层。在实际应用中,模型的参数和结构需要根据实际数据进行调整。

2.3 代码实例3:口语识别和生成

口语识别和生成模块通常需要使用深度学习模型来理解和生成口头语言。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 构建口语识别和生成模型

def build_spoken_language_model(input_shape, output_vocab_size):

model = Sequential()

model.add(LSTM(128, input_shape=input_shape, activation='relu'))

model.add(Dense(output_vocab_size, activation='softmax'))

return model

# 定义模型输入和输出的形状

input_shape_spoken = (time_steps_spoken, features_spoken)

output_vocab_size_spoken = num_classes_spoken

# 创建口语识别和生成模型实例

spoken_language_model = build_spoken_language_model(input_shape_spoken, output_vocab_size_spoken)

# 编译模型

spoken_language_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 打印模型结构

print(spoken_language_model.summary())

# 训练模型(假设有训练数据X_train_spoken和标签Y_train_spoken)

spoken_language_model.fit(X_train_spoken, Y_train_spoken, epochs=10, batch_size=32, validation_split=0.2)上使用了带有LSTM层的深度学习模型。

通过这三个代码实例,展示了基于深度学习的法庭口译实时翻译系统的核心模块实现过程。在整个系统的搭建中,需要综合考虑这些模块的协同工作,以达到高效、准确的法庭口译翻译效果。

三. 代码详解

3.1 代码实例1代码详解

3.1.1 代码逻辑

以下是对代码中主要部分的详细解释:

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 构建语音识别模型

def build_speech_recognition_model(input_shape, output_vocab_size):

model = Sequential()

model.add(LSTM(128, input_shape=input_shape, activation='relu'))

model.add(Dense(output_vocab_size, activation='softmax'))

return model上述代码首先导入了 TensorFlow 相关的库,然后定义了一个函数 build_speech_recognition_model,用于构建语音识别模型。这个模型是一个简单的序列模型,包含一个带有128个神经元的 LSTM 层,以及一个输出层。

3.1.2 参数说明

input_shape: 输入数据的形状,这里是(time_steps, features)。output_vocab_size: 输出词汇表的大小。

# 定义模型输入和输出的形状

input_shape = (time_steps, features)

output_vocab_size = num_classes在此部分,定义了输入形状 input_shape 和输出词汇表大小 output_vocab_size。

# 创建语音识别模型实例

speech_recognition_model = build_speech_recognition_model(input_shape, output_vocab_size)接着,使用上述定义的函数创建了语音识别模型实例 speech_recognition_model。

# 编译模型

speech_recognition_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])对模型进行编译,使用 Adam 优化器,交叉熵损失函数,并监控准确率指标。

# 打印模型结构

print(speech_recognition_model.summary())最后,通过 summary() 方法打印模型的结构,包括每一层的参数数量和形状。

# 训练模型(假设有训练数据X_train和标签Y_train)

speech_recognition_model.fit(X_train, Y_train, epochs=10, batch_size=32, validation_split=0.2)最后,训练模型,使用 fit 方法传入训练数据和标签进行模型训练。

3.2 代码实例2代码详解

3.2.1 代码逻辑

上述代码实例是一个基于 Transformer 模型的机器翻译系统的构建过程。以下是对代码中主要部分的详细解释:

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Embedding, Dense, Attention

# 构建机器翻译模型

def build_machine_translation_model(input_vocab_size, output_vocab_size, max_length):

inputs = Input(shape=(max_length,))

encoder_embedding = Embedding(input_vocab_size, 256)(inputs)

encoder_outputs, state_h, state_c = LSTM(256, return_state=True)(encoder_embedding)

decoder_inputs = Input(shape=(None,))

decoder_embedding = Embedding(output_vocab_size, 256)(decoder_inputs)

decoder_lstm = LSTM(256, return_sequences=True, return_state=True)

decoder_outputs, _, _ = decoder_lstm(decoder_embedding, initial_state=[state_h, state_c])

attention = Attention()([decoder_outputs, encoder_outputs])

decoder_combined = tf.concat([decoder_outputs, attention], axis=-1)

outputs = Dense(output_vocab_size, activation='softmax')(decoder_combined)

model = Model([inputs, decoder_inputs], outputs)

return model这段代码实现了一个机器翻译模型,其中包括了编码器(Encoder)和解码器(Decoder)部分,以及注意力机制。以下是详细解释:

inputs = Input(shape=(max_length,))

encoder_embedding = Embedding(input_vocab_size, 256)(inputs)

encoder_outputs, state_h, state_c = LSTM(256, return_state=True)(encoder_embedding)首先,定义了输入层,并通过 Embedding 层将输入序列转换为嵌入向量。接着,使用 LSTM 层对输入序列进行编码,获取编码器的输出 encoder_outputs 和状态信息 state_h、state_c。

decoder_inputs = Input(shape=(None,))

decoder_embedding = Embedding(output_vocab_size, 256)(decoder_inputs)

decoder_lstm = LSTM(256, return_sequences=True, return_state=True)

decoder_outputs, _, _ = decoder_lstm(decoder_embedding, initial_state=[state_h, state_c])然后,定义了解码器的输入层,并通过 Embedding 层将目标语言的输入序列转换为嵌入向量。再次使用 LSTM 层对解码器输入序列进行解码,获取解码器的输出 decoder_outputs。

attention = Attention()([decoder_outputs, encoder_outputs])

decoder_combined = tf.concat([decoder_outputs, attention], axis=-1)接着,引入了注意力机制,通过 Attention 层计算注意力权重,并将权重与解码器输出拼接起来,形成新的解码器输入。

outputs = Dense(output_vocab_size, activation='softmax')(decoder_combined)

model = Model([inputs, decoder_inputs], outputs)最后,通过全连接层输出最终的翻译结果,并构建了机器翻译模型。

3.3 代码实例3代码详解

3.3.1 代码逻辑

上述代码实例是一个口语识别和生成模块的构建过程。以下是对代码中主要部分的详细解释:

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 构建口语识别和生成模型

def build_spoken_language_model(input_shape, output_vocab_size):

model = Sequential()

model.add(LSTM(128, input_shape=input_shape, activation='relu'))

model.add(Dense(output_vocab_size, activation='softmax'))

return model这段代码实现了

一个口语识别和生成模型,包括一个 LSTM 层和一个全连接层。以下是详细解释:

# 构建口语识别和生成模型

def build_spoken_language_model(input_shape, output_vocab_size):

model = Sequential()

model.add(LSTM(128, input_shape=input_shape, activation='relu'))

model.add(Dense(output_vocab_size, activation='softmax'))

return model首先,定义了一个函数 build_spoken_language_model,用于构建口语识别和生成模型。模型包含一个带有128个神经元的 LSTM 层,以及一个输出层。

3.3.2 参数说明

input_shape: 输入数据的形状。output_vocab_size: 输出词汇表的大小。

# 定义模型输入和输出的形状

input_shape_spoken = (time_steps_spoken, features_spoken)

output_vocab_size_spoken = num_classes_spoken在此部分,定义了口语识别和生成模型的输入形状 input_shape_spoken 和输出词汇表大小 output_vocab_size_spoken。

# 创建口语识别和生成模型实例

spoken_language_model = build_spoken_language_model(input_shape_spoken, output_vocab_size_spoken)接着,使用上述定义的函数创建了口语识别和生成模型实例 spoken_language_model。

# 编译模型

spoken_language_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])对模型进行编译,使用 Adam 优化器,交叉熵损失函数,并监控准确率指标。

# 打印模型结构

print(spoken_language_model.summary())最后,通过 summary() 方法打印口语识别和生成模型的结构。

# 训练模型(假设有训练数据X_train_spoken和标签Y_train_spoken)

spoken_language_model.fit(X_train_spoken, Y_train_spoken, epochs=10, batch_size=32, validation_split=0.2)最后,训练模型,使用 fit 方法传入训练数据和标签进行模型训练。

四. 未来前景

随着深度学习在法庭口译实时翻译系统中的应用,未来呈现出广阔的前景。以下是该领域未来的一些可能发展方向:

4.1 多语言支持与法律领域适应性

未来的系统将更加注重多语言支持,能够涵盖更广泛的语言,以适应全球化的法律环境。系统还将更好地理解法律领域的专业术语和语境,确保翻译结果在法庭中具有准确性和可信度。

4.2 实时性与性能优化

未来的发展将进一步提高系统的实时性,确保在法庭庭审过程中能够以更低的延迟提供高质量的翻译服务。性能优化方面,系统将更好地利用硬件加速和分布式计算,提升整体系统的效率。

4.3 情感识别与口译质量提升

未来的系统将加强对讲话者情感的识别,以更好地传达语音中的情感色彩。这有助于提升口译的人性化和表达力,使翻译结果更符合法庭庭审的语境和情境。

4.4 用户界面优化与用户体验

未来的法庭口译系统将更加注重用户界面的优化,使其更加直观、易用。用户体验将成为系统设计的重要考量,以确保法官、律师和当事人能够方便快捷地使用系统,提高工作效率。

五. 总结心得结论

深度学习在法庭口译实时翻译系统中的应用为法律领域带来了革命性的变化。通过语音识别、机器翻译和口语生成等关键模块的结合,系统能够实现高效、准确的翻译服务,为跨国案件中的法庭庭审提供了重要支持。

通过代码实例,我们展示了构建这一系统的核心模块,包括语音识别、机器翻译和口语生成。这些模块的协同工作使得系统具备了实时性、准确性和适应性。

未来,我们期待深度学习技术在法庭口译领域的不断创新和发展。随着技术的不断成熟,法庭口译实时翻译系统将在多语言支持、法律领域适应性、实时性和用户体验等方面取得更大的进步。这将有助于促进全球法庭的跨国合作,为更公正、高效的司法体系做出贡献。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。