或许,我们并不需要Chinese-LLaMA3,构建高效Agent WorkFlow来合理利用大模型

或许,我们并不需要Chinese-LLaMA3,构建高效Agent WorkFlow来合理利用大模型

目前社区已经出现了用中文语料二次训练过的llama3项目,而且数量还不少。虽然开源社区的这种热情有利于更多人享受新模型带来的进步,但是,我心中有几个疑问,让我对这种情况持怀疑态度。

首先,争先恐后的训练Chinese-LLaMA3是否有炒作之嫌,为了抢先抢占中文版头把交椅,其训练质量,语料的合理性,安全性等等,是否能让人信服?其次,中文语料和英文语料在知识层面是否重叠,基于训练团队的语料质量,能否让最终的结果在中文上拥有和英文相同的先进性?这里其实我一直有一个疑问,如果理论上llama3的能力可以用一个分值来评估,那么是否意味着任何团队做的中文训练,是否都应该在最终结果上获得相同的评分?最后,我们是否真的一定需要中文版的llama3,是不是非中文版的就无法在我们实际使用中完成我们的目标呢?中文训练后的模型,在性能上是否能够保持原始模型一致性?

就我自己的看法而言,我认为,现在已经是2024年了,我们不一定真的需要一个Chinese-LLaMA3。

在我之前看过的一篇文章中,研究团队发现,经过中文语料训练的模型,在中文交互下的表现效果,不如通过将中文prompt翻译为英文后获得的结果的效果好。

从感性认知上,我们也可以理解这种情况发生的原因。中文世界的语料无论是数量上还是质量上都不如英文世界语料,而且中文语料的训练结果和英文语料的训练结果,并不能像人脑的理解力一样,直接画等号。

我们可否通过应用架构的优化,来获得相同体验下的更优效果呢?其实我们只需要一个中文语境下的大模型作为中间Agent,让两个大模型配合起来实现我们的目标即可。

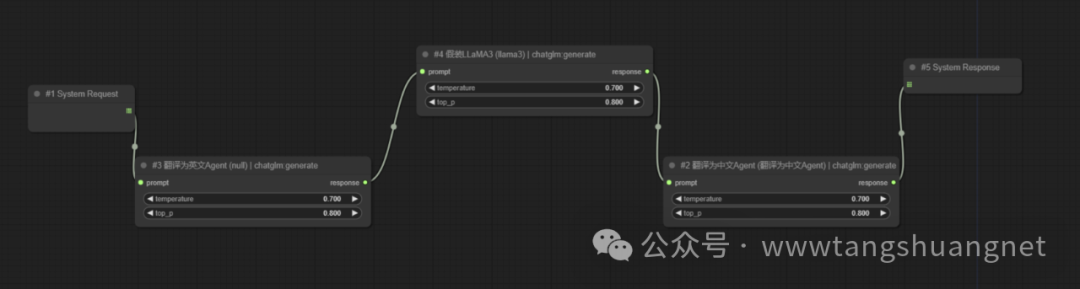

在适当的开发工具中,我们只需要搭建一个简单的workflow即可。

该workflow中有3个过程节点,前面翻译为英文,再传给llama3,拿到结果后再翻译为中文。

它包含两个LLM,其中llama3作为目标模型,另外我们需要一个在中英翻译方面比较强的大模型作为中介,根据当前业务场景,提供system prompt,使得它可以翻译出行业的专业术语。

在用户端,后台架构的变化对前端用户的影响几乎是不可见的,用户该怎么聊天,还是怎么聊天,在体验上毫无感知,但是在结果的表现上,却可以获得llama3的加持,拥有更强的智能。

基于相同的原理,将来出现更为强劲的大模型时,我们只需要替换workflow中的节点即可,而无需在应用后台做大规模的调整和开发。