llama3&open-webui快速实现本地模型搭建

原创前言

最近工作生活中经常使用一些人工智能来提升效率,用处最多的感觉还是写一些工具类,就算写的不如意,自己稍微调整也可以很快支持;再就是一些命令,有时长时间不用会淡忘,这时候有ai模型去提示感觉效率很高;

准备工作

本机参数

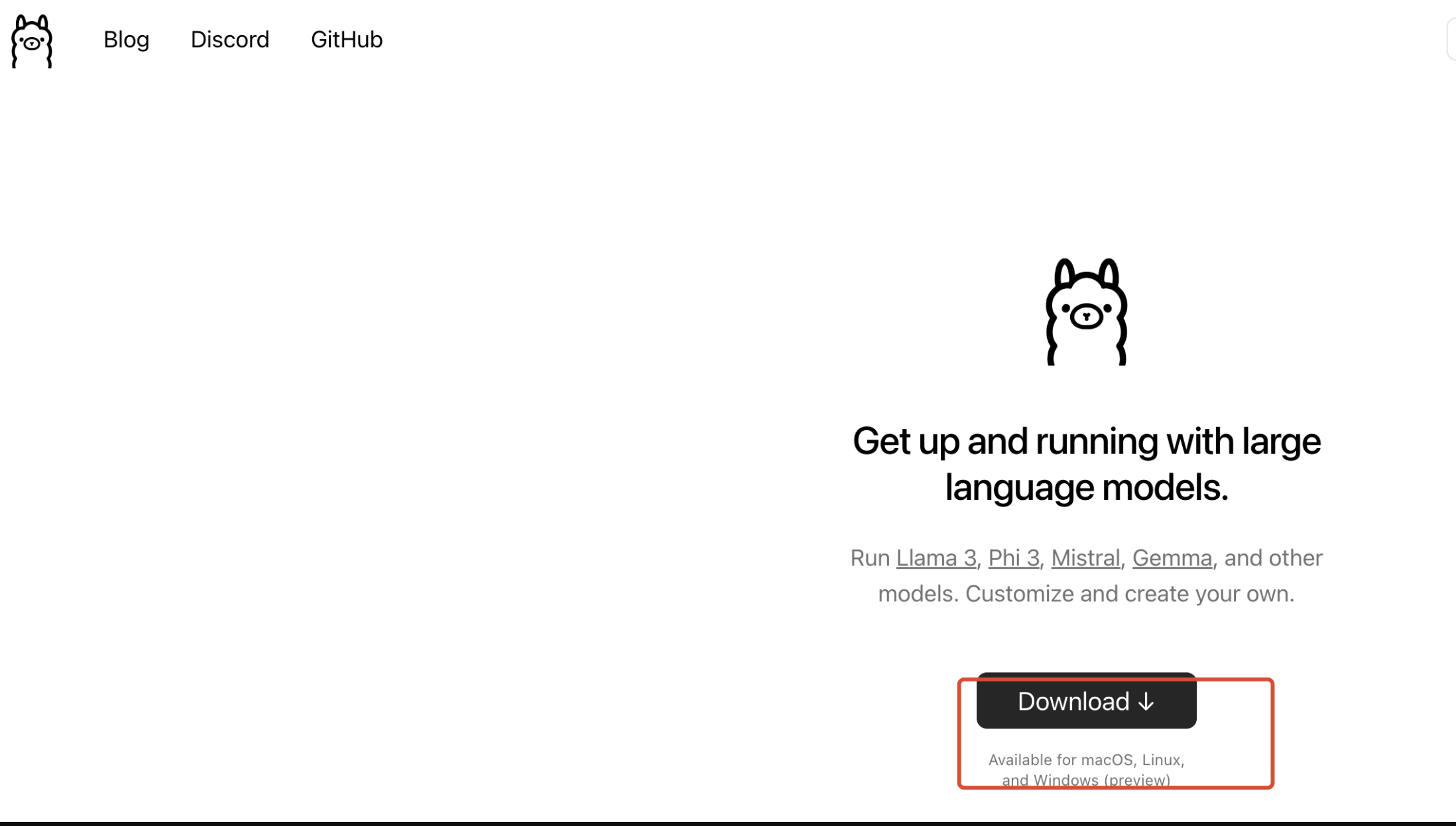

ollama下载

下载地址:https://ollama.com/

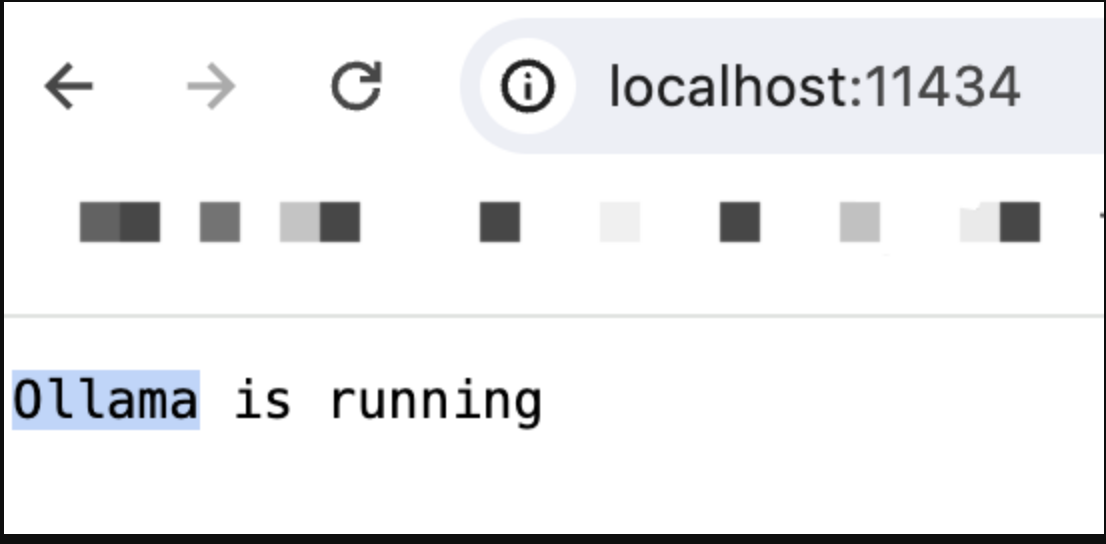

下载后直接一直无脑下一步就好,完成后访问http://localhost:11434/

成功访问看到running就表示运行成功了

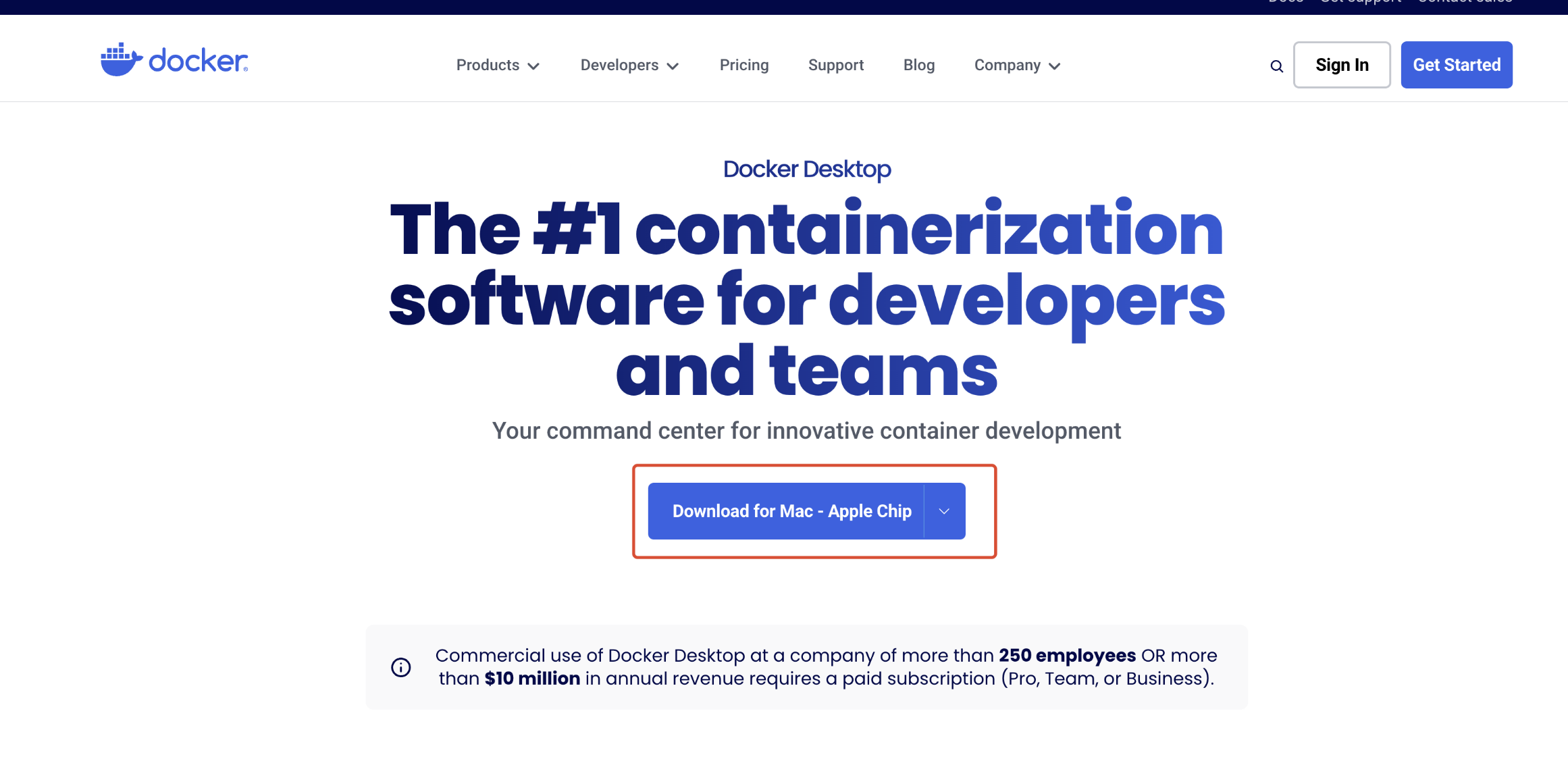

docker桌面下载

下载地址:https://www.docker.com/products/docker-desktop/

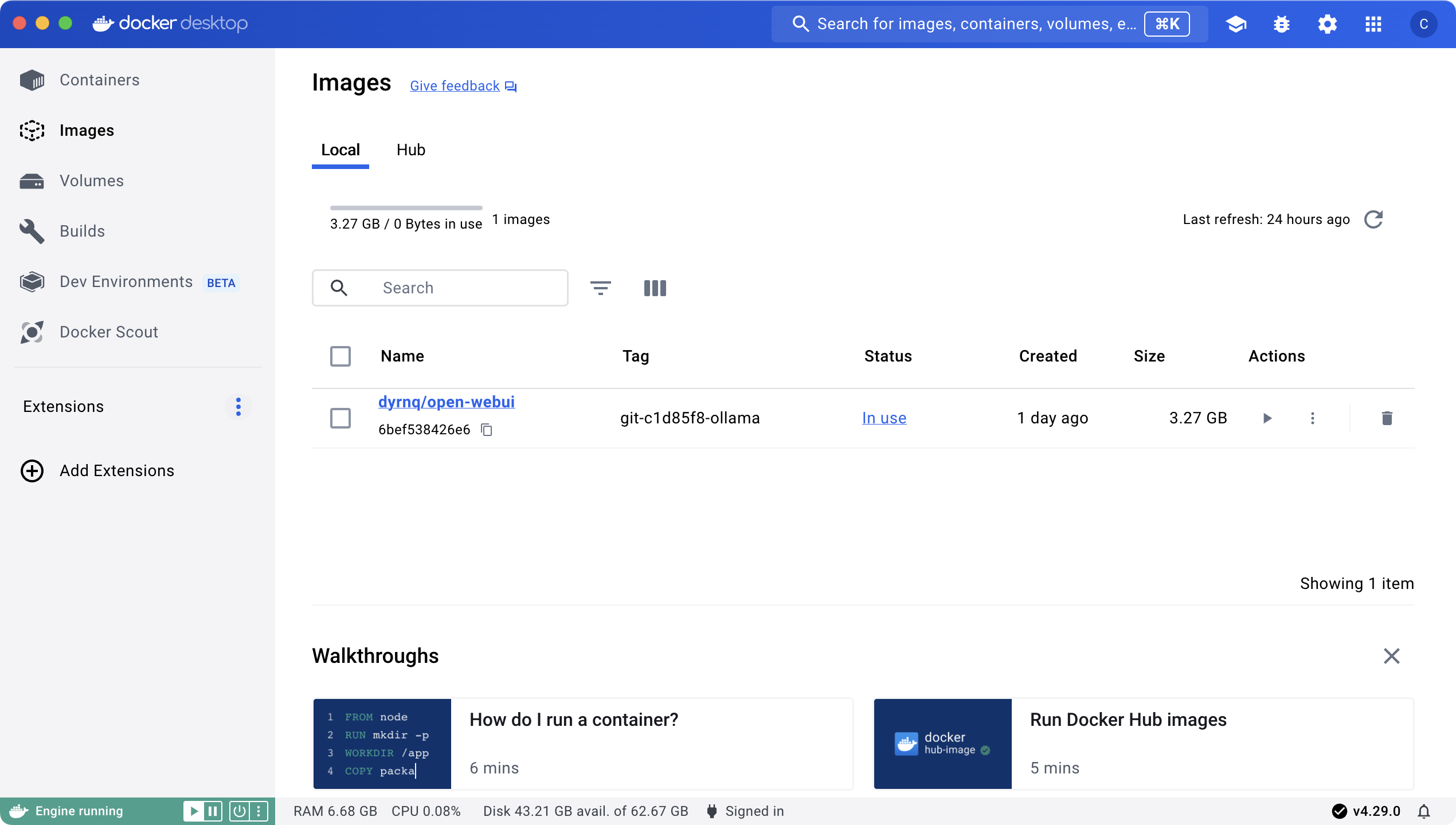

下载完成后启动运行,可以看到如下界面

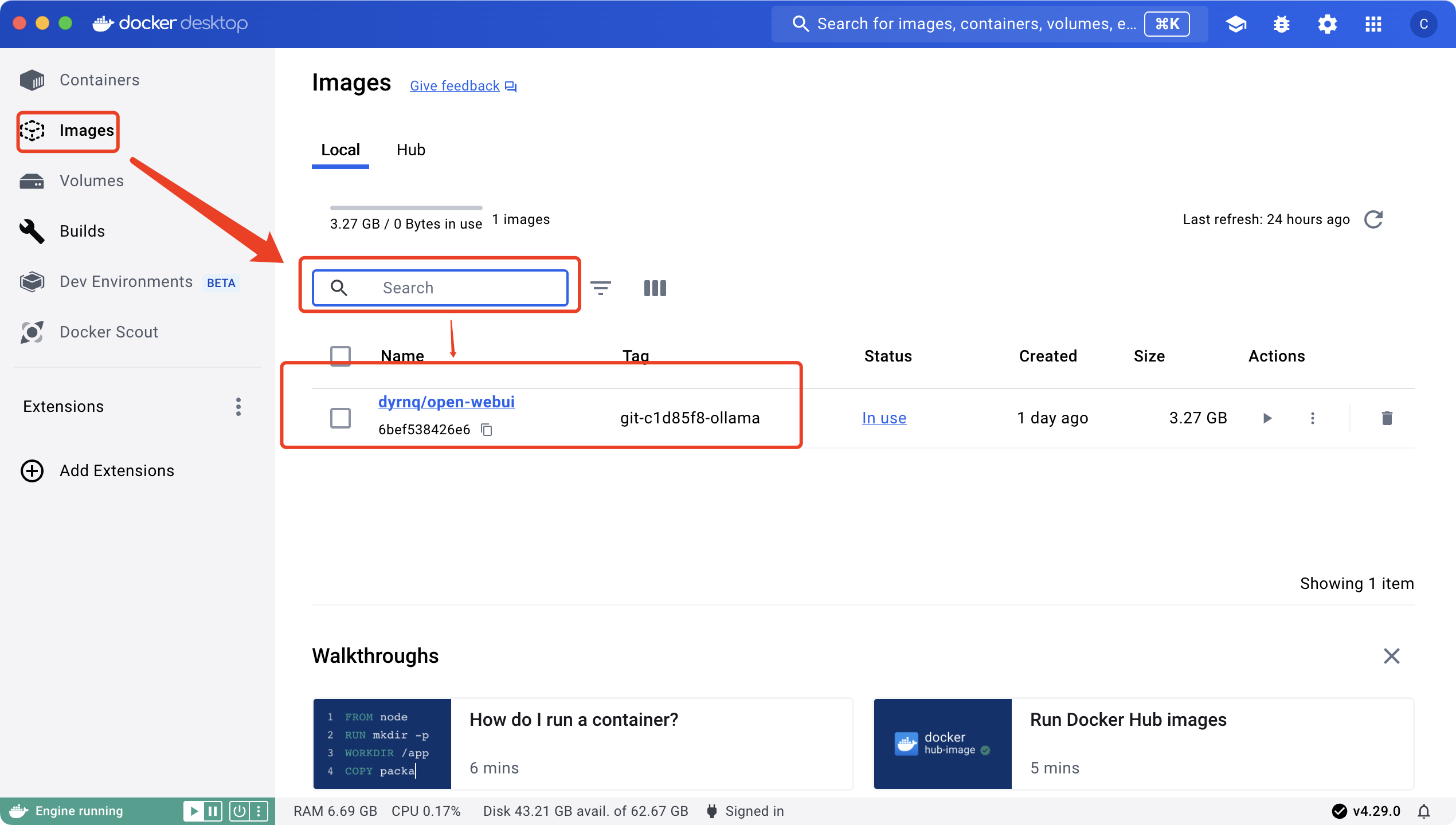

搜索框搜open-webui tag:找ollama版本即可,直接按照我图里的无脑搞就行

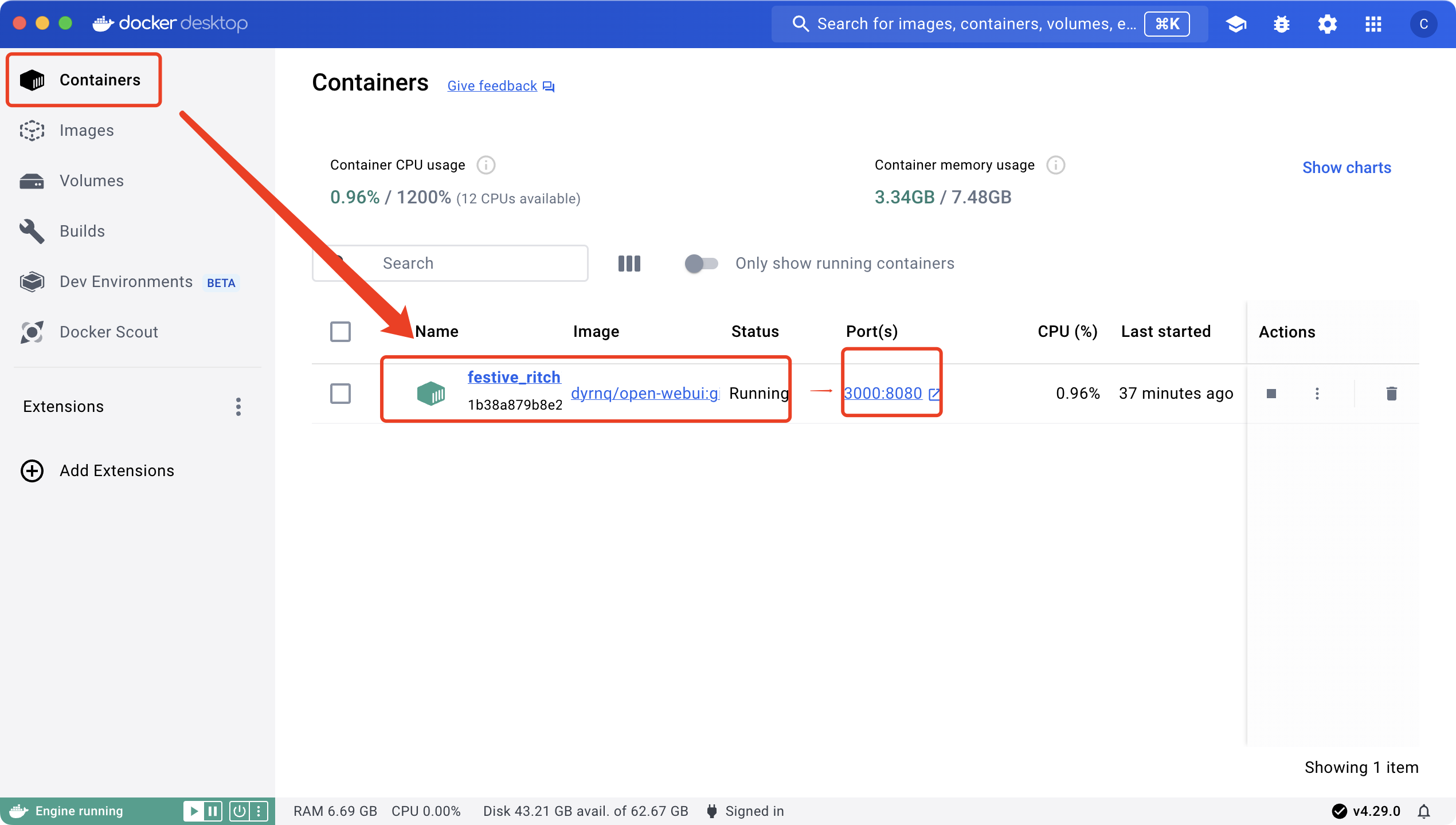

安装好镜像后,可以启动容器了

其他参数我没有修改,启动只是映射了下端口,容器启动成功后可以访问指定的3000端口:http://localhost:3000/

到这步基本准备工作就完成了大部分,但这里还只是一个空壳,没有模型还不能开始问答

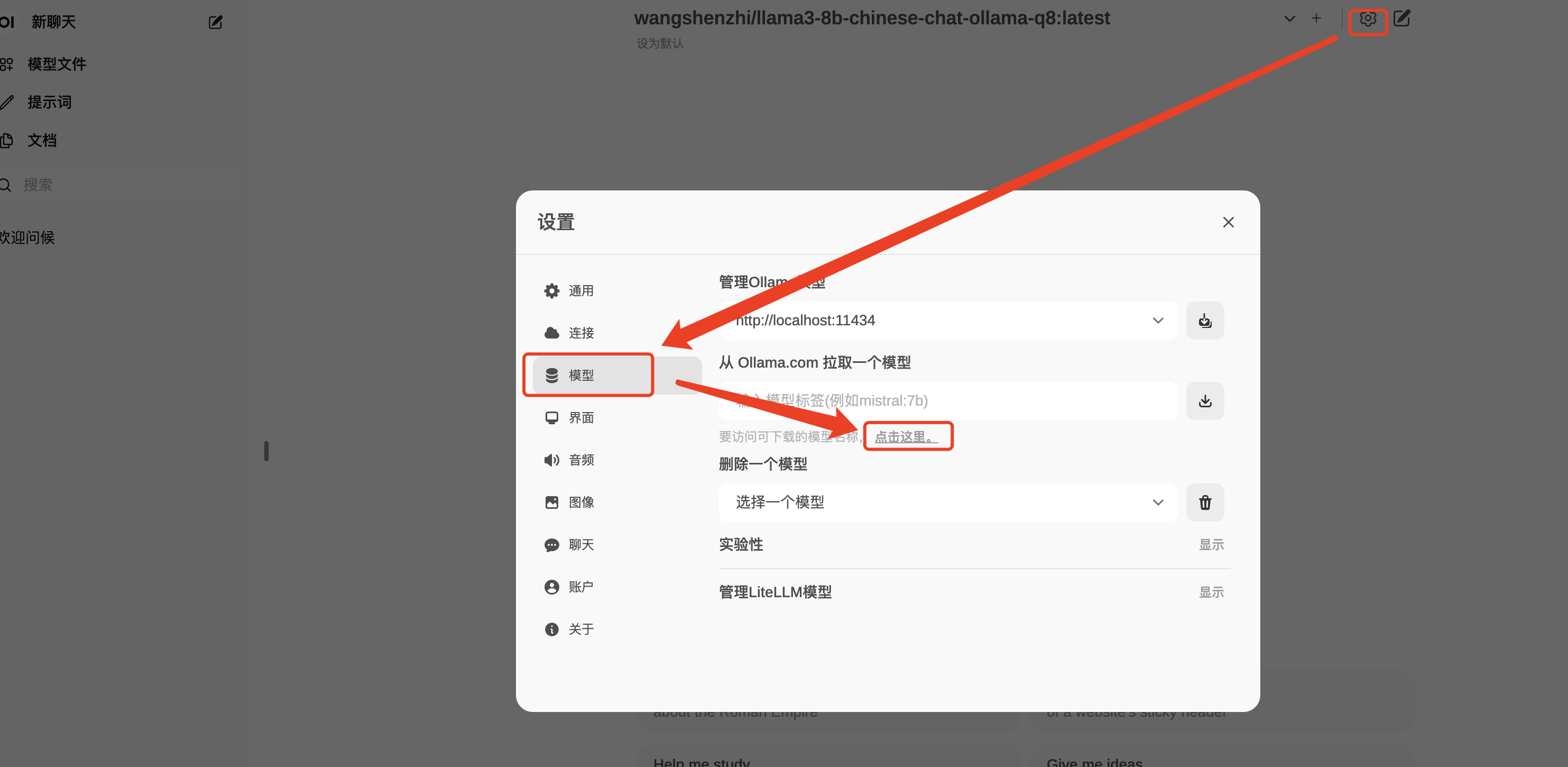

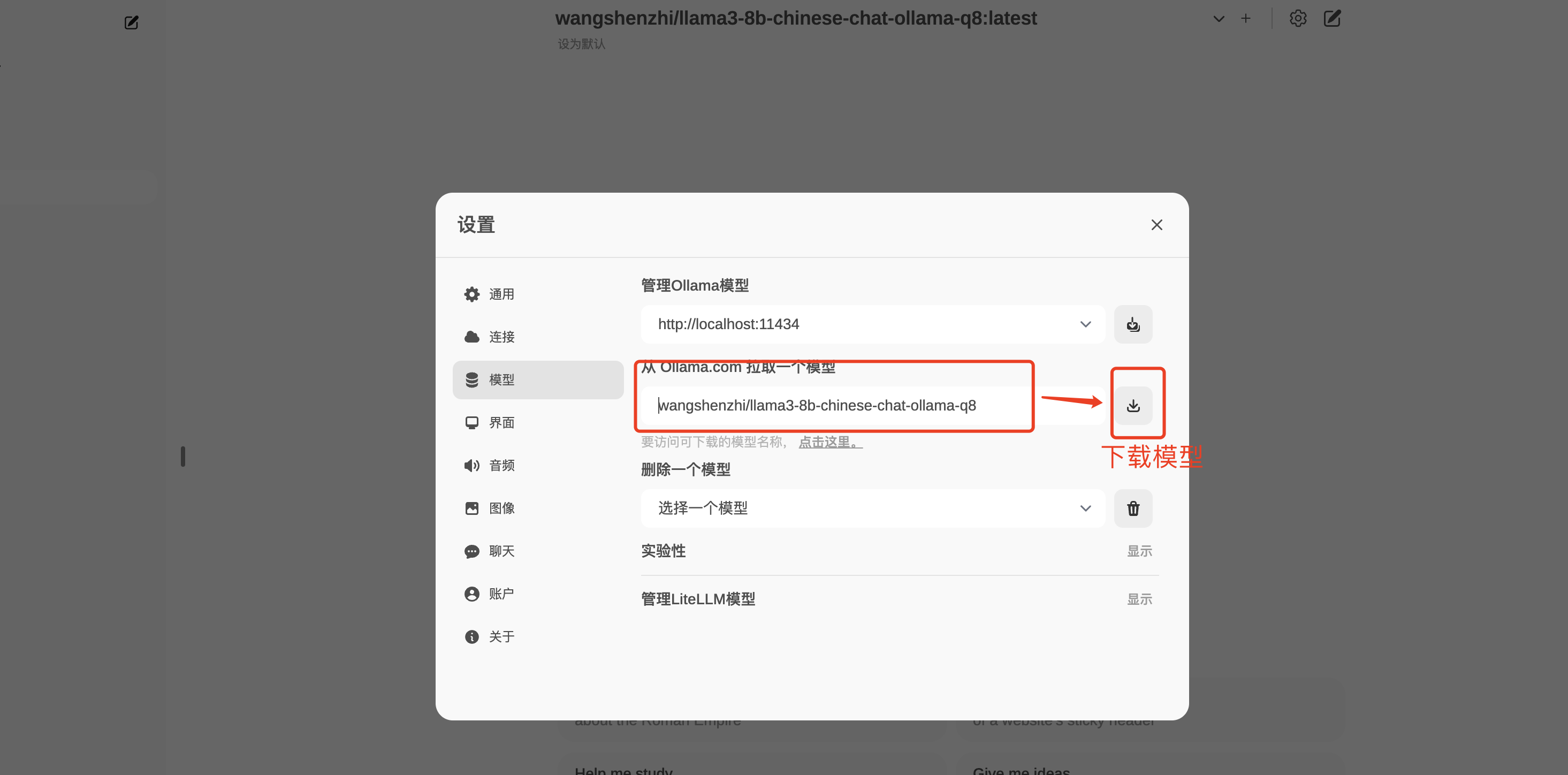

模型下载

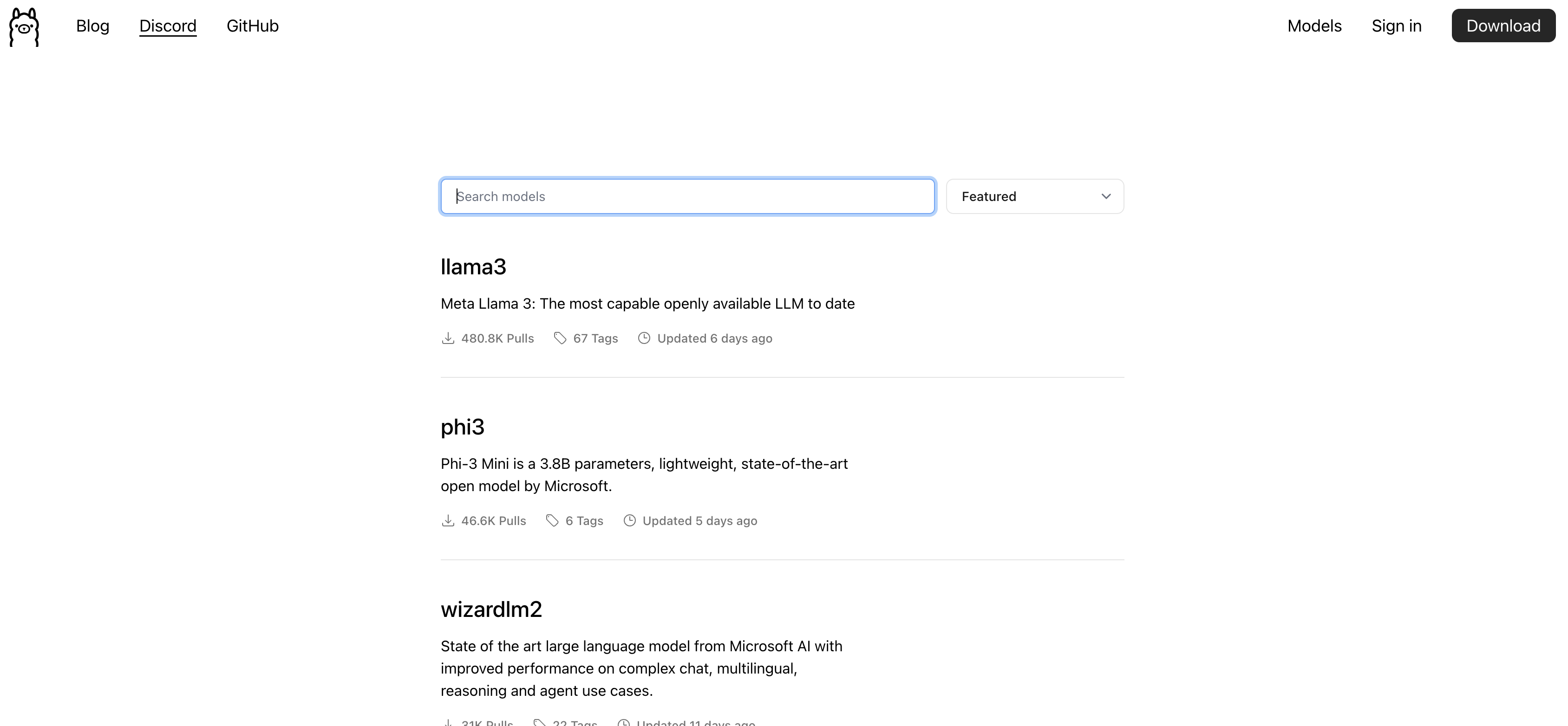

ollama提供了很充足的模型下载

点击这里可以找到很多有用的模型

可以搜索自己想要的模型测试,不过新出的llama3对中文支持还不是太好,大家可以直接搜索

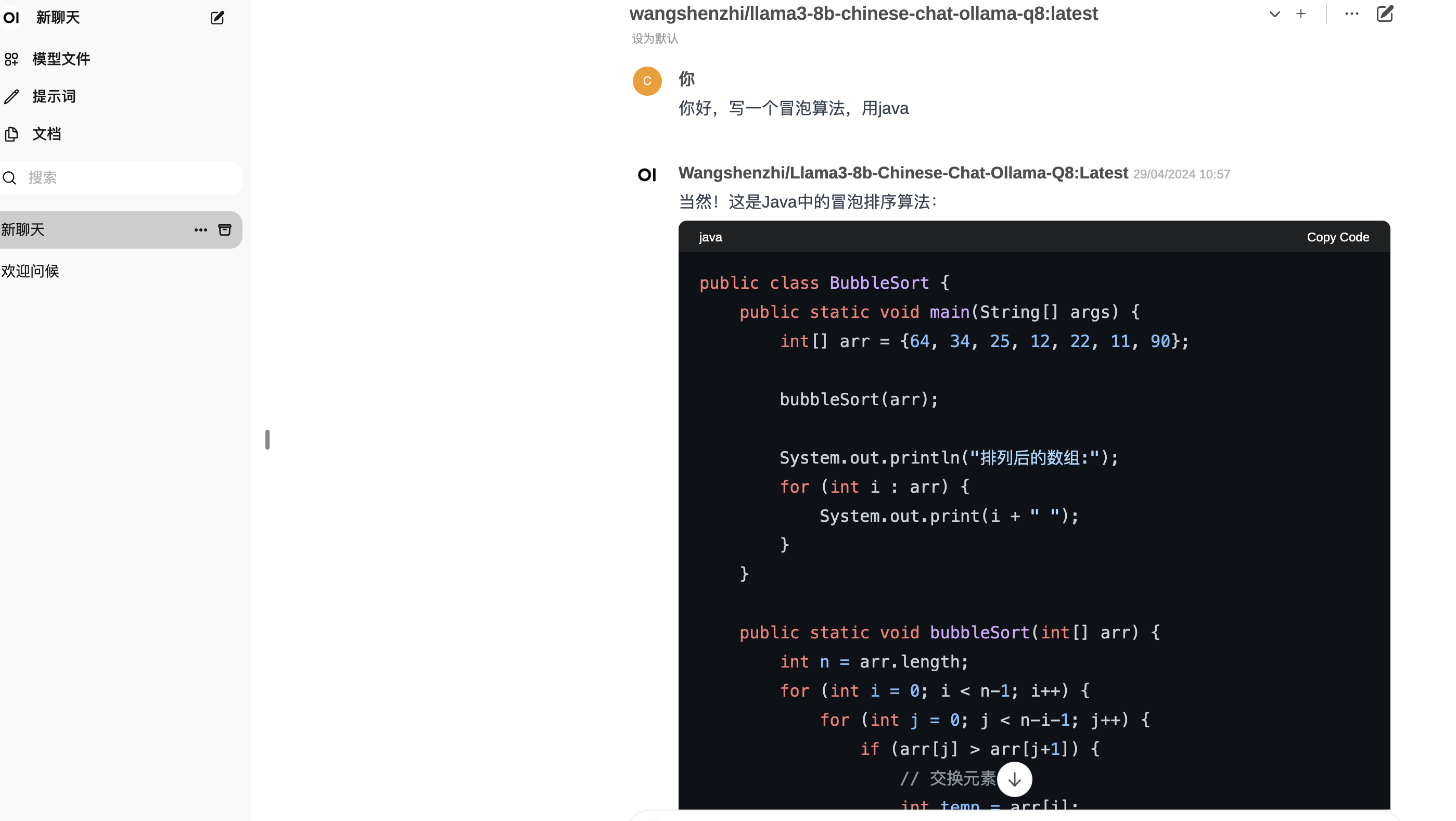

llama3-8b-chinese-chat-ollama-q8

这个模型是对llama3进行了中文微调后的模型,相对对中文比较友好

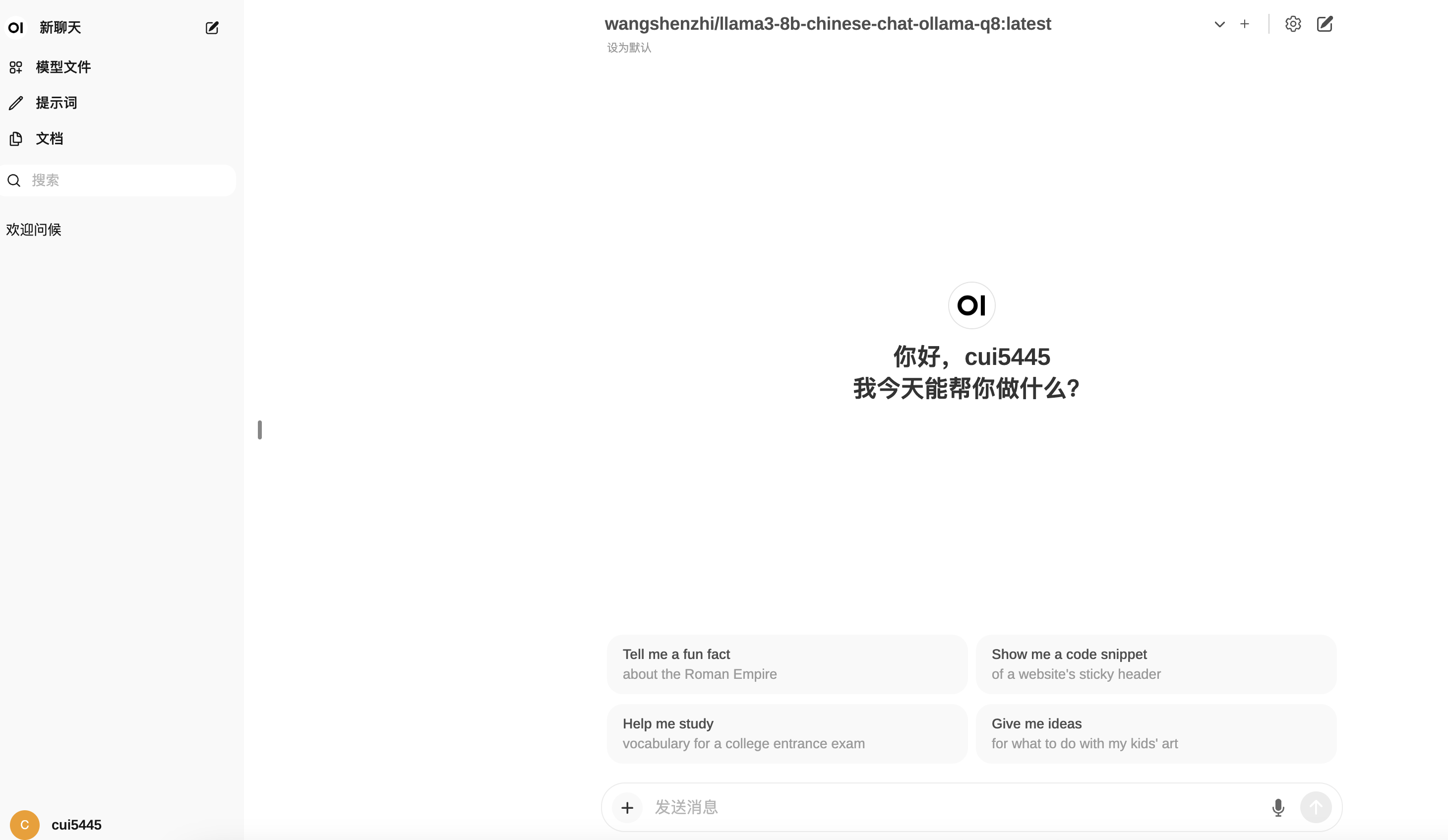

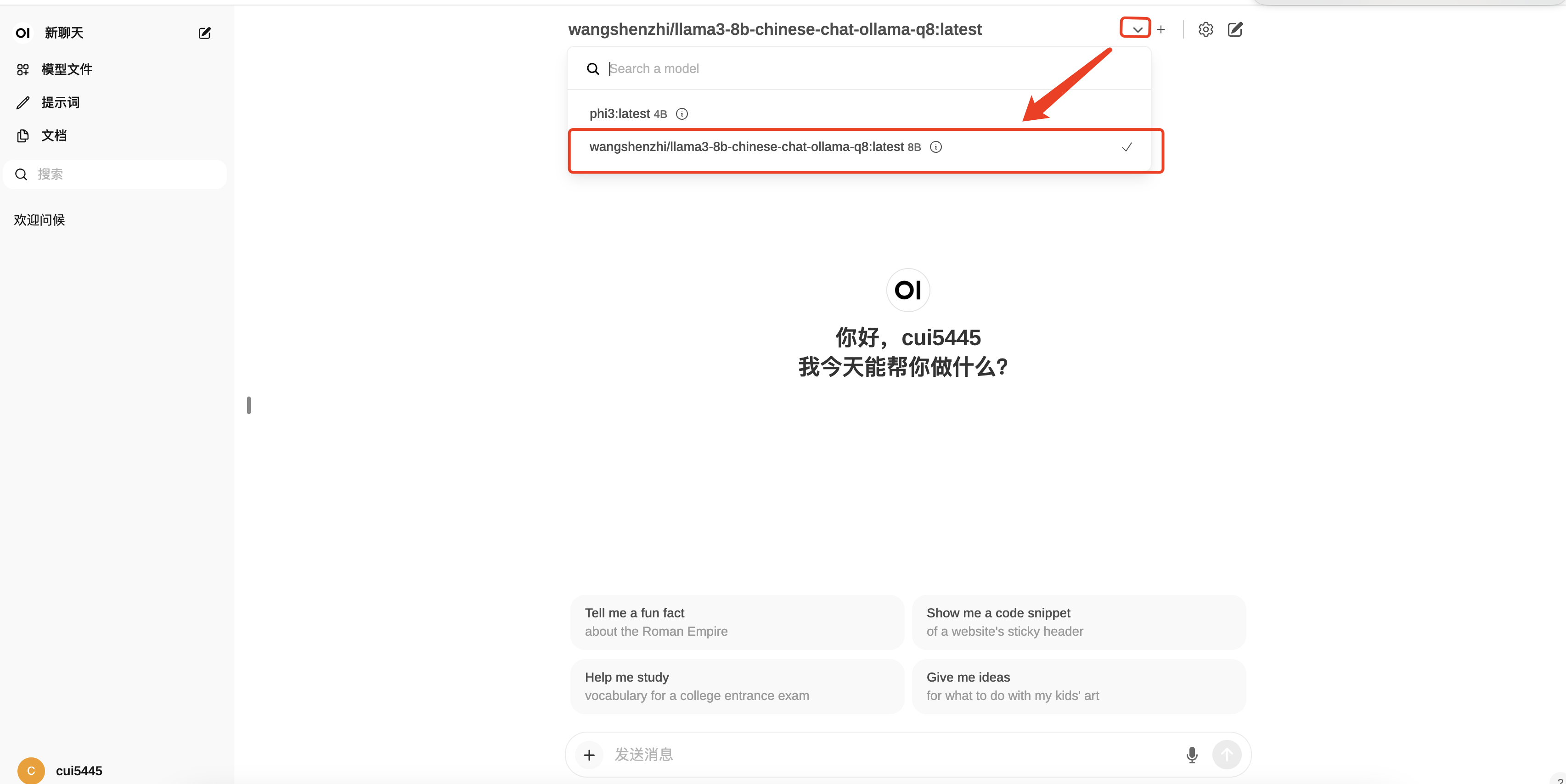

一般小型模型也得几个G,下载需要一会时间等待,下载完成在webui首页就可以选择开始使用了;

本地模型使用

可以看到首页下拉框中可以选择我们已经下载好的模型

开始本地模型测试,断网后也可以离线使用了,完全不用担心信息外泄,不过一般个人电脑也仅仅是运行起来,速度比较慢,只能满足下自己日常的好奇心,真正要投入生产还是需要一个不错的机器才行,自己也可以下一些响应速度更快的mini模型测试

接口调用的使用方式

以上展示了使用open-webui和Ollama联动使用的示例;

Ollama也提供接口直接调用的方式使用,方便二次开发:

curl http://localhost:11434/api/generate -d '{

"model": "phi3",

"prompt":"你好,写个冒泡"

}'总结

本地模型搭建基本能满足自己日常工作需求,只是速度相对比较慢,但胜在免费使用,如果公司有接口需求,也好扩展使用

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。