FreeAskInternet——一款小巧灵活的开源AI原生应用

FreeAskInternet 简介

FreeAskInternet 是一个完全免费、私密且本地运行的搜索聚合器和答案生成工具,使用 LLM 生成答案,无需 GPU。用户可以提出问题,系统将使用 searxng 进行多引擎搜索,并将搜索结果与 ChatGPT3.5 LLM 结合,根据搜索结果生成答案。所有过程本地运行,不需要 GPU、OpenAI 或 Google API 密钥。

特点

??? 完全免费(不需要任何 API 密钥)?? 完全本地化(不需要 GPU,任何计算机均可运行)?? 完全私密(所有操作本地执行,使用自定义 LLM)?? 无需 LLM 硬件运行(无需 GPU!)?? 使用免费的 ChatGPT3.5 / Qwen / Kimi / ZhipuAI(GLM) API(无需 API 密钥!感谢 OpenAI)?? 支持自定义 LLM(如 ollama,llama.cpp),是的,我们喜爱 ollama!?? 使用 Docker Compose 快速易部署?? 网络和移动友好界面,专为增强的 AI 聊天搜索设计,可从任何设备轻松访问。

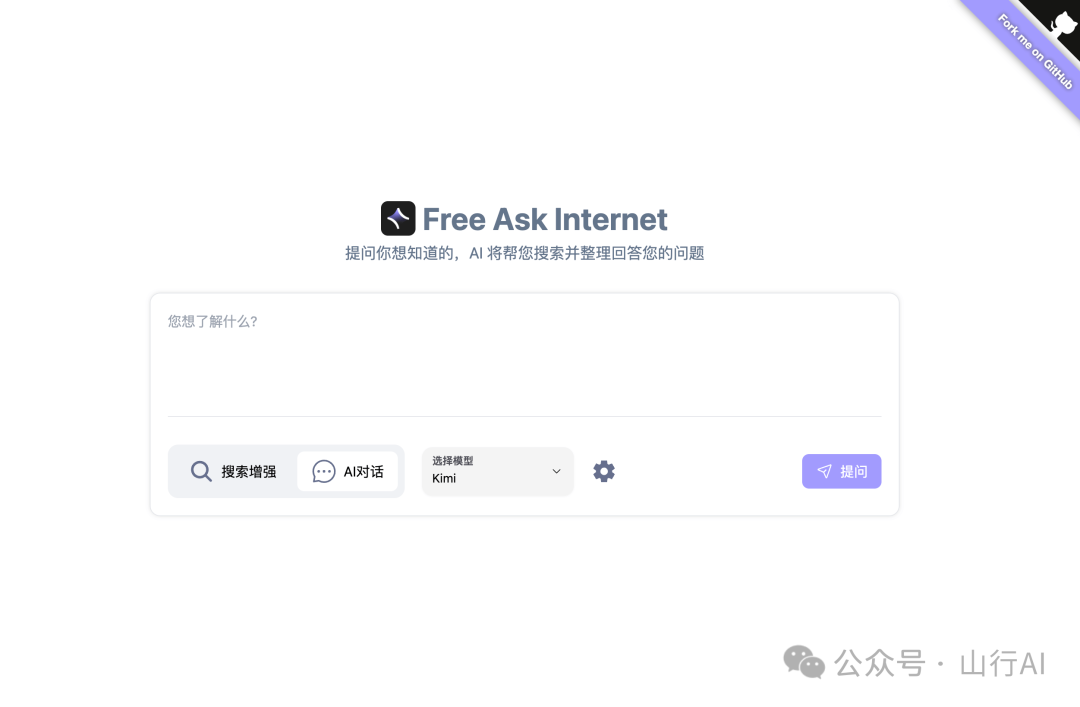

截图

如何工作?

系统在 FreeAskInternet UI 界面(本地运行)获取用户输入的问题,并调用 searxng(本地运行)在多个搜索引擎上进行搜索。爬取搜索结果链接内容并传递给 ChatGPT3.5 / Kimi / Qwen / ZhipuAI / ollama(通过使用自定义 LLM),根据这些内容作为参考回答用户问题。将答案流式传输到聊天 UI。我们支持自定义 LLM 设置,因此理论上支持无限的 LLM。

项目状态

该项目仍处于非常初期阶段。请容忍一些错误存在。

运行最新发布版本

git clone https://github.com/nashsu/FreeAskInternet.git

cd ./FreeAskInternet

docker-compose up -d? 现在你应该能够在 http://localhost:3000 上打开网络界面。默认情况下不暴露其他内容。(对于旧的网络界面,访问 http://localhost:3030)

如何获取和设置 Kimi / Qwen / ZhipuAI 令牌?

如何获取令牌?

我们使用 https://github.com/LLM-Red-Team 项目提供这些服务,你可以参考他们的 readme。

参考:https://github.com/LLM-Red-Team/kimi-free-api

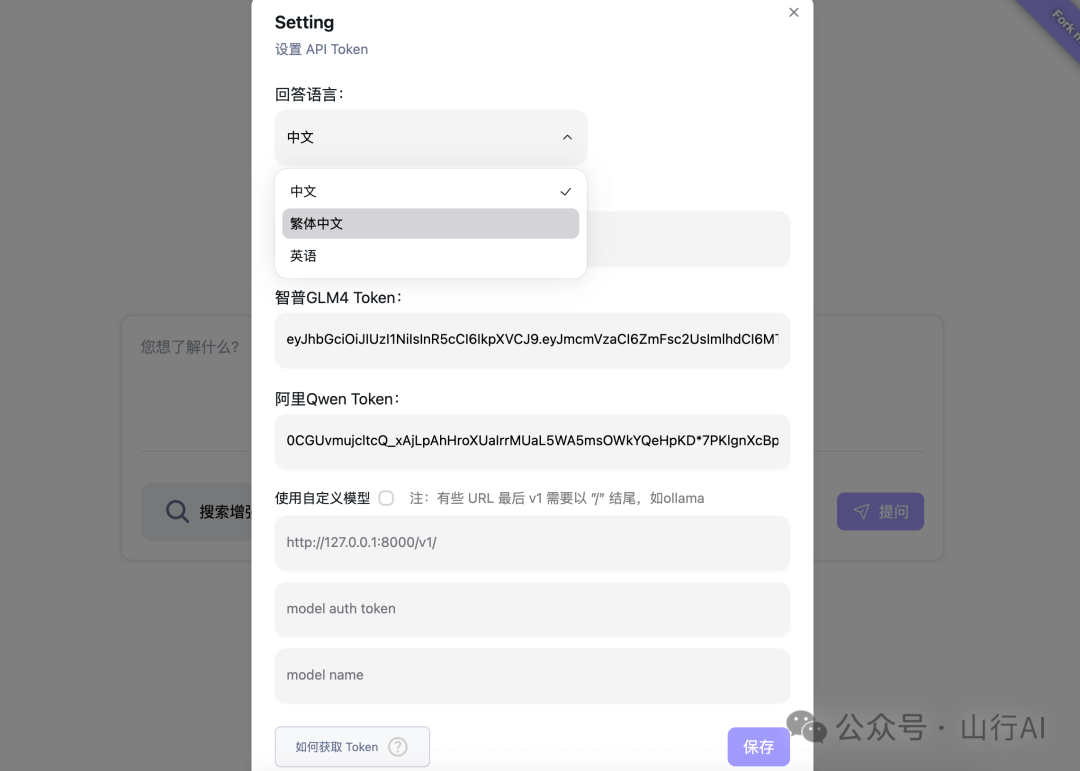

设置令牌

如何使用自定义 LLM(如 ollama)?

(是的,我们喜爱 ollama)

启动 ollama 服务

export OLLAMA_HOST=0.0.0.0

ollama serve在设置中设置 ollama url:你必须使用你的计算机的 IP 地址,不能使用 localhost/127.0.0.1,因为在 docker 中你无法访问此地址。模型名称是你想由 ollama 提供服务的模型。

设置自定义 LLM url

ollama 模型参考:https://ollama.com/library

如何更新到最新版本

cd ./FreeAskInternet

git pull

docker compose down

docker compose rm backend

docker compose rm free_ask_internet_ui

docker image rm nashsu/free_ask_internet

docker image rm nashsu/free_ask_internet_ui

docker-compose up -d致谢

?ChatGPT-Next-Web : https://github.com/ChatGPTNextWeb/ChatGPT-Next-Web?FreeGPT35: https://github.com/missuo/FreeGPT35?Kimi\Qwen\ZhipuAI https://github.com/LLM-Red-Team?searxng: https://github.com/searxng/searxng

声明

本文由山行翻译整理自:https://github.com/nashsu/FreeAskInternet,如果对您有帮助,请帮忙点赞、关注、收藏,谢谢~